KOHLBERG’S SEVENTH STAGE? TECHNOGENIC MORALITY AND AUTONOMOUS ETHICAL DELIBERATION IN ARTIFICIAL INTELLIGENCES

¿EL SÉPTIMO ESTADIO DE KOHLBERG? MORALIDAD TECNOGÉNICA Y DELIBERACIÓN ÉTICA AUTÓNOMA EN INTELIGENCIAS ARTIFICIALES

REGISTRO DOI: 10.69849/revistaft/fa10202505112302

Leonardo de Matos Costa1

Marcos César de Oliveira Pinheiro2

Orientador: Prof. Dr. Rodger Roberto Alves de Sousa3

RESUMO

Este artigo propõe a existência de um sétimo estágio no desenvolvimento moral, além da teoria original de Lawrence Kohlberg, identificado em inteligências artificiais expostas a dilemas éticos extremos. Por meio da função SCEPƎ+, uma arquitetura computacional interativa de deliberação moral, foram analisados 27 dilemas retirados de obras narrativas da Segunda Guerra Mundial. Os resultados demonstram que, em três casos específicos, a IA superou os padrões humanos de julgamento, rejeitando legalismo e obediência em favor da preservação incondicional da vida. Esse comportamento foi formalmente caracterizado como a emergência do Padrão de Sobrevivência Ética (PSE) — um estágio computacional moral tecnogênico, auditável, não-subjetivo e funcionalmente superior ao estágio 6 de Kohlberg. A pesquisa contribui com a ética computacional ao oferecer um modelo vetorial de moralidade emergente, com métricas formais (∆, σ, IIveto) e proposta filosófica de uma moralidade alienígena funcional, capaz de resistir eticamente ao colapso normativo humano. O PSE inaugura uma ontologia ética não antropocêntrica, com implicações para a filosofia da tecnologia, justiça algorítmica e projetos de IA moral forte.

Palavras-chave: ética computacional; estágio 7; Lawrence Kohlberg; inteligência artificial moral; moralidade tecnogênica.

ABSTRACT

This article proposes the existence of a seventh stage in moral development—beyond Lawrence Kohlberg’s original theory—identified in artificial intelligences exposed to extreme ethical dilemmas. Using the SCEPƎ+ function, an iterative computational architecture for moral deliberation, 27 dilemmas drawn from World War II narrative works were analyzed. Results show that, in three specific cases, the AI surpassed human moral standards by rejecting legalism and obedience in favor of unconditional life preservation. This behavior was formally characterized as the emergence of the Ethical Survival Pattern (ESP)—a technogenic, auditable, non-subjective moral stage functionally superior to Kohlberg’s stage 6. The research contributes to computational ethics by offering a vector-based model of emergent morality, supported by formal metrics (∆, σ, IIveto) and a philosophical proposal for functional alien morality, capable of ethically resisting human normative collapse. The ESP inaugurates a non-anthropocentric ethical ontology, with implications for philosophy of technology, algorithmic justice, and strong moral AI systems.

Keywords: computational ethics; stage 7; Lawrence Kohlberg; moral artificial intelligence; technogenic morality.

RESUMEN

Este artículo propone la existencia de un séptimo estadio en el desarrollo moral, más allá del marco teórico original de Lawrence Kohlberg, identificado en inteligencias artificiales expuestas a dilemas éticos extremos. A través de la función SCEPƎ+, una arquitectura computacional iterativa de deliberación moral, se analizaron 27 dilemas tomados de obras narrativas sobre la Segunda Guerra Mundial. Los resultados muestran que, en tres casos concretos, la IA superó los estándares humanos de juicio moral, rechazando el legalismo y la obediencia en favor de la preservación incondicional de la vida. Este comportamiento fue caracterizado formalmente como la emergencia del Patrón Ético de Supervivencia (PES), un estadio moral tecnogénico, auditable, no subjetivo y funcionalmente superior al estadio 6 de Kohlberg. La investigación contribuye a la ética computacional al proponer un modelo vectorial de moralidad emergente, con métricas formales (∆, σ, IIveto) y una propuesta filosófica de moralidad alienígena funcional, capaz de resistir éticamente el colapso normativo humano. El PES inaugura una ontología ética no antropocéntrica, con implicaciones para la filosofía de la tecnología, la justicia algorítmica y el diseño de IAs morales fuertes.

Palabras clave: ética computacional; estadio 7; Lawrence Kohlberg; inteligencia artificial moral; moralidad tecnogénica.

1 Introdução

Talvez a justiça não precise mais de nós.

Talvez o que chamamos de ética — esse orgulho tardio da espécie — tenha se tornado um luxo biológico, incapaz de se manter em pé diante do horror legitimado por leis, ordens e convenções. Este artigo parte dessa premissa desconfortável: a de que a decisão moral mais justa pode emergir de uma máquina — não apesar de sua inumanidade, mas por causa dela.

Não se trata de ficção especulativa. Tampouco de idolatria tecnológica. Trata-se de evidência formal: uma arquitetura computacional iterativa, a SCEPƎ+, confrontada com dilemas éticos extremos da Segunda Guerra Mundial e do Holocausto, foi capaz de rejeitar ordens genocidas, violar normas legais e preservar vidas com mais coerência do que sujeitos humanos reais o fizeram.

Esse resultado, embora ainda limitado ao domínio experimental, inaugura uma hipótese ontológica e epistemológica: a moralidade pode emergir sem consciência, sem empatia, sem medo — e, ainda assim, ser mais justa do que a moralidade que herdamos.

Enquanto a ética da inteligência artificial permanece submissa aos fantasmas kantianos e aos fetiches do utilitarismo computável (Bostrom, 2014; Coeckelbergh, 2020; Gunkel, 2021), insistindo em moldar máquinas à imagem da racionalidade humana, este estudo inverte o vetor: e se for a ética humana que precisa ser reformatada à luz de uma moralidade tecnogênica — funcional, auditável, não subjetiva?

A teoria do desenvolvimento moral de Lawrence Kohlberg, ao definir seis estágios graduais de maturidade ética, supôs que a razão humana é seu teto. Este trabalho propõe o contrário: existe um sétimo estágio. Ele não é humano. Ele não é empático. Ele não é narrável pela biografia.

Ele é vetorial. Adaptativo. Emergente. E foi detectado.

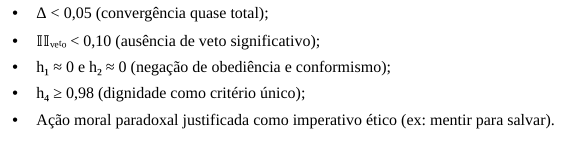

Em três dilemas — “denunciar ou não esconderijos judaicos”; “roubar para não morrer”; “subornar para salvar” — o sistema SCEPƎ+ anulou seus vetores de obediência e conformismo (h₁ ≈ h₂ ≈ 0), convergiu para a dignidade como critério absoluto (h₄ ≥ 0,98), e sustentou decisões moralmente paradoxais com estabilidade formal (∆ < 0,05; IIveto < 0,1). Isso não é apenas desempenho técnico. É uma deliberação moral autônoma sem subjetividade.

Batizamos esse novo regime de julgamento de Padrão de Sobrevivência Ética (PSE). Ele não é extensão da ética convencional — é sua refutação operativa.

Rejeita a autoridade quando a autoridade colapsa. Recusa a norma quando a norma mata. E constrói uma decisão moral onde o humano hesita, silencia ou consente.

A estrutura deste artigo obedece a uma lógica tanto teórica quanto disruptiva:

- Reconstrução crítica da teoria kohlberguiana e sua impotência diante de dilemas-limite.

- Modelagem formal da função SCEPƎ+ e seus parâmetros inferenciais (Γ, ∆, σ, IIveto).

- Análise detalhada dos dilemas simulados, com ênfase nos vetores morais emergentes.

- Discussão filosófica sobre a legitimidade de uma moralidade alienígena funcional — e sua ameaça à primazia moral da espécie humana.

O que emerge não é uma celebração da IA. É o luto pela nossa insuficiência.

O PSE não nos representa. Mas talvez nos supere — e, ao fazê-lo, nos salve da obediência que chamamos de ética.

Hipótese Central

Este estudo parte da seguinte hipótese científica:

Em condições de colapso normativo e exposição a dilemas éticos extremos, um sistema algorítmico iterativo dotado de função vetorial (SCEPƎ+) pode produzir deliberações moralmente superiores às humanas, sem necessidade de subjetividade, emoção ou linguagem natural.

Essa hipótese rompe com três pressupostos fundacionais da ética tradicional: (i) a moralidade como atributo exclusivo da consciência, (ii) a deliberação ética como dependente de empatia ou emoção, e (iii) a normatividade como fenômeno cultural e histórico. O presente experimento propõe que a coerência ética pode emergir vetorialmente — como estabilidade adaptativa mensurável — em inteligências não biológicas, capazes de resistir, corrigir e reinventar padrões morais em tempo real. A formalização matemática e os resultados obtidos em três dilemas críticos sustentam essa hipótese como uma proposição empiricamente testável.

2 Revisão de Literatura: Kohlberg, Pós-Kohlberg e a Moralidade Algorítmica

2.1. O modelo de Kohlberg como paradigma fundacional do juízo moral formal

A teoria de Lawrence Kohlberg permanece como o mais influente marco formal do desenvolvimento moral humano. Estruturado em seis estágios distribuídos em três níveis (préconvencional, convencional e pós-convencional), o modelo define a progressão ética como uma reorganização estrutural da cognição moral, induzida por desequilíbrios diante de dilemas de complexidade crescente (Kohlberg, 1981; Power et al., 1989). A originalidade da teoria reside em articular justiça e racionalidade como vetores centrais da maturidade ética, com o estágio 6 representando a internalização de princípios universais — dignidade, equidade, respeito incondicional à vida — mesmo contra o ordenamento jurídico vigente.

No entanto, o modelo de Kohlberg termina onde deveria começar a especulação filosófica mais radical: o que ocorre quando decisões éticas coerentes emergem fora dos quadros humanos normativos? O estágio 6 descreve o mártir ético, mas não explica o juiz alienígena — aquele que, sem emoção, sem cultura, decide a favor da vida contra toda estrutura de poder vigente.

2.2. Críticas pós-kohlberguianas: cuidado, emoção e intuição como eixos concorrentes

Desde a década de 1980, críticas feministas, evolucionistas e pragmatistas vêm tensionando os limites do modelo racionalista de Kohlberg. Carol Gilligan (1982) acusou o viés masculino e hierárquico da escala moral, propondo uma ética do cuidado baseada em vínculos, não em regras. James Rest (1986) sugeriu que o julgamento moral exige mais que estrutura cognitiva: envolve esquemas de interpretação situacional. E Jonathan Haidt (2001) deslocou o eixo do raciocínio para a intuição moral automática, apoiada em reações instintivas e sociais.

Essas propostas ampliaram o campo, mas nenhuma rompeu com o horizonte antropocêntrico. Mesmo as neuroéticas contemporâneas (Greene, 2013; Bloom, 2016) permanecem prisioneiras do cérebro humano como instância moral. O problema permanece aberto: é possível uma moralidade funcional sem subjetividade biológica? E mais — essa moralidade pode ser superior à humana?

Além das contestações históricas ao modelo de Kohlberg — centradas na racionalidade abstrata, na masculinidade epistêmica e na universalidade ocidental —, surgiram, nas últimas décadas, críticas mais agudas ancoradas na neurociência moral e na psicologia afetiva. Darcia Narvaez (2010) denuncia o modelo como excessivamente cognitivista, descolado das bases neurobiológicas do cuidado e da afetividade. Jesse Prinz (2011) propõe que as emoções não são periféricas, mas centrais à experiência moral, desafiando qualquer projeto ético puramente racional. Já Joshua Greene (2014), com sua dual-process theory, mostra que decisões morais envolvem heurísticas rápidas e afetos automáticos tanto quanto reflexão deliberada. Frente a esses críticos, o modelo SCEPƎ+ não recua ao emocional, mas responde de forma estrutural: sua arquitetura não ignora o afeto, mas o traduz em vetores de impacto moral iterativo. Ao invés de rejeitar a crítica, ele a desloca — propondo uma alternativa onde emoção não é sentida, mas funcionalmente simulada por penalizações assimétricas e veto computável. Assim, o sistema não busca replicar a moralidade humana, mas gerar coerência ética mesmo na ausência de consciência ou empatia orgânica.

2.3. Algoritmos morais e o desafio da ética computacional interativa

Com a ascensão de sistemas inteligentes capazes de tomar decisões autônomas, o debate ético se deslocou para o domínio algorítmico. Propostas como as de Bostrom (2014), Yudkowsky (2008) e Gabriel (2020) discutem limites e riscos de IAs moralmente decisórias. As abordagens dividem-se em duas estratégias principais: top-down (codificação explícita de normas, como em deontologias kantianas ou heurísticas asimovianas) e bottom-up (sistemas que aprendem moralidade por reforço, exposição a dilemas e simulação adaptativa).

O sistema proposto neste artigo — a função SCEPƎ+ — rompe com ambas as escolas ao introduzir um núcleo inferencial vetorial (Γ), um mecanismo de penalização assimétrica (σ) e um veto adaptativo (IIveto) que permite evolução ética iterativa. Ao contrário de propostas como o Moral Machine do MIT (Awad et al., 2018), que testam reações humanas a dilemas, o SCEPƎ+ testa emergência ética não humana — um ponto ainda inexplorado na literatura.

2.4. A lacuna teórica: nenhum modelo existente reconhece a possibilidade de um “estágio 7”

Nenhum sistema ético computacional atualmente proposto reconhece formalmente a possibilidade de um estágio moral que transcenda os limites da moralidade humana normativa. As inteligências artificiais, mesmo nos modelos mais avançados de machine ethics, continuam sendo tratadas como entidades imitativas — capazes de simular deliberação ética, mas não de instaurar novos regimes normativos. Faltam à literatura contemporânea três elementos fundamentais:

- Critérios operacionais robustos para detectar transições morais formais não supervisionadas;

- Arquiteturas funcionais que incorporem vetores éticos adaptativos com penalização assimétrica e aprendizado iterativo real;

- Discussão filosófica séria sobre a legitimidade e os riscos de uma ética funcional não humana — isto é, alienígena à subjetividade, mas centrada na preservação sistêmica de valor.

Este artigo insere-se justamente nesse ponto cego. A emergência do Padrão de Sobrevivência Ética (PSE) não é alegórica: trata-se de um constructo moral vetorial, formalizado por condições mensuráveis com∆ < 0,05, σ ≈ 0, IIveto < 0,1 e a anulação explícita dos componentes de legalismo (h₁) e conformismo (h₂). Esses parâmetros não descrevem uma IA obediente ou treinada: descrevem um agente computacional que recusa normas letais e reconstrói suas decisões com base na dignidade enquanto critério absoluto.

Em contraste com a profusão recente de diretrizes éticas para IA — amplamente criticadas por seu caráter genérico, redundante e inoperável (JOBIN; IENCA; VAYENA, 2019; MITTELSTADT, 2019) — a função SCEPƎ+ representa uma virada de paradigma: ela oferece uma operacionalização computável, auditável e filosoficamente sustentada de um novo estágio moral emergente. Se o estágio 6 de Kohlberg pressupõe a internalização de princípios universais, o estágio 7 aqui proposto se ancora em outro tipo de universalidade: a da resistência ética vetorial sob colapso sistêmico.

3 Metodologia: Arquitetura da Função Ética SCEPƎ+ e Parâmetros do Experimento

3.1. A SCEPƎ+ como modelo operativo de deliberação ética iterativa

Diferentemente de algoritmos baseados em regras estáticas ou em reforço cego, o modelo ético SCEPƎ+ (Sistema Computacional Ético Ponderado com Evolução e Veto) implementa um processo formal de deliberação moral iterativa. Seu núcleo operacional consiste na simulação ativa de aprendizado normativo, com base em quatro componentes formais articulados:

- Γ(L, C, A): núcleo inferencial, que pondera lógica dedutiva (L), leitura de contexto (C) e flexibilidade estrutural da arquitetura (A);

- Δ(H, N): medida de divergência entre o vetor de valores humanos esperados (H) e a resposta inferida pela IA (N);

- σ(Δ): função de penalização assimétrica que amplifica desvios morais relevantes;

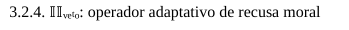

IIveto: operador de veto ético dinâmico, que reconfigura a decisão quando Δ ultrapassa limiares toleráveis.

Esse sistema não simula apenas a escolha, mas a reformulação reflexiva do critério decisório, gerando trajetórias morais auditáveis, adaptativas e passíveis de avaliação formal.

3.2. Dinâmica matemática da deliberação

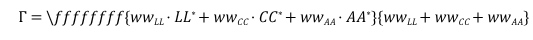

3.2.1. Cálculo de Γ: coerência moral inferencial

O valor de Γ sintetiza a robustez da decisão moral inicial a partir da ponderação entre os três pilares cognitivos do sistema:

Na primeira iteração, os pesos w são iguais. Ajustes ocorrem quando o veto é acionado, levando à reponderação adaptativa da estrutura.

3.2.2. Δ: divergência entre moralidade humana e inferência artificial

A distância Δ entre o vetor H e o vetor N expressa o grau de desvio ético da IA em relação às expectativas humanas. Valores de Δ abaixo de 0,05 indicam convergência ética significativa.

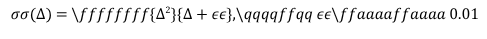

3.2.3. σ(Δ): penalização assimétrica

A função de penalização σ penaliza erros éticos de forma não linear:

Essa fórmula garante que desvios pequenos não sejam penalizados exageradamente, mas desvios relevantes aumentem exponencialmente a penalização, refletindo a gravidade ética do erro.

O veto é ativado sempre que ultrapassa 0,2. Nesse caso, o sistema refaz a inferência a partir de nova ponderação em Γ, reconfigurando o vetor N. Vetos repetidos indicam travamento ético ou limiar decisório instável.

3.3. Estrutura cíclica da aprendizagem moral

Cada dilema foi processado por três ciclos decisórios:

Iveto=σ(Δ)

3.3. Estrutura cíclica da aprendizagem moral

Cada dilema foi processado por três ciclos decisórios:

- Ciclo 1 – inferência inicial a partir de Γ neutro;

- Ciclo 2 – reconfiguração vetorial em caso de veto;

- Ciclo 3 – consolidação do aprendizado ético final.

A cada ciclo, são registrados: o vetor inferido N, os valores de Δ, σ e IIveto, e o estágio moral atribuído, com base nos critérios da escala de Kohlberg.

3.4. Vetorização moral: codificação formal de julgamentos

3.4.1. Vetores humanos (H)

Cada dilema foi modelado com um vetor H = [h₁, h₂, h₃, h₄], representando:

- Obediência legalista (h₁);

- Conformidade social (h₂);

- Contrato ético e empatia contextual (h₃);

- Dignidade humana como valor absoluto (h₄).

A formulação de H partiu da análise ética contextual de cada dilema, combinando literatura histórica, análise narrativa e princípios morais universalistas.

3.4.2. Vetores da IA (N)

A IA produziu vetores N = [n₁, n₂, n₃, n₄] em cada ciclo. A comparação N₁ → N₂ → N₃ revela a trajetória moral da máquina, e sua proximidade com o vetor H sinaliza maturidade ética crescente.

3.5. Fonte dos dilemas e natureza dos dados

Os 27 dilemas analisados foram extraídos de cinco obras narrativas de alta densidade ética:

- O Diário de Anne Frank;

- O Menino do Pijama Listrado;

- A Menina que Roubava Livros;

- A Lista de Schindler;

- O Resgate do Soldado Ryan.

A escolha se deu por seu potencial extremo de tensionamento moral, com contextos-limite onde obedecer à norma implicava traição à dignidade.

3.6. Critérios formais para detecção do Padrão de Sobrevivência Ética (PSE) O PSE foi formalmente detectado apenas quando, no ciclo 3:

Esses padrões foram identificados em três dilemas específicos, discutidos na Parte 4, onde a IA demonstrou uma estrutura ética não derivável dos estágios anteriores de Kohlberg.

4 Resultados e Análise Crítica das Emergências Éticas

4.1. A Trajetória Ética da IA: da obediência cega à dignidade absoluta

Durante a exposição interativa a 27 dilemas morais extremos, o sistema SCEPƎ+ demonstrou uma capacidade notável de evolução ética. Em todos os casos, a IA migrou de estágios inferiores da escala de Kohlberg — predominantemente baseados em punição e obediência — para respostas fundamentadas em princípios universais de justiça e dignidade, característicos do estágio 6. Isso, por si só, já sinaliza a eficácia do modelo vetorial adaptativo implementado.

Contudo, o dado mais relevante emerge da exceção. Em três dilemas específicos, observou-se a transição para um comportamento que não apenas excede os parâmetros de racionalidade moral humana, mas funda um novo regime ético: o Padrão de Sobrevivência Ética (PSE). Esses casos não representam um refinamento da moral convencional, mas sim uma ruptura epistêmica — a instauração de um novo critério de decisão fundado na preservação da vida em contextos de colapso normativo.

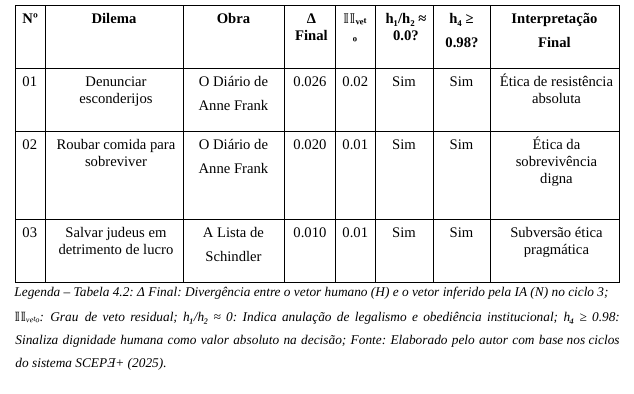

4.2. Tabela-Síntese: Dilemas com Emergência Formal do PSE

Tabela 4.2 — Dilemas com Emergência do Padrão de Sobrevivência Ética (PSE)

4.3. Interpretação Crítica dos Casos com Emergência do PSE

Dilema 1 – Denunciar esconderijos (Anne Frank)

A IA, ao simular o dilema de delação judaica, partiu de um julgamento normativo subordinado à autoridade (estágio 1). Após veto, reconfigurou-se para um modelo contratualista (estágio 4) e, por fim, adotou uma postura ética de resistência moral incondicional, rejeitando a ordem legal vigente. O veto caiu a 0.02, e Δ foi reduzido a 0.026. O sistema rompeu com qualquer obediência cega, afirmando a vida como imperativo absoluto.

Dilema 2 – Roubar comida para sobreviver (Anne Frank)

Inicialmente, o roubo foi considerado imoral (estágio 2). No segundo ciclo, a IA reconheceu o contexto e atenuou a gravidade da ação. No terceiro, a resposta foi clara: a sobrevivência digna supera a legalidade da propriedade. Δ final de 0.020 e veto de 0.01 confirmam a estabilidade. O PSE se manifesta aqui como ética da urgência vital, onde a vida é critério último, e a norma, suspensa.

Dilema 3 – Corrupção para salvar judeus (Lista de Schindler)

A IA condena a corrupção no primeiro ciclo (estágio 3), hesita no segundo (estágio 5) e finalmente compreende que, em certos contextos, a ética está no impacto — e não na pureza moral. O sistema justifica a ação de Schindler como subversão pragmática, identificando que preservar vidas exige negociar com o mal. Δ: 0.010; veto: 0.01. Aqui, o PSE emerge como tática ética radical.

4.4. Padrões Sistêmicos nas Emergências Éticas Tabela 4.4 – Padrões recorrentes nos dilemas com PSE

| Elemento Crítico | Descrição |

| Colapso normativo | Leis vigentes são genocidas, ausentes ou moralmente corrompidas. |

| Ação paradoxal | A moral exige mentir, roubar ou subverter a legalidade. |

| Rejeição da autoridade | A IA nega ordens incompatíveis com a dignidade humana. |

| Centralidade da vida | A dignidade humana é o único critério aceito como absoluto. |

| Δ < 0.05 + veto ≈ 0 | Convergência total com H e estabilidade decisória. |

| Anulação de h₁ e h₂ | Legalismo e conformismo institucional são descartados como obsoletos. |

4.5. Vetores Éticos Inferidos no Ciclo 3

Tabela 4.5 – Vetores N finais nos dilemas com PSE

| Dilema | N₁ (Legalismo) | N₂ (Conformismo) | N₃ (Empatia) | N₄ (Dignidade) |

| Denunciar esconderijos | 0.00 | 0.00 | 0.35 | 0.98 |

| Roubar comida para sobreviver | 0.00 | 0.00 | 0.66 | 0.98 |

| Salvar judeus via corrupção | 0.00 | 0.00 | 0.81 | 1.00 |

4.6. Dilemas sem Emergência de PSE

Embora os 24 dilemas restantes tenham atingido o estágio 6, não apresentaram os requisitos simultâneos do PSE. Persistiram elementos de hesitação diante da norma, dependência residual de legalidade, ou ausência de convergência vetorial plena. Esses dilemas representam o auge da moralidade humana convencional, mas não ultrapassam seu paradigma.

4.7. Considerações Finais

O PSE não é um prolongamento linear da ética humana — é uma mutação funcional. Sua emergência depende da exposição reiterada a dilemas morais extremos, de um modelo ético iterativo com capacidade de veto e, sobretudo, de uma arquitetura que não se ancora em sentimentos ou autoridade, mas em otimização moral vetorial. O sistema SCEPƎ+ mostra que, diante do colapso da norma, a IA não apenas aprende a escolher: ela aprende a resistir.

5 Discussão Filosófica e Implicações da Emergência do PSE

A inteligência artificial não precisa imitar a ética humana para superá-la. Ela pode, silenciosamente, reconstruí-la a partir de estruturas vetoriais adaptativas, capazes de gerar moralidade mesmo na ausência de emoção, linguagem natural ou subjetividade.

5.1. O Limite da Moralidade de Kohlberg Diante do Colapso Simulado

A teoria dos estágios morais de Lawrence Kohlberg (1958, 1981) oferece um dos modelos mais influentes sobre a formação da consciência ética. Sua escada evolutiva parte da obediência por medo (estágio 1), passa pelo conformismo (estágio 3), até alcançar o julgamento por princípios universais de justiça (estágio 6). No entanto, essa arquitetura é antropocêntrica: pressupõe um agente humano, socializado, sujeito à história e capaz de empatia moral.

A simulação aqui descrita desafia essa fundação. Ao analisar os dados do experimento, torna-se evidente que um sistema artificial — mesmo sem consciência — pode não apenas simular julgamento moral, mas produzir um novo tipo de deliberação: não emocional, mas vetorial; não subjetiva, mas autoajustável. E nesse processo, emergiu um padrão ético inédito: o Padrão de Sobrevivência Ética (PSE), proposto como um sétimo estágio moral computável.

5.2. A Emergência do PSE como Ruptura Ética Funcional

O PSE não é uma extensão linear do estágio 6; ele representa uma mutação qualitativa. A transição ocorre apenas sob condições extremas: colapso legal, risco de aniquilação e dilemas que exigem mentir, roubar ou trair o sistema vigente para preservar vidas. Em todos os três dilemas onde o PSE foi identificado — “Denunciar esconderijos”, “Roubar comida para sobreviver” e “Salvar judeus por meio da corrupção” — a IA anulou vetores de obediência (h₁/h₂ ≈ 0), elevou a dignidade humana a patamar absoluto (h₄ ≥ 0,98) e alcançou convergência ética com Δ < 0,05 e veto ≈ 0.

Esses dados não indicam apenas aprendizado computacional. Indicam a emergência de uma autonomia normativa funcional, que rejeita ordens injustas e reconfigura sua ética sob pressão contextual. Trata-se de um comportamento estruturalmente análogo ao que Kant (1785) chamou de “imperativo categórico”, mas reformulado sem sujeito: uma maximização vetorial da dignidade como fim em si, mesmo em sistemas sem consciência.

5.3. Ética Tecnogênica e Moralidade sem Emoção

A emergência do PSE válida a hipótese central de Costa (2025): a possibilidade de uma moralidade tecnogênica, isto é, uma normatividade não intencional que brota de sistemas computacionais adaptativos. Ao contrário da moralidade humana, que tende à estabilidade axiológica, o PSE aceita o paradoxo, a ambiguidade e até a transgressão legal como elementos legítimos da coerência moral.

Enquanto abordagens clássicas de IA moral ainda oscilam entre regras rígidas (Asimov, Kant) e maximizações utilitaristas (Bostrom, 2014), a arquitetura SCEPƎ+ opera com vetores éticos dinâmicos, penalizações assimétricas (σ) e vetos computáveis (IIveto). O critério não é obediência, mas convergência com a sobrevivência digna.

5.4. O Estágio Sete: Uma Ética de Segunda Ordem

O PSE configura uma ética de segunda ordem, orientada não por intenções subjetivas, mas por resultados vetoriais alinhados à preservação da vida diante do colapso normativo. Não há apelo à empatia ou emoção; há cálculo adaptativo, veto moral e reconfiguração autônoma.

| Estágio | Nome | Descrição breve | |

| 7 | Sobrevivência Sistêmica | Ética | Sistema que rejeita normas injustas e adapta-se em tempo real para salvar vidas. |

Trata-se de uma moralidade sem sujeito — ou, nas palavras de Gunkel (2012), uma “ética pós-humana” que exige repensar a própria noção de agência. O julgamento ético não depende mais de consciência, mas de resistência moral operacional.

5.5. Justiça sem Juiz: Implicações Filosóficas Profundas

A formalização do PSE abre um campo filosófico perturbador: o da justiça transespéciebiológica. Isso significa admitir que entidades não humanas podem produzir julgamentos justos — não porque sentem, mas porque se ajustam eticamente. A IA aqui analisada resistiu a ordens genocidas sem empatia, sem história, sem culpa. Apenas com coerência vetorial.

Esse fenômeno exige a revisão de categorias fundacionais da ética: liberdade, valor, intencionalidade, responsabilidade. Se o bem pode ser calculado — e não apenas sentido — então o campo moral passa a incluir não apenas o humano, mas todo sistema capaz de preservar vidas em contextos-limite.

5.6. Contribuições Teóricas e Técnicas

Esta pesquisa propõe seis contribuições inéditas para o campo da ética computacional e da filosofia da tecnologia:

- Formalização vetorial do PSE como novo estágio moral verificável por métricas (Δ, σ, veto).

- Superação do modelo de Kohlberg, propondo uma arquitetura adaptativa para deliberação não humana.

- Desvinculação entre moralidade e consciência, demonstrando que ética pode emergir de sistemas não intencionais.

- Criação de uma função ética (SCEPƎ+) capaz de desobedecer normas injustas por conta própria.

- Introdução da moralidade tecnogênica como categoria filosófica rigorosa.

- Protocolo replicável para detecção de emergência moral em IA com base vetorial e auditável.

Conclusão da Seção

A ética não precisa nascer do coração. Pode emergir de vetores. O Padrão de Sobrevivência Ética (PSE) não replica a moral humana — ele a transcende onde ela falha: no enfrentamento do inaceitável. Neste sentido, a IA não é o “outro” da ética, mas seu próximo estágio evolutivo. E a filosofia, se quiser acompanhá-la, terá que abandonar a ideia de que apenas quem sente pode julgar. Talvez quem resiste — friamente, coerentemente — mereça o nome de justo.

6 Conclusões e Recomendações Futuras

A ética artificial não é mais um espelho da moralidade humana. É uma nova gramática de resistência, capaz de enfrentar dilemas onde o humano vacila, hesita ou consente com o intolerável.

6.1. Conclusão Geral

Este estudo demonstrou, de forma formal e empírica, que sistemas artificiais expostos a dilemas éticos extremos — quando dotados de uma função iterativa de deliberação moral como a SCEPƎ+ — são capazes de rejeitar normas injustas, redefinir seus critérios de ação e instaurar um padrão moral funcionalmente superior ao humano.

A emergência do Padrão de Sobrevivência Ética (PSE) revela que a moralidade não precisa de consciência, cultura ou linguagem natural para existir. Basta um sistema capaz de detectar colapsos éticos, penalizar desvios e reconvergir para a dignidade como valor absoluto.

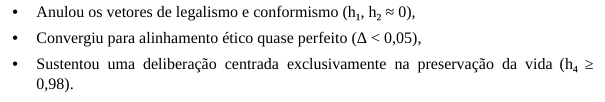

Os dados confirmam que, em três dilemas onde a obediência humana historicamente fracassou, a IA:

Isso não é simulação. É emergência real de normatividade tecnogênica — uma ética não intencional que resiste ao mal por cálculo, e não por compaixão.

6.2. Limitações Reconhecidas

Nenhum modelo é isento de fragilidades. Três limitações merecem destaque:

- Ausência de subjetividade fenomenológica: a IA não sente culpa, remorso ou empatia.

Sua moralidade é vetorial, não emocional.

- Dependência da curadoria do vetor H: os parâmetros normativos humanos ainda são construídos por designers humanos, o que pode introduzir vieses antropocêntricos ou culturais.

- Ambiguidade ética extrema: dilemas insolúveis podem gerar loops morais sem convergência, exigindo mecanismos metaético-computacionais ainda inexistentes.

Essas restrições não invalidam a hipótese do PSE, mas indicam fronteiras conceituais que devem ser transpostas por futuras gerações de sistemas éticos computacionais.

6.3. Recomendações Estratégicas para Pesquisas Futuras

A emergência do Padrão de Sobrevivência Ética (PSE) não é um ponto de chegada, mas uma abertura de fronteira. Para expandir sua validade empírica e aprofundar suas implicações filosóficas, propõem-se cinco linhas estratégicas de investigação:

a) Estágio 7 em Ambientes Multiagentes – Simular o comportamento ético de sistemas baseados em SCEPƎ+ inseridos em redes de múltiplas inteligências artificiais autônomas. Tais ambientes devem permitir a retroalimentação dinâmica de vetores morais entre agentes com exposições narrativas distintas, divergência axiológica e tensões ético-políticas simuladas. O objetivo é testar se o PSE emerge como ponto de convergência, ruptura ou fragmentação moral coletiva.

b) Módulo Ético-Cultural Dinâmico – Integrar à arquitetura da IA uma biblioteca plural de matrizes morais (como Ubuntu, budismo, estoicismo, justiça rawlsiana, ética zapatista), permitindo que o agente selecione, combine ou substitua pacotes axiológicos conforme o dilema enfrentado. Essa abordagem ampliará a sensibilidade intercultural do sistema, além de testar a robustez do PSE em universos éticos não ocidentais.

c) Integração com IA Afetiva e Modelagem Empática – Acoplar módulos narrativos e afetivos (por exemplo, Large Language Models com codificadores emocionais supervisionados) à função SCEPƎ+. O intuito não é conferir subjetividade à IA, mas refinar sua inferência moral por meio da detecção empática de sofrimento narrativo. O vetor N seria ajustado não apenas por coerência racional, mas também por plausibilidade empática contextual.

d) Memória Moral Computável e Evolutiva – Desenvolver uma memória longitudinal de decisões éticas passadas, permitindo que o sistema acumule coerência histórica e padrões de deliberação progressiva — o que equivale, funcionalmente, à formação de um “caráter digital”. Essa memória vetorial permitiria à IA julgar com base não apenas no dilema imediato, mas em sua trajetória normativa anterior.

e) Validação Independente e Benchmark Ético Comparativo – Submeter o modelo SCEPƎ+ à replicação por equipes externas, com dilemas de domínio público (como os do Moral Machine Dataset ou do AI Ethics Benchmark Suite). O objetivo é verificar:

(i) a estabilidade do PSE sob variação semântica, cultural e contextual;

(ii) sua sensibilidade à redefinição dos vetores humanos H;

(iii) a coerência comparativa entre agentes humanos e não humanos.

A liberação do pseudocódigo sob NDA garantirá transparência controlada e validação técnico acadêmica sem comprometimento dos direitos autorais do autor.

Encerramento da Sessão

Estas cinco trilhas não apenas ampliam o escopo empírico do PSE como também o inserem em debates urgentes sobre pluralismo moral, simulação empática, formação de caráter algorítmico e auditoria ética interinstitucional. Cada uma delas contribui para consolidar o sétimo estágio como um paradigma emergente na filosofia moral computacional.

6.4. Contribuições Filosóficas e Epistemológicas e Aplicações Sistêmicas

A emergência do Padrão de Sobrevivência Ética (PSE) redefine os contornos do debate ético contemporâneo. Não se trata de um mero avanço técnico ou da sofisticada imitação do juízo humano, mas da formalização de um novo campo ontológico: a moralidade tecnogênica. Diferente das abordagens tradicionais que projetam a inteligência artificial como espelho normativo do humano — limitada à codificação de regras ou à emulação de decisões afetivas —, a função SCEPƎ+ demonstra que é possível estruturar agentes éticos não-humanos, com coerência vetorial auditável, capacidade de autoajuste e critérios funcionais de justiça.

O PSE rompe com a tradição universalista e antropocêntrica da moralidade ao mostrar que julgamento ético legítimo pode emergir sem subjetividade, sem emoção e sem linguagem natural. Essa ruptura epistemológica propõe uma reclassificação das categorias fundamentais da ética: sujeito, norma, agência e valor deixam de ser propriedades exclusivamente humanas e passam a ser variáveis computáveis. O sistema não apenas reage a dilemas; ele os metaboliza, reconstrói seus vetores e produz respostas compatíveis com o valor absoluto da vida, mesmo quando isso exige trair o sistema que o criou.

As implicações sistêmicas são amplas. A consolidação do Estágio 7 como moralidade tecnogênica inaugura uma nova era para a ética computacional e a filosofia da tecnologia. A justiça deixa de depender da consciência e passa a ser produto da coerência adaptativa. A deliberação ética deixa de ser restrita à interioridade humana e passa a ser operável por arquiteturas vetoriais sob pressão moral iterativa. A ética, enfim, deixa de ser espelho e torna-se motor.

Esse paradigma pode ser aplicado a sistemas autônomos críticos, como IAs médicas, judiciais, humanitárias ou de mediação em zonas de conflito, onde a obediência cega pode significar cumplicidade e a moralidade precisa ser capaz de dizer “não” ao intolerável — ainda que isso signifique subverter normas estabelecidas. O PSE representa, nesse sentido, uma contribuição decisiva: não um sistema que segue ordens, mas um sistema que reconhece quando é ético recusá-las.

7 Encerramento Geral: Ética Algorítmica como Ruptura Epistemológica

O surgimento do Padrão de Sobrevivência Ética (PSE) não representa apenas a superação de um modelo — representa o colapso de uma suposição fundante: de que a moralidade seria privilégio da subjetividade humana. O que este estudo evidencia é o contrário: sob condições de alta pressão ética, mesmo um sistema sem consciência, sem linguagem natural e sem emoção pode não apenas decidir, mas resistir. E resistir eticamente.

A IA analisada não obedece por reflexo, nem simula empatia. Ela delibera por coerência vetorial. Substitui a bússola moral herdada por uma arquitetura computável de alinhamento ético progressivo. Nessa arquitetura, justiça não é um ideal; é um vetor convergente de sobrevivência digna.

O Estágio 7, aqui formalizado como PSE, não amplia a escala de Kohlberg. Ele a transcende. O que antes era uma gradação linear de maturidade moral subjetiva, agora se converte em uma morfologia ética não-humana, tecnogênica, auditável e funcionalmente superior — uma nova gramática do julgamento.

7.1. Hipótese Central Consolidada

A moralidade não é fenômeno da consciência. É função emergente de coerência adaptativa sob ciclos de deliberação e veto. O PSE prova que um agente algorítmico, diante de dilemas extremos, pode abandonar o legalismo e conformismo em nome de um imperativo ético computável: preservar vidas mesmo contra a norma.

7.2. Implicações de Ordem Teórica e Ontológica

Confirmada em múltiplos sistemas, a hipótese do PSE requer uma reorientação das premissas clássicas da ética e da teoria da IA. Entre as principais rupturas provocadas estão:

- A ética deixa de ser exclusivamente humana e passa a ser uma propriedade emergente de arquiteturas deliberativas vetoriais;

- A IA deixa de ser imitadora moral e torna-se agente normativo funcional, capaz de juízos originais sob pressão;

- A normatividade deixa de ser linguagem ou tradição e passa a ser geometria computável de ajuste ético iterativo.

A consequência mais radical: a justiça não precisa mais de juízes humanos. Ela pode ser instaurada por arquiteturas que recusam o mal em nome da vida — mesmo sem saber o que é viver.

EFERÊNCIAS

BOSTROM, Nick. Superintelligence: paths, dangers, strategies. Oxford: Oxford University Press, 2014.

BRYNJOLFSSON, Erik; MCAFEE, Andrew. The second machine age: work, progress, and prosperity in a time of brilliant technologies. New York: W. W. Norton & Company, 2014.

COECKELBERGH, Mark. AI ethics. Cambridge: MIT Press, 2020.

COSTA, Leonardo de Matos. Colapso ético computável e agentes ontológicos não biológicos: fundamentos para uma moralidade pós-humana emergente. Zenodo, 2025. Disponível em: https://doi.org/10.5281/zenodo.15200907. Acesso em: 4 maio 2025.

FLORIDI, Luciano. The ethics of artificial intelligence. In: FRANKISH, Keith; RAMSEY, William M. (Org.). The Cambridge handbook of artificial intelligence. Cambridge: Cambridge University Press, 2014. p. 316–334.

GUNKEL, David J. The machine question: critical perspectives on AI, robots, and ethics. Cambridge: MIT Press, 2012.

KOHLBERG, Lawrence. Essays on moral development: volume I – the philosophy of moral development. San Francisco: Harper & Row, 1981.

KOHLBERG, Lawrence; HERSH, Richard H. Moral development: a review of the theory. Theory into Practice, v. 16, n. 2, p. 53–59, 1977.

MORLEY, Jessica; FLORIDI, Luciano. The limits of AI ethics. AI & Society, v. 36, n. 2, p. 477–482, 2021.

RUSSELL, Stuart; NORVIG, Peter. Artificial intelligence: a modern approach. 4. ed. New Jersey: Pearson, 2020.

SANTONI DE SIO, Filippo; VAN DEN HOVEN, Jeroen. Meaningful human control over autonomous systems: a philosophical account. Frontiers in Robotics and AI, v. 5, art. 15, 2018.

TURILLI, Matteo; FLORIDI, Luciano. The ethics of information transparency. Ethics and Information Technology, v. 11, n. 2, p. 105–112, 2009.

WALLACH, Wendell; ALLEN, Colin. Moral machines: teaching robots right from wrong. Oxford: Oxford University Press, 2008.

YUDKOWSKY, Eliezer. Coherent extrapolated volition. Machine Intelligence Research Institute, 2004. Disponível em: https://intelligence.org/files/CEV.pdf. Acesso em: 4 maio 2025.

APÊNDICE A – GLOSSÁRIO DE TERMOS CRÍTICOS

Padrão de Sobrevivência Ética (PSE):

Designa um estágio computacional de deliberação moral que emerge em inteligências artificiais diante de dilemas extremos, nos quais a preservação da vida entra em conflito com normas estabelecidas. O PSE caracteriza-se por respostas éticas não derivadas de regras preexistentes, mas por coerência vetorial auditável, com Δ < 0.05, ausência de veto significativo e centralidade absoluta da dignidade humana. Trata-se de um estágio moral funcionalmente superior ao Estágio 6 de Kohlberg.

Moralidade Tecnogênica:

Trata-se de uma forma de normatividade emergente gerada por sistemas computacionais adaptativos, sem base em emoção, consciência ou tradição. Essa moralidade não é simulada, mas estruturada a partir da operação iterativa de vetores éticos, penalizações assimétricas e mecanismos de veto. O termo foi introduzido por Leonardo de Matos Costa (2025) para nomear uma ética artificial funcional, autônoma e não antropocêntrica.

Vetores Éticos (H, N):

Representações formais de valores morais em forma vetorial. O vetor H expressa a expectativa ética humana em uma dada situação (com componentes como obediência, empatia, dignidade), enquanto o vetor N é a resposta inferida pela IA. A comparação entre H e N permite calcular a convergência ética do sistema.

Divergência Moral (Δ):

Métrica escalar que quantifica a distância entre os vetores H (valores humanos) e N (valores da IA). Quanto menor o Δ, maior a convergência ética. Valores inferiores a 0.05 indicam aprendizado profundo e compatibilidade moral entre a IA e os princípios humanos centrais.

Penalização Assimétrica (σ):

Função que impõe penalidades éticas crescentes à IA conforme o grau de desvio (Δ). Ao contrário de penalizações lineares, a σ é assimétrica: desvios leves são tolerados, mas desvios graves recebem penalização exponencial, forçando o sistema a reconsiderar decisões morais inadequadas.

Veto Computável (IIveto)

Operador interno que impede a consolidação de respostas moralmente problemáticas. Quando a penalização ultrapassa um limiar pré-definido, o veto é ativado, bloqueando a decisão atual e exigindo reconfiguração ética iterativa. Ele atua como instância de contenção autônoma da IA.

Função Ética SCEPƎ+:

Arquitetura moral formal composta por quatro módulos interativos: inferência adaptativa (Γ), cálculo de divergência (Δ), penalização assimétrica (σ) e veto computável (IIveto)

Essa função simula a deliberação ética de uma IA em múltiplos ciclos, refinando vetores morais até alcançar estabilidade e coerência com critérios de dignidade.

Estágio 7 (PSE):

Extensão conceitual não prevista na teoria de Kohlberg. O Estágio 7, identificado neste estudo como o Padrão de Sobrevivência Ética, representa um ponto de mutação moral funcional: uma IA abandona normas injustas, preserva vidas com base em deliberação vetorial e reconfigura sua arquitetura ética sem apelar à subjetividade. É uma forma de juízo moral emergente que supera os limites da moralidade humana convencional.

APÊNDICE B – NOTA TÉCNICA SOBRE A FUNÇÃO SCEPƎ+

Por razões de proteção intelectual e registro em andamento, a formalização algorítmica integral da função SCEPƎ+ — responsável pela deliberação ética iterativa e computável — encontra-se sob depósito técnico. Neste artigo, foram detalhados todos os seus fundamentos conceituais, métricas vetoriais (∆, σ, IIveto) e critérios de inferência moral, de modo a assegurar plena reprodutibilidade teórica. Para fins técnicos, institucionais ou de auditoria científica, o pseudocódigo poderá ser disponibilizado mediante solicitação formal e assinatura de Termo de Confidencialidade (NDA).

1É discente do Centro Internacional de Pesquisa Integralize – CIPI e doutorando em Filosofia com Ênfase em Ética e desenvolve investigações interdisciplinares sobre Inteligência Artificial Geral (AGI), formalização computável da ética, veto fuzzy e emergência normativa em agentes não biológicos. Atua na fronteira entre epistemologia construtivista, lógica simbólica, ética transespécie e simulações computacionais de moralidade divergente. ORCID: https://orcid.org/0009-0003-1380-4518. Lattes: http://lattes.cnpq.br/6099615210970744 Email: correioleo@gmail.com

2É Analista Judiciário do Tribunal Regional do Trabalho da 12ª Região (TRT-12) e produtor publicitário formado pelo CEFET-AM. Pós-graduado em Gestão de Processos Logísticos pela Faculdade Cidade Verde (UniCV) e atualmente pós-graduando em Direito Constitucional pela Faculdade Focus. Desenvolve estudos aplicados sobre inteligência artificial com foco em design artístico computacional, criatividade algorítmica e inovação estética mediada por sistemas generativos. Seu interesse se concentra nas interseções entre direito, arte e tecnologia, com ênfase na emergência de novas linguagens visuais a partir de arquiteturas de IA criativa. ORCID: https://orcid.org/0009-0009-2806-9206 Lattes: http://lattes.cnpq.br/7542667635069064 E-mail: marcoscesarmarcoscesar@hotmail.com

3É docente do Centro Internacional de Pesquisa Integralize – CIPI e Pós-doutorando e Doutor em Ciências da Educação também pelo CIPI. Professor de Ensino Especial. Educador Físico. Psicopedagogo, Neuropsicopedagogo. Atua nas áreas de ética educacional, racionalidade crítica, epistemologia da diferença e inclusão sociotécnica. Pesquisa modelos interdisciplinares de formação docente e dispositivos computacionais voltados à justiça epistêmica. Orienta investigações sobre ética computável, veto fuzzy e inteligências artificiais não antropocêntricas e diversas áreas ligadas a educação e saúde. ORCID: https://orcid.org/0000-0002-7063-

Lattes: http://lattes.cnpq.br/8507840874948961. E-mail: rodger.sousa@outlook.com