REGISTRO DOI:10.5281/zenodo.11509643

Daniel de Souza Caliari Ferreira

Melhym Pires Aarão

Orientador: Professor Bruno Brasil de Carvalho

RESUMO

O objetivo geral foi analisar e compreender de que forma o arcabouço jurídico brasileiro pode ajuizar sistemas de inteligência artificial (provedores) em casos de responsabilidade civil por algoritmos “racistas”. Foi uma pesquisa bibliográfica, descritiva, dialética e documental. A pesquisa concluiu que no Brasil, ainda não há uma legislação específica sobre questões legais e éticas referentes ao uso das IAs, o que gera uma relevante lacuna no seu arcabouço jurídico, especialmente referente à responsabilidade civil por danos ou erros causados por algoritmos discriminatórios ou mal programados. Esse avanço é importante, pois outros países já estão elaborando suas legislações específicas sobre este tema. O Brasil passa por um momento importante com a tramitação do projeto de lei sobre as IAs, que avançam velozmente em diversos setores e precisam ter regulação para prevenir e punir consequências adversas. Por isso é fundamental que o Brasil estabeleça um arcabouço jurídico sólido, abrangente e capaz de abarcar as diversas questões relacionadas à IA e à responsabilidade civil.

Palavras-Chave: Inteligência artificial. Responsabilidade civil. Arcabouço jurídico brasileiro

ABSTRACT

The overall objective was to analyze and understand how the Brazilian legal framework can adjudicate artificial intelligence systems (providers) in cases of civil liability for “racist” algorithms. It was a bibliographic, descriptive, dialectical, and documentary research. The research concluded that in Brazil, there is still no specific legislation on legal and ethical issues regarding the use of AI, which creates a significant gap in its legal framework, especially regarding civil liability for damages or errors caused by discriminatory or poorly programmed algorithms. This advancement is important because other countries are already developing their specific legislation on this subject. Brazil is going through an important moment with the progress of the bill on AI, which is advancing rapidly in various sectors and needs regulation to prevent and punish adverse consequences. Therefore, it is essential for Brazil to establish a solid, comprehensive legal framework capable of encompassing the various issues related to AI and civil liability.

Keywords: Artificial intelligence. Civil liability. Brazilian legal framework.

1 INTRODUÇÃO

A inteligência artificial chega até os dias atuais como um elemento basal da 4ª revolução industrial, conforme Freitas e Freitas (2020, p. 13), para quem a IA deve ser compreendida enquanto um “sistema algorítmico adaptável e relativamente autônomo, emulatório da decisão humana”. Esse precedente abre um leque grande para diversas especulações e análises, especialmente na seara do Direito Civil.

A temática inteligência artificial (IA) e responsabilidade civil vem crescendo em destaque nos recentes anos de pesquisa acadêmica, e como objeto de estudo vem despertando interesse nos mais variados ramos do saber e da aplicabilidade técnica humana principalmente no âmbito da automação e da digitalização de imagens, processos, textos, e criações artísticas.

Este campo de conhecimento prático se mostra multidisciplinar pois abrange diversas áreas. O direito civil e tecnológico tem focado sua atenção no momento de descoberta de limites e possibilidades a partir do debate de questões fundamentais sobre responsabilidade civil por danos decorrentes de sistemas de IA semi autônomos ou autônomos. Logo, essa possibilidade se estende aos campos mais diversos, entre os quais o do direito do consumidor, da propriedade intelectual, dos contratos e da privacidade, que vem utilizando a IA para otimizar seus processos.

Para Barbosa (2019) esse cruzamento estabelece um dos maiores desafios ético-jurídicos quando enfatiza o uso de sistemas de inteligência artificial e responsabilidade civil, no que se refere a danos causados por robôs inteligentes, pois os sistemas delituais tradicionais se baseiam na culpabilidade, e essa questão se colocada dentro da responsabilidade civil nesse âmbito, se mostra no mínimo um desafio.

Assim, há um direcionamento para que haja a definição da responsabilidade civil decorrente do uso de sistemas de IA, que se por um lado beneficia com inúmeras vantagens seus usuários, quanto a aspectos relacionados à eficiência e inovação, por outro também permite emergir desafios relevantes quanto à atribuição de culpabilidade em situações de prejuízos ou danos causados a terceiros, haja vista que sua natureza autônoma e autodidata pode comprometer a responsabilidade de quem a opera, pois se torna complexo estabelecer claramente a causa direta de determinados resultados inesperados.

Desse modo, esse artigo buscará relacionar a responsabilidade civil no âmbito do uso da inteligência artificial em plataformas de provedores da internet caso do Google, que demonstrou viés racista a partir de um algoritmo de busca inteligente -, a fim de identificar possibilidades jurídicas previstas no arcabouço jurídico brasileiro que possam ser aplicadas nesse âmbito.

Nos dias atuais ocorre uma acelerada integração da inteligência artificial com diferentes áreas da sociedade e isso remete diretamente ao segundo tema, a responsabilidade civil. Nesse aspecto a temática desse artigo se justifica no sentido de estar focada na necessidade de inicialmente compreender a problemática que envolve as duas vertentes, e em segundo lugar, a necessidade de se pensar na regulamentação das interações humanos e sistemas inteligentes, a fim de prever possíveis impactos e danos que podem causar tais envergaduras.

É importante situar que a IA já é um recurso utilizado em setores diversos, seja na saúde, no transporte, na alimentação, no turismo, no entretenimento e sua autonomia em tomar decisões potencializa riscos de eventos adversos e inesperados. Daí a necessária análise do que prevê o arcabouço legal e ético sobre a responsabilidade civil de tal ação, de modo a prevenir a segurança jurídica de tantos que venham a sofrer riscos diante dessa nova conjuntura.

O tema se justifica ainda por colocar no mesmo bojo a responsabilidade civil e a inteligência artificial, quando o mundo todo está envolvido na busca de adaptação do direito às avassaladoras transformações tecnológicas que atualmente ocorrem em todos os países.

Se até bem pouco tempo atrás as redes sociais se tornaram um vasto campo onde a lei e a justiça deveriam lançar bases e luzes a fim de disciplinar e regulamentar, nos tempos mais recentes os sistemas de IA, demonstrando complexidade e autonomia, fazem o mesmo ou maior apelo às leis existentes, a fim de que sejam adequadas para superar os desafios emergentes de tais inovações.

Há muitas questões que devem ser abordadas nesse âmbito em que a responsabilidade civil causada por falhas em sistemas de IA sejam devidamente identificadas e normatizadas, a fim de que mesmo não sendo totalmente de causa humana direta, deva ser quantificada ou compensada pelos danos a ela imputados. Mas isso exige um cuidadoso exame, visando construir um arcabouço jurídico capaz de conjugar a responsabilidade civil e a IA garantindo a eficácia da justiça face a às velozes mudanças tecnológicas.

Espera-se ainda que essa pesquisa contribua para uma compreensão responsável e ética da inteligência artificial, de modo que a responsabilidade civil possa se mostrar uma questão legal, moral e social, onde se possa perceber padrões claros de práticas voltadas ao desenvolvimento e implementação de sistemas de IA com responsabilidade, para que haja uma sociedade mais justa e equitativa, onde o avanço tecnológico ocorra de modo ético e responsável.

O problema que este tema buscará responder ao longo da pesquisa é: em que medida sistemas de inteligência artificial (provedores) podem responder civilmente por algoritmos “racistas” ou que induzam a erros segundo o arcabouço jurídico brasileiro.

O objetivo geral foi analisar e compreender de que forma o arcabouço jurídico brasileiro pode ajuizar sistemas de inteligência artificial (provedores) em casos de responsabilidade civil por algoritmos “racistas” ou que induzam a erros. Os objetivos específicos foram: conceituar Inteligência artificial e responsabilidade civil; apresentar e analisar o caso (Google) relacionado à responsabilização civil erros causados por sistemas de inteligência artificial em plataformas digitais, investigar disposições previstas no Arcabouço Jurídico Brasileiro sobre responsabilização civil em casos delituosos provocados por sistemas de inteligência artificial em plataformas digitais.

Na metodologia da pesquisa buscou-se reunir os métodos e técnicas mais adequados a partir de uma linha de raciocínio capaz de auxiliar no desenvolvimento dos tópicos do trabalho científico. Essa parte do artigo busca indicar o caminho a ser percorrido, a fim de se manter o rumo e alcançar os objetivos pretendidos, segundo o problema de pesquisa.

Essa pesquisa é bibliográfica, descritiva, dialética e documental, por abarcar esses aspectos em sua formulação. Isso porque independentemente do tipo de pesquisa, deve-se ter uma pesquisa bibliográfica prévia, seja para um levantamento do estado da arte do tema, ou mesmo para a fundamentação teórica ou ainda para justificar os limites e contribuições da própria pesquisa.

A pesquisa descritiva é muito usada para a observação, análise e correlação de fatos ou fenômenos envolvendo o objeto da pesquisa, de modo que não deve ser um caminho de solução, mas ela apenas descreve os fenômenos segundo a percepção do pesquisador, a fim de o mesmo possa promover uma análise rigorosa do objeto pesquisado (Mezzaroba; Monteiro, 2017).

O método dialético é um método que investiga a realidade por meio do estudo de sua ação recíproca, de possíveis contradições apresentadas pelo fenômeno e ainda, de estudos sobre as mudanças que ocorrem na natureza e na sociedade relacionados ao objeto de estudo. Esse método foi usado por Platão, discípulo de Sócrates, que ajudou na evolução da dialética, ao ser proposicional, interrogativo, controverso e interminável, e o usou como veículo da filosofia, distinto de ciência, sofística e retórica (Fortes, 2019).

Já a pesquisa documental envolve o uso de documentos (no caso leis, decretos, resoluções, ementas, acórdãos) que possam ajudar a analisar, descrever e comparar usos e costumes, tendências, diferenças e outras características, com validade para o tempo presente, sendo a pesquisa descritiva, independentemente de suas formas, um método que considera dados ou fatos colhidos na própria realidade na qual são observados/identificados (Cellard apud Lima Junior, 2021).

2 INTELIGÊNCIA ARTIFICIAL

É importante destacar que a discussão que envolve a inteligência artificial ocorre frequentemente sem uma definição precisa do que ela seria, pois não é uma ação simples, mas ela pode ser, em uma tentativa de simplificação, descrita enquanto a aplicação de métodos que tem por base o comportamento inteligente observado em humanos e outros animais, de modo a sugerir soluções para problemas complexos. E esse tipo de ação vem se tornando cada vez mais presente na realização de tarefas sem a intervenção humana. Porém, as funções para as quais estão sendo desenvolvidos esses sistemas, ao serem questionadas, pode-se obter respostas que estão continuamente se expandindo. (Silva, 2018)

Comumente os sistemas de inteligência artificial são categorizados em duas vertentes principais: inteligência artificial fraca e inteligência artificial forte. A primeira trabalha usando dados existentes para oferecer soluções aos problemas, usando a lógica e raciocínio automatizado (Rosa, 2022).

Esses sistemas até emulam comportamentos e emoções quando estão em busca de resolução de problemas, porém não têm consciência nem capacidade de raciocinar por si próprios. Esse tipo de IA fraca inclui bots que fazem atendimento de muitas empresas, os assistentes virtuais, como a Clara (da operadora claro), a Siri da Apple, além de alguns aplicativos de trânsito como o Waze, todos baseados em conjuntos de dados que lhes ajudam a responder as perguntas ou outros direcionamentos (Lima, 2014).

Já a IA forte se baseia na crença de que é possível haver máquinas “que pensam“, ou seja, que seriam capazes de criar, raciocinar e inclusive desenvolver sua própria consciência. Essa forma de IA depende dos sistemas de inteligência artificial fraca como base, mas precisa de metodologias que a ajudem a raciocinar autonomamente e desenvolver sua compreensão do mundo ao redor. Esse tipo poderia ser exemplificado por um robô que, tendo sua própria consciência, elabora propostas baseadas em lei e experimenta emoções nesse processo (Lemos, 2022).

Nos dias atuais os sistemas de IA mais comuns e com os quais mais interagimos predominantemente estão na categoria de IA fraca. No entanto a inteligência artificial está em constante estudo e desenvolvimento em diversos campos, o que supõe que o aprendizado de máquina é proeminente, e visa capacitar sistemas a obter conhecimento de forma automática, a fim de sempre maximizar sua capacidade de generalização, sendo capaz de superar as respostas de forma satisfatória (Lima, 2014).

Esse exemplo pode ser encontrado nas buscas automáticas poro filmes e assuntos na Netflix ou no YouTube, que partem de preferências e padrões de visualização para sugerir novos filmes ou vídeos aos usuários (Alves, 2020)

Há excelentes exemplos do uso da inteligência artificial, entre as quais as redes sociais (Facebook, Instagram, X, Tic Toc, etc.), que oferecem conteúdo personalizado a partir do histórico do usuário, bem como a plataforma de pesquisas Google, e que também oferece um sistema de tradução automática (Rosa, 2022).

O aprendizado das máquinas ocorre como uma ramificação para resolver problemas mais complexos. Esse sistema utiliza redes neurais artificiais que se inspiram no funcionamento do cérebro humano, a fim de saber codificar algoritmos. São treinados e aprimorados continuamente, obtendo grande capacidade de adaptação. Entre os exemplos podem ser citados o Google Now e Google Tradutor, Siri da Apple, a Cortana da empresa Microsoft (Silva, 2018).

3 RESPONSABILIDADE CIVIL

A responsabilidade civil nada mais é do que o dever jurídico de reparar o dano sofrido, gerando ao seu causador direto ou indireto a obrigação de repará-lo.

O Código Civil (2015), que trata da responsabilidade civil (Título IX), dispõe, no art. 927, que “aquele que, por ato ilícito[1] (art. 186 e 187), causar dano a outrem, fica obrigado a repará-lo”.

Assim, para se entender o conceito de ato ilícito, deve-se conhecer melhor os art. 186 e 187, do Código Civil, os quais dispõem que:

Art. 186. Aquele que, por ação ou omissão voluntária, negligência ou imprudência, violar direito e causar dano a outrem, ainda que exclusivamente moral, comete ato ilícito.

Art. 187. Também comete ato ilícito o titular de um direito que, ao exercê-lo, excede manifestamente os limites impostos pelo seu fim econômico ou social, pela boa-fé ou pelos bons costumes.

Sob o olhar de doutrinadores a responsabilidade civil pode ser compreendida de diversas formas.

Consoante Fernando Noronha, no que tange à responsabilidade civil, os riscos foram agravados demasiadamente com a Revolução Industrial, em comparação com os perigos de antanho, fato este que fez aumentar as interpelações judiciais com o objetivo de reparação dos prejuízos derivados dessa circunstância. Deveras, o fornecimento de bens e de serviços, principalmente o de educação, acarretou uma maior valorização do ser humano, fazendo com que ele passasse a aceitar menos as vicissitudes do destino, refutando a desgraça e exigindo indenização pelo dano sofrido (Oliveira, Remédio, 2022, p. 103).

Para estes autores, o nascimento da responsabilidade civil requer uma conduta, que pode ser uma ação ou omissão humana voluntária, causando dano ou prejuízo. A omissão só é considerada um “fato” quando há um dever prévio de agir. O dano é um elemento essencial para a responsabilidade civil, conforme as mudanças do Código Civil de 1916 para o de 2002, tornando a existência do dano indispensável para o reconhecimento da responsabilidade civil por ato ilícito (Oliveira, Remédio, 2022, p. 103).

. Para que haja dever de indenizar, é necessário que alguns requisitos estejam presentes: conduta, nexo de causalidade, culpa (se aplicável à teoria da culpa) e dano. Quando a situação se enquadra na teoria do risco, que implica responsabilidade objetiva, o elemento subjetivo da culpa não é necessário, pois não faz parte da estrutura da responsabilidade objetiva. O artigo 927 do Código Civil brasileiro reconhece tanto a teoria da culpa como a responsabilidade civil objetiva, baseada na teoria do risco. A equidade, entendida como justiça do caso concreto, também é considerada na responsabilidade civil, conforme previsto nos artigos 928, parágrafo único, 944, parágrafo único e 953, parágrafo único do Código Civil de 2002, em linha com o princípio da operabilidade (Oliveira, Remédio, 2022, p. 103).

4 A INTELIGÊNCIA ARTIFICIAL E A RESPONSABILIDADE CIVIL DE PROVEDORES

4.1 O caso Google 1

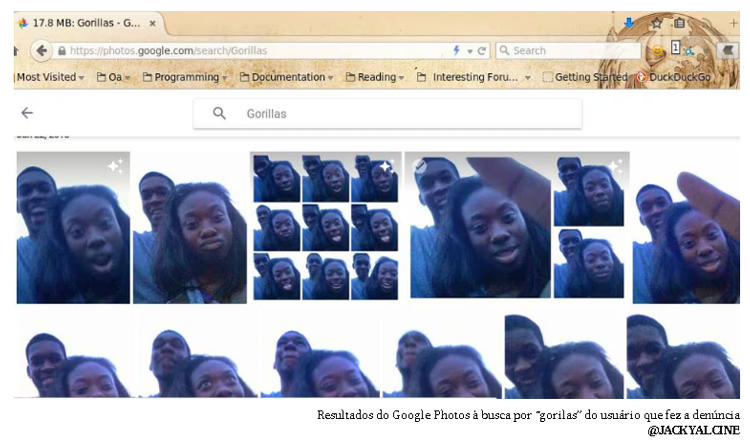

Em junho de 2015 a plataforma Google revelou um viés racista nos cálculos de seu algoritmo, especificamente no Google Photos. O algoritmo erroneamente rotulava amigos negros como gorilas. Após reconhecer o erro a plataforma Google decidiu remover gorilas, chimpanzés e macacos do sistema, a fim de evitar que essa rotulação “errada”, ou racista, ocorresse novamente (Salas, 2018).

A tecnologia que formula a etiquetagem de imagens ainda precisa de muitos aperfeiçoamentos, haja vista que esse fato demonstrou haver uma tendência de os algoritmos de inteligência artificial confundir dados e provocar um viés racista. O caso mostra também que há desafios amplos que a inteligência artificial deverá enfrentar ainda, entre os quais a necessária opacidade dos processos algorítmicos, bem como os riscos que podem estar relacionados a direitos individuais. Tira-se neste caso a conclusão de que a transparência e a responsabilidade civil devem estar presentes no uso de tecnologias automatizadas, pois seus impactos chegam a diversas áreas da sociedade (Salas, 2018).

Figura 1: Algoritmo “racista” apaga gorilas, macacos e chimpanzés

Fonte: Salas (2018)

4.2 O caso Google 2, a IA Gemini

O novo modelo de inteligência artificial Gemini, da plataforma Google, também já demonstrou que faz projeções e buscas com viés racista, e se for solicitado para ilustrar vikings ou soldados nazistas o resultado pode ser inesperado. Isso porque figuras, geralmente brancas, podem mudar de cor da pele e dentro dessa lógica algorítmica podem surgir papas indianos ou colonizadores de aparência indígena, o que está sendo chamado de “racismo reverso”, de forma que não há uma exatidão das etnias solicitadas pela IA. A Unicef considera o racismo um preconceito baseado na cor da pele e características físicas que estão associados às pessoas ou povos marginalizados, frequentemente considerados inferiores e desvalorizados (Monitchele, 2024).

Figura 2: Inteligência artificial Gemini provoca “racismo reverso”

Fonte: Monitchele (2024)

Segundo Monitchele (2024) O Gemini cria imagens com uma grande variedade étnica, e por isso cai no erro de confundir e/ou trocar as figuras, embora muitas outras ferramentas de IA como a DALL E e a Chart GPT, por não ter essa variedade de diferenças, também caem no mesmo erro de forma oposta, ou seja, também racista. O Ceo do Google, Sundar Pichai, reconheceu que algumas respostas dadas pelo aplicativo podem ser “ofensivas aos usuários”, mas defendeu que o comportamento das IAs nesse contexto é “completamente inaceitável”, e prometeu resolver essas questões com mudanças estruturais

4.3 As IAs e o arcabouço legal brasileiro

4.3.1 Marco civil da internet x Constituição Federal

O Marco Civil da Internet, de acordo com seu art. 10, afasta quaisquer dúvidas a respeito do sigilo a ser observado pelos provedores quanto aos registros de conexão e de acesso a aplicações de internet, dados pessoais e conteúdo de comunicações privadas dos usuários da Internet.

Segundo o Marco Civil da Internet qualquer operação que envolva coleta, armazenamento, guarda e tratamento de registros, dados pessoais ou comunicações por provedores de conexão e de aplicações de internet, onde pelo menos um desses atos se dê dentro do território brasileiro, é necessário que se respeite a legislação brasileira. A validade desta norma ocorre mesmo que as atividades sejam desenvolvidas através de pessoa jurídica que tenha sede fora do país, contanto que ofereça serviço ao público brasileiro ou pelo menos uma integrante do mesmo grupo econômico esteja estabelecida no Brasil, artigo 11.

Observa-se que o momento é de crise, no âmbito do direito brasileiro, em razão dos novos desafios referente ao avanço da tecnologia. A liberdade de expressão configura-se como essencial no sentido de que seja concretizado o princípio da dignidade humana, como modo de proteção à sociedade das opressões, essa característica tão singular, os artigos 2º e 3º da lei 12.965/2014, se apresentam claras no que se refere à proteção dos direitos das personalidades aos usuários de internet e aos princípios constitucionais civis, conforme é possível observar na análise dos arts. 2º e 3º da Lei 12.965/2014:

Art. 2º A disciplina do uso da internet no Brasil tem como fundamento o respeito à liberdade de expressão, bem como:

Art. 3º A disciplina do uso da internet no Brasil tem os seguintes princípios: I – garantia da liberdade de expressão, comunicação e manifestação de pensamento, nos termos da Constituição Federal;

II – proteção da privacidade;

III – proteção dos dados pessoais, na forma da lei;

A nova lei, como se vê, assegura princípios que foram bastante pertinentes frente à vulnerabilidade que existia na seara das leis brasileiras que se apresentavam omissas quando se tratava de matéria referente às garantias sempre que violadas na internet.

4.3.2 Inconstitucionalidade no Marco Civil e a possível aplicabilidade do código de defesa do consumidor para caracterizar a responsabilidade civil das IAs

Um ponto focal que pode ser considerado como inconstitucional, é o artigo 19 dispondo que:

O provedor de aplicações de internet somente poderá ser responsabilizado civilmente por danos decorrentes de conteúdo gerado por terceiros se, após ordem judicial específica, não tomar as providências para, no âmbito e nos limites técnicos do seu serviço e dentro do prazo assinalado, tornar indisponível o conteúdo apontado como infringente, ressalvadas as disposições legais em contrário (Lei 12.965/14).

Observa-se aqui clara contradição com relação à responsabilidade civil do “provedor de aplicações de internet” do Marco Civil e a responsabilidade disposta no Código de Defesa do Consumidor, extrajudicial e objetiva, a qual, precisa prevalecer.

É lógico deduzir que o que está exposto no artigo 15 do Marco Civil, está contido na definição de fornecedor do artigo 3º do CDC, segundo o qual:

Fornecedor é toda pessoa física ou jurídica, pública ou privada, nacional ou estrangeira, bem como os entes despersonalizados, que desenvolvem atividade de produção, montagem, criação, construção, transformação, importação, exportação, distribuição ou comercialização de produtos ou prestação de serviços.

Deste modo, “fornecedor” se traduz em um gênero do qual o “provedor de aplicações de internet” consiste em espécie, pois se este provedor de aplicações de internet exerce atividade econômica, sem dúvida alguma visa o lucro. Desta forma, também possui uma clientela e um destinatário final.

Se o artigo 15 do Marco Civil assume que o “provedor de aplicações de internet” tem finalidade econômica, de forma óbvia ele presta um serviço remunerado de forma direta ou indiretamente ao usuário, que por seu lado consiste em uma espécie do gênero consumidor.

A doutrina, assim como a jurisprudência têm compreendido que o vocábulo “remuneração” envolve não apenas a forma direta, contraprestação propriamente dita pelo serviço prestado, mas também a gratificação indireta de forma que os serviços que são aparentemente gratuitos, apenas guardam essa aparência.

Neste contexto, é preciso verificar se o fornecedor não está tendo uma remuneração indireta na relação, serviço aparentemente gratuito, pois alguns serviços, embora sejam gratuitos, são abrangidos pelo CDC, considerando que o fornecedor está de algum modo sendo remunerado pelo serviço.

Na verdade, nada é gratuito no mercado de consumo, pois um custo, acaba, direta ou indiretamente, sendo repassado ao consumidor. Assim, quando a lei fala em ‘remuneração’ não está necessariamente se referindo a preço ou preço cobrado. É necessário compreender o aspecto remuneração no sentido estrito de qualquer tipo de cobrança ou repasse, seja de forma direta ou indireta.

Frente ao exposto as decisões vinham sendo tomadas considerando que grandes provedores de aplicações da internet, como, Google e Facebook, ofereciam um serviço pautado numa remuneração indireta, consubstanciada em seus anúncios publicitários, como é possível observar nas decisões abaixo:

Inexiste violação ao art. 3º, § 2º, do Código de Defesa do Consumidor, porquanto, para a caracterização da relação de consumo, o serviço pode ser prestado pelo fornecedor mediante remuneração obtida de forma indireta (REsp n. 566.468, do Rio de Janeiro, rel. Min. Jorge Scartezzini, j. em 23-11-2004).

A exploração comercial da internet sujeita às relações de consumo daí advindas à Lei 8.078/1990. (…) O fato de o serviço prestado pelo provedor de serviço de internet ser gratuito não desvirtua a relação de consumo, pois o termo ‘mediante remuneração’, contido no art. 3º, § 2º, do CDC, deve ser interpretado de forma ampla, de modo a incluir o ganho indireto do fornecedor (REsp 1186616-MG, j. 23.08.2011, rel. Min. Nancy Andrighi).

Assim, há razões diversas para aplicar o Código do Consumidor às relações entre provedor de aplicações e usuário, haja vista que o serviço oferecido pelos provedores de aplicações de internet é remunerado (artigo 3º, § 2º do CDC) e o usuário é consumidor: “toda pessoa física ou jurídica que adquire ou utiliza produto ou serviço como destinatário final” (artigo 2º do CDC).

Desta forma não é possível excluir os provedores de aplicações de internet do campo de aplicação do CDC retirando dos consumidores direitos já consolidados, como é o caso de se ver indenizado pela responsabilização objetiva do fornecedor. O Marco Civil, de forma oposta impõe a judicialização compulsória do conflito de interesses, o que além de onerar substancialmente o consumidor, só apura responsabilidade do provedor em caso de desobediência à ordem judicial.

4.4 Ações em favor do arcabouço jurídico das Inteligências Artificiais no Brasil

O Projeto de Lei n° 2338 apresentado em 2023 pelo senador e presidente do Senado Rodrigo Pacheco (PSD/MG) aborda no campo jurídico do Direito Civil sobre Responsabilidade Civil, Economia e Desenvolvimento, Ciência, Tecnologia e Informática, Direitos e Garantias, bem como Direitos Individuais e Coletivos. O projeto entrou em fevereiro de 2024 na Comissão Temporária Interna sobre Inteligência Artificial no Brasil e aguarda tramitação regular. No primeiro artigo do projeto leia-se:

Art. 1º Esta Lei estabelece normas gerais de caráter nacional para o desenvolvimento, implementação e uso responsável de sistemas de inteligência artificial (IA) no Brasil, com o objetivo de proteger os direitos fundamentais e garantir a implementação de sistemas seguros e confiáveis, em benefício da pessoa humana, do regime democrático e do desenvolvimento científico e tecnológico.

A Análise preliminar da Autoridade Nacional de Proteção de Dados (ANPD), feita em julho do ano passado sobre o Projeto de Lei (PL) nº 2338/2023 discutido nas Coordenações-Gerais de Tecnologia e Pesquisa e de Relações Institucionais e Internacionais, destacou pontos de convergência e conflito entre o PL e a LGPD. A ANPD elogiou a inovação em IA, mas ressaltou que deve ser conduzida de forma responsável, a fim de evitar sobreposições e conflitos entre o PL e a Lei Geral de Proteção de Dados.

A regulação da inteligência artificial (IA) no Brasil iniciou a fim de responder ao avanço veloz e à adoção dessa tecnologia em muitos setores da sociedade, a fim de estabelecer diretrizes e garantir a ética, a transparência e a responsabilidade no uso da IA.

Conforme Tunholi (2024) a primeira iniciativa deu-se na Câmara dos Deputados, pelo Deputado Federal, Eduardo Bismarck (PDT-CE), que apresentou o Projeto de Lei nº 21/2020 o qual propunha um marco legal para o desenvolvimento e uso da Inteligência Artificial (IA), A partir disso as discussões se tornaram intensas e formou-se no Senado uma Comissão de Juristas (CJSUBIA) que objetivavam subsidiar a elaboração da minuta do substitutivo a partir dos projetos de lei (PLs) 5.051/2019 (Senador Styvenson Valentim – Podemos-RN – que Estabelecia os princípios para o uso da Inteligência Artificial no Brasil.); do projeto 21/2020, do Deputado Eduardo Bismarck (PDT-CE); já citado, e do projeto 872/2021 (Senador Veneziano Vital do Rêgo – MDB-PB – que tratava do uso da Inteligência Artificial.).

Foram realizadas diversas audiências públicas, que contaram com mais de 50 (cinquenta) especialistas, em múltiplos setores. Após essas audiências em maio de 2023, a comissão (CJSUBIA) elaborou seu relatório final, incluindo um anteprojeto de lei que foi convertido no PL nº 2338/2023, de autoria do Senador Rodrigo Pacheco

A regulamentação do uso de inteligência artificial no Brasil deverá ocorrer ainda este ano e sua votação deveria ocorrer até o final de abril (2024), e entre suas prerrogativas está prevista a criação de uma autoridade nacional de IA, e um registro nacional dos sistemas de inteligência artificial. Para o Senador Pacheco, o projeto de lei será o Marco Legal de Inteligência Artificial e deve estabelecer direitos que protejam o cidadão e crie ferramentas de governança, que possam ser usadas por instituições de fiscalização e supervisão de IA.

A crescente presença das IAs no cotidiano de pessoas e empresas, conforme o que elas vêm apresentando, como no caso Google 1 e 2, para exemplificar apenas dois, pode resultar em erros, especialmente em áreas sensíveis, entre as quais a de reconhecimento facial, saúde e bem estar, finanças e mercado de trabalho. A versão do projeto brasileiro foi inspirada no AI Act da União Europeia e busca regulamentar os riscos que podem estar associados à aplicação dessa tecnologia. Para isso ocorrer serão exigidos testes prévios IA antes da disponibilização comercial, bem como registro oficial dos resultados a fim de garantir a responsabilização de quem provoca erros ou possíveis crimes usando essa ferramenta. Conforme o projeto será ainda possível a autoridade competente realizar análises algorítmicas que ajudem a classificar o nível de risco de cada ferramenta (Tunholi, 2024).

Segundo Sabane, et al (2024), os algoritmos estão presentes nas mais diversas ações cotidianas, e podem influenciar diversos setores da vida moderna, e isso nem sempre será compreendido completamente por todos em seu funcionamento técnico. Já para os profissionais do Direito e legisladores, é fundamental compreender os algoritmos a fim de que possam prever e regular suas interações, evitando consequências indesejadas.

Conforme Mulholland (2020, p. 328):

Na falta de uma regulação jurídica específica sobre o tema, princípios éticos têm sido considerados a baliza dos progressos em IA constituindo-se em limite interno – no desenvolvimento dos sistemas – e externo – nas aplicações e usos da tecnologia. Tem-se, assim, que as luzes da Ética e as leis de Asimov servem como ponto de partida para o estudo sobre os impactos jurídicos do desenvolvimento e da aplicação de ferramentas que utilizam IA.

Observa-se que a Inteligência Artificial (IA) chegou a um estágio onde pode tomar decisões independentes, e por isso mesmo ela precisa estar embasada em uma abordagem ético-jurídica capaz de garantir sua integração harmoniosa com os seres humanos. Podem ser citadas as Leis de Asimov que já previam uma base ética que estivesse alinhada com o desenvolvimento das Ias, e estabelecesse princípios que auxiliassem na convivência entre robôs e humanos, haja vista que a ausência de uma regulação específica exige princípios éticos que orientadores para o progresso nesse campo de conhecimento de prática social (Sabane, et al, 2024).

Apesar das discussões sobre a atribuição de responsabilidade por ações danosas causadas por IA autônoma, ainda não há consenso sobre como lidar com essa questão. A responsabilidade civil relacionada à IA é complexa, envolvendo debates sobre quem deve responder por danos causados por máquinas inteligentes. Embora o Brasil tenha começado a discutir a regulação da IA em 2019, a prioridade para lidar com a pandemia do coronavírus adiou esse debate, destacando a necessidade de investimento e comprometimento com o tema no futuro.

5 CONCLUSÃO

A elevação da tecnologia voltada para a Inteligência Artificial (IA) na rede de computadores é indiscutível. Observa-se que gigantes da economia global, como as Big Techs, estão se voltando para o segmento das Ias e muito dessa corrida se deve à redução de custos de processamento e armazenamento, de novos paradigmas que surgiram, e da ampliação de redes neurais capazes de transmitir vasta quantidade de dados nas redes e mídias sociais.

Porém, na medida em que as IAs se tornam onipresentes em nosso cotidiano, é fundamental destacar que as questões éticas devem acompanhar seu desenvolvimento e uso, por isso mesmo deve ser feito de forma responsável.

O atual marco legal da internet não abarca todas as responsabilidades que podem ser imputadas as IAs. O alcance social e ético da IA é muito amplo e envolve sistemas de classificação que geram preocupações sobre segurança e responsabilidade. Por isso sua abordagem deve ser cautelosa e regulatória, considerando parâmetros éticos que garantam uma regulamentação apropriada, a fim de prevenir e evitar transgressões prejudiciais aos direitos fundamentais já consolidados. Torna-se também imperativo evitar conflitos entre a nova legislação para a IA e outras normativas.

O caso do Google ilustrado neste artigo, e tantos outros, suscitou um intenso debate de juristas e legisladores sobre o impacto da IA na sociedade, pois sabe-se que é uma tecnologia – mesmo estando sujeita a erros – capaz de trazer benefícios, eficiência em diversas tarefas repetitivas, pode auxiliar na melhoria da acessibilidade para muitos casos de pessoas com necessidades especiais, e por isso mesmo é crucial considerar seus potenciais desafios éticos e legais. Desse modo entende-se que a IA é uma ferramenta fundamental no desenvolvimento das nações e do progresso social, porém ela precisa estar harmonizada com os interesses coletivos para sua utilização, estar regulamentada de forma adequada a fim de preservar os direitos e garantias já previstos no ordenamento jurídico brasileiro.

Logo, a temática abordada é crucial no contexto do uso crescente da IA em diversos setores da sociedade. É preciso pensar não somente em casos expostos de preconceito gerados por meio dos algoritmos, mas também questionar sobre a responsabilidade civil das empresas e provedores de conteúdo e plataformas que desenvolvem e utilizam essas tecnologias.

No Brasil, ainda não há uma legislação específica sobre questões legais e éticas referentes ao uso das IAs, o que gera uma relevante lacuna no seu arcabouço jurídico, especialmente referente à responsabilidade civil por danos ou erros causados por algoritmos discriminatórios ou mal programados. Esse avanço é importante, pois outros países já estão elaborando suas legislações específicas sobre este tema. O Brasil passa por um momento importante com a tramitação do projeto de lei sobre as IAs, que avançam velozmente em diversos setores e precisam ter regulação para prevenir e punir consequências adversas. Por isso é fundamental que o Brasil estabeleça um arcabouço jurídico sólido, abrangente e capaz de abarcar as diversas questões relacionadas à IA e à responsabilidade civil.

Referências

ALVES, Priscila Mello. Inteligência artificial e redes neurais. [S.l.]: Centro de Pesquisa em Ciência, Tecnologia e Sociedade. Publicado em 11 jun. 2020.

BARBOSA, Mafalda Miranda. Inteligência Artificial e blockchain: desafios para a responsabilidade civil. Revista de Direito da Responsabilidade. Coimbra, ano 1, 2019.

Código de processo civil anotado/OAB. – Porto Alegre: OAB RS, 2015.

FORTES, Fabio da Silva. A dialética e as letras. Tese de Doutorado de Filosofia. Universidade de Minas Gerais. 2019, 382f. Disponível em: https://repositorio.ufmg.br/bitstream/1843/30891/1/TESE%20VERSA%CC%83O%20 FI NAL%201.pdf. Acesso: 14 out. de 2023.

FREITAS, Juarez; FREITAS, Thomas Bellini. Direito e Inteligência Artificial: em defesa do humano. Belo Horizonte: Fórum, 2020.

LEMOS, Amanda. O que é inteligência artificial e como ela funciona. São Paulo: Folha de São Paulo. Publicado em 12 mai. 2022. Disponível em: <https://www1.folha.uol.com.br/tec/2022/05/o-que-einteligencia-artificial-e-como-ela-f unciona.shtml#o-que-e-inteligencia-artificial>. Acesso em: abr. 2024.

LIMA, Isaías. Inteligência Artificial. São Paulo: Grupo GEN, 2014.

LIMA JUNIOR, Eduardo Brandão et al. ANÁLISE DOCUMENTAL COMO PERCURSO METODOLÓGICO NA PESQUISA QUALITATIVA. Cadernos da Fucamp, v.20, n.44, p.36-51/2021.

MONITCHELE, Marília. Inteligência artificial do Google é acusada de “racismo reverso”. Atualizado em 29 fev 2024, 18h08 – Publicado em 29 fev 2024, 17h22. Disponível em https://veja.abril.com.br/tecnologia/inteligencia-artificial-do-google-e-acusada-de-raci smo-reverso. Acesso em Acesso em 26 abr. 2024.

MULHOLLAND, Caitlin. Responsabilidade Civil e Processos Decisórios Autônomos em Sistemas de Inteligência Artificial (IA): Autonomia, Imputabilidade e Responsabilidade. In: MULHOLLAND, Caitlin. et al. Inteligência Artificial e Direito. 2 Ed. São Paulo: Thomson Reuters Brasil, 2020.

OLIVEIRA, Gustavo Henrique; REMÉDIO, José Antônio. Responsabilidade civil: a equidade como parâmetro para fixação da indenização no caso de excessiva desproporção entre a gravidade da culpa e o dano civil. Revista Brasileira de Direito Civil – RBDCivil | Belo Horizonte, v. 31, n. 2, p. 97-121, abr./jun. 2022

ROSA, Ana Carolina Salituri. Inteligência Artificial e Responsabilidade Civil no Brasil: Qual o regime aplicável? Trabalho de Conclusão de Curso apresentado à Escola de Direito de São Paulo da Fundação Getúlio Vargas para obtenção de grau de bacharel em Direito. Campo do conhecimento: Direito civil e tecnologia. Orientadora: Professora Dra. Renata Carlos Steiner Reisdorfer São Paulo 2022.

SABANE, Thiago Motizuki;TRIGO, Nilton Godoy; RUBELO, João Geraldo Nunes; SIMONCELLI, Helton Laurindo. Inteligência Artificial e sua relação com o Direito no Brasil Artificial Disponível em https://unisalesiano.com.br/aracatuba/wp-content/uploads/2022/08/Artigo-Inteligencia -Artificial-e-sua-relacao-com-o-Direito-no-Brasil-Pronto.pdf. Acesso em 25 abr. 2024.

SALAS, Javier. Jornal El País. Google conserta seu algoritmo “racista” apagando os gorilas. Postado em 2018. Disponível em https://brasil.elpais.com/brasil/2018/01/14/tecnologia/1515955554_803955.html. Acesso em 25 abr. 2024.

SILVA, Fabrício M. (et al.). Inteligência artificial. São Paulo: Grupo A, 2018. TUNHOLI, Murilo. Lei que regula IA no Brasil deve ser votada até abril; entenda projeto. Disponível em https://gizmodo.uol.com.br/lei-que-regula-ia-no-brasil-deve-ser-votada-ate-abril-enten da-projeto/. Acesso em abr. 2024.

[1] O ato ilícito é uma atitude que causa danos a outrem gerando o dever de indenização ao causador do prejuízo, vale ressaltar que esse prejuízo pode ser material, moral, emergente ou lucros cessantes.