DEVELOPMENT OF AN AUTONOMOUS HUMAN DETECTION SYSTEM IN SECURITY CAMERAS

REGISTRO DOI: 10.69849/revistaft/ar10202412061747

Leandro Victor Costa Reghini¹;

Orientador: André Luiz da Silva²;

Coorientador: Fabiana Florian³.

Resumo: Este estudo propõe o desenvolvimento de um sistema autônomo para detecção de presença humana em imagens de vídeo em tempo real, provenientes de câmeras, com foco em câmeras de segurança. Utilizando o Mercado Reghini, localizado em Itápolis-SP, como estudo de caso, o sistema busca enfrentar o desafio de distinguir movimentos humanos de outras fontes de movimentação, como animais, motivando assim a criação de uma solução eficiente.

Para o desenvolvimento do sistema foram utilizadas as tecnologias, Python, OpenCV, Deep Learning, CNNs (Redes Neurais Convolucionais), Pytorch, Lógica de Controle e demais outras, assim oferecendo uma base sólida e robusta. Funcionará como uma extensão para quaisquer marcas e modelos de câmeras. A finalidade dessa pesquisa é identificar a presença de indivíduos nas imagens capturadas e, quando uma pessoa for detectada, o sistema tomará ações automatizadas baseadas no nível da situação que está ocorrendo. Essas funcionalidades visam aumentar a eficiência e a segurança dos sistemas de vigilância por vídeo, possibilitando futuras implementações em formato de aplicativo móvel para maior acessibilidade e dinamismo.

A proposta destaca-se pelo potencial de aplicação em ambientes diversos. O sistema será desenvolvido com foco em escalabilidade e adaptabilidade, utilizando tecnologias adequadas para processamento em tempo real e tomada de decisões automatizadas. Como resultado esperado, busca-se demonstrar a eficácia do sistema na detecção de pessoas e na resposta imediata a eventos de segurança, sem a necessidade de intervenção humana constante.

Palavras-chave: AUTOMAÇÃO. CÂMERAS. DETECÇÃO. HUMANA. PYTHON. SEGURANÇA.

Abstract: This study proposes the development of an autonomous system for detecting human presence in real-time video images from cameras, focusing on security cameras. Using Mercado Reghini, located in Itápolis-SP, as a case study, the system seeks to face the challenge of distinguishing human movements from other sources of movement, such as animals, thus motivating the creation of an efficient solution.

To develop the system, Python, OpenCV, Deep Learning, CNNs (Convolutional Neural Networks), Pytorch, Control Logic and other technologies were used, thus offering a solid and robust foundation. It will work as an extension for any camera brands and models. The purpose of this research is to identify the presence of individuals in the captured images and, when a person is detected, the system will take automated actions based on the level of the situation that is occurring. These functionalities aim to increase the efficiency and security of video surveillance systems, enabling future implementations in mobile application format for greater accessibility and dynamism.

The proposal stands out for its potential for application in different environments. The system will be developed with a focus on scalability and adaptability, using suitable technologies for real-time processing and automated decision making. As an expected result, we seek to demonstrate the effectiveness of the system in detecting people and responding immediately to security events, without the need for constant human intervention.

Keywords: AUTOMATION, CAMERAS, DETECTION, HUMAN, PYTHON, SECURITY.

1 INTRODUÇÃO

Este trabalho tem o objetivo de desenvolver de um sistema autônomo para detecção de presença humana em tempo real em imagens de vídeo capturadas por câmeras de segurança, tendo como o principal desafio a precisão na distinção entre movimentos humanos e outras formas de movimentação, como animais, que frequentemente resulta em falsos positivos e ações inadequadas nos sistemas convencionais de detecção de movimento.

A proposta se concentra na aplicação de tecnologias avançadas de visão computacional, como Deep Learning e Redes Neurais Convolucionais (CNNs), visando aprimorar a detecção em tempo real. A finalidade desta pesquisa é oferecer maior eficiência e confiabilidade na segurança por meio da vigilância por vídeo, com o desenvolvimento de um sistema capaz de identificar com precisão a presença de pessoas nas imagens capturadas. Essa abordagem busca minimizar falsos positivos e melhorar a capacidade de resposta a eventos de segurança em tempo real.

O sistema foi projetado para identificar indivíduos em imagens capturadas por câmeras, quando uma pessoa for detectada, o sistema tomará ações automatizadas baseadas no nível da situação que está ocorrendo, como acionamento de luzes, ativação de alarmes, notificação do proprietário do local ou se o nível for critico a contatação de autoridades competentes.

A proposta de desenvolvimento do sistema autônomo ocorrerá em um mercado localizado no município de Itápolis, SP.

Atualmente há falhas no sistema de segurança do local a ser estudado em distinguir com precisão movimentos humanos de outras formas de movimentação em imagens de vídeo de câmeras de segurança, levando a sistemas de detecção que frequentemente geram falsos alarmes. A suposição é que um sistema baseado em tecnologias avançadas de visão computacional, como Deep Learning e Redes Neurais Convolucionais (CNNs), pode-rá resolver o problema. Treinando esses algoritmos em conjuntos de dados específicos, o sistema será capaz de identificar com precisão a presença de pessoas em tempo real, reduzindo falsos positivos.

O sistema foi avaliado em cenários reais de vigilância, considerando condições de iluminação variadas e a presença de animais. A eficácia do sistema foi medida pela taxa de detecção correta de pessoas em relação aos casos totais, comparando com sistemas convencionais de detecção de movimento, como a detecção de movimento por diferenciação de quadros (frame differencing) e o uso de histogramas de gradientes orientados (HOG) combinados com SVM (Dalal & Triggs, 2005).

Foi realizado pesquisa bibliográfica para fundamentar o desenvolvimento de um sistema autônomo de detecção de presença humana em imagens de vídeo, com foco em câmeras de segurança. A proposta baseia-se na aplicação de tecnologias avançadas de visão computacional, como Redes Neurais Convolucionais (CNNs) e Deep Learning, com o objetivo de superar as limitações de sistemas tradicionais que frequentemente geram falsos positivos devido à dificuldade de diferenciar movimentos humanos de outras fontes, como animais.

O desenvolvimento do sistema foi conduzido em etapas que incluem o treinamento de modelos de detecção utilizando a linguagem Python e bibliotecas especializadas, como OpenCV e PyTorch, aproveitando sua capacidade de processar imagens em tempo real e treinar algoritmos complexos com alta precisão. Em seguida, foi implementado um módulo de controle integrado, responsável por realizar ações automatizadas baseadas na identificação de pessoas, como o acionamento de luzes, alarmes e notificações.

O sistema foi avaliado em cenários reais, considerando variáveis como mudanças de iluminação e interferência de outros objetos em movimento. A eficácia foi mensurada pela taxa de detecção correta de pessoas em relação a sistemas convencionais, utilizando métricas comparativas entre os métodos desenvolvidos e abordagens tradicionais, como histogramas de gradientes orientados (HOG) combinados com SVM.

Inspirado pelo livro ‘Deep Learning for Computer Vision’ de Rajalingappaa Shanmugamani (2018), que explora o uso de técnicas de aprendizado profundo para a detecção de objetos em imagens, optou-se por empregar abordagens avançadas de inteligência artificial para aprimorar a detecção humana em nosso sistema de segurança. Essa escolha estratégica nos permitiu alcançar níveis mais elevados de precisão e eficiência na identificação e monitoramento de atividades suspeitas, contribuindo significativamente para a proteção e vigilância do local.

Por fim, o sistema foi projetado com arquitetura escalável, permitindo integração com diferentes modelos de câmeras e futura adaptação para dispositivos móveis. A implementação buscará promover maior eficiência na vigilância, reduzindo alarmes falsos e aumentando a confiabilidade em situações de segurança.

2 REVISÃO BIBLIOGRÁFICA

Esta seção apresenta os fundamentos teóricos e tecnológicos utilizados no desenvolvimento do sistema autônomo de detecção de presença humana em imagens de vídeo, com ênfase nas ferramentas e abordagens que viabilizam a solução proposta. São abordados conceitos relacionados à visão computacional, Redes Neurais Convolucionais (CNNs), técnicas de Deep Learning, e a utilização de bibliotecas como OpenCV e PyTorch, fundamentais para a implementação do sistema. Além disso, discute-se a integração do sistema com dispositivos de controle e o uso de bancos de dados para armazenamento e gerenciamento eficiente das informações.

2.1 Python:

Python é uma linguagem de programação amplamente adotada e preferida em projetos de visão computacional devido à sua versatilidade e vasta coleção de bibliotecas especializadas (Van Rossum & Drake, 2009). Para este projeto específico, o Python será a base principal devido à sua robusta biblioteca de visão computacional, incluindo o OpenCV (Open Source Computer Vision Library) (Bradski, 2000). O OpenCV é uma ferramenta essencial para processamento de imagens e vídeos em tempo real, possibilitando desde a captura de frames até a análise de conteúdo visual. A escolha do Python é motivada por sua eficiência no processamento de imagens em tempo real, sendo altamente compatível com frameworks de Deep Learning como PyTorch (Paszke et al., 2019). Essa compatibilidade permitirá a implementação de algoritmos avançados de detecção de pessoas com alto desempenho e precisão.

2.2 OpenCV:

O OpenCV é uma biblioteca de visão computacional de código aberto amplamente utilizada em uma variedade de aplicações, incluindo sistemas de segurança baseados em visão. No contexto deste projeto, o OpenCV desempenhará um papel fundamental na captura, pré-processamento e análise das imagens provenientes das câmeras de segurança. Com o OpenCV, é possível realizar tarefas como detecção de movimentos, rastreamento de objetos e reconhecimento facial, fornecendo as bases para a implementação de sistemas de detecção de presença humana em tempo real (Bradski, 2000).

2.3 Deep Learning e Redes Neurais Convolucionais (CNNs):

As tecnologias de Deep Learning, especialmente as Redes Neurais Convolucionais (CNNs), são fundamentais para o treinamento de modelos capazes de identificar com precisão a presença de pessoas em imagens de vídeo. O uso de Deep Learning em conjunto com CNNs permite que o sistema aprenda padrões complexos e contextuais nas imagens, reduzindo significativamente os falsos positivos e melhorando a confiabilidade da detecção em tempo real (LeCun et al., 2015; Krizhevsky et al., 2012). A capacidade de aprender com exemplos e adaptar-se a diferentes condições de iluminação e cenários é uma característica essencial para a eficácia do sistema autônomo de detecção.

2.4 PyTorch:

PyTorch é um poderoso framework de Deep Learning conhecido por sua flexibilidade e eficácia na implementação de algoritmos de aprendizado de máquina. Neste projeto, o PyTorch será utilizado para implementar e treinar modelos de detecção de pessoas. Sua arquitetura dinâmica e suporte integrado a GPU proporcionam um processamento eficiente e escalável, permitindo o desenvolvimento de soluções avançadas de visão computacional (Paszke et al., 2019).

2.5 Sistema de Controle:

O sistema de controle do sistema autônomo de detecção de presença humana desempenha um papel crucial na tomada de decisões automatizadas com base na detecção de pessoas em imagens de vídeo. Esse sistema será desenvolvido utilizando técnicas avançadas de lógica de controle e processamento de sinais, com o objetivo de garantir respostas rápidas e precisas diante das situações identificadas (Dorf & Bishop, 2011; Astrom & Murray, 2010).

Para alcançar essa eficiência, o sistema utilizou algoritmos de processamento de imagens em tempo real, integrados com redes neurais convolucionais treinadas para identificação de pessoas. Após a detecção de uma pessoa em uma imagem, o sistema ativará uma série de ações automatizadas, como acionar alarmes, controlar o acendimento de luzes ou notificar autoridades relevantes.

A implementação do sistema de controle foi cuidadosamente planejado para lidar com diferentes cenários e condições adversas, como mudanças na iluminação, variações de fundo e a presença de animais. Além disso, foi considerado a integração com APIs ou bibliotecas específicas para o controle de dispositivos externos, garantindo uma resposta adequada e eficaz às detecções realizadas pelo sistema.

O sistema de controle também foi configurado para aprender com o feedback das ações tomadas, refinando continuamente sua capacidade de identificar e responder às presenças humanas de forma precisa e confiável. Dessa forma, o sistema autônomo será capaz de adaptar suas decisões com base nas condições reais observadas, proporcionando um alto nível de eficácia e segurança na detecção de presença humana em imagens de vídeo em tempo real.

2.6 Integração com Dispositivos de Controle:

A integração com dispositivos externos será realizada utilizando APIs ou bibliotecas especializadas para controlar elementos como luzes, alarmes e sistemas de notificação, como o Twilio para mensagens SMS. Essa integração garantirá uma resposta rápida e eficiente às detecções realizadas pelo sistema, melhorando a segurança e eficácia das medidas automatizadas. O uso de APIs modernas e confiáveis permitirá uma comunicação eficiente entre o sistema autônomo e os dispositivos externos, possibilitando uma integração completa e funcional do sistema de detecção.

2.7 Bancos de Dados:

Um componente essencial para o sistema autônomo de detecção de presença humana é o banco de dados, responsável por armazenar e gerenciar dados críticos para o funcionamento do sistema. O banco de dados será projetado com foco na escalabilidade, eficiência e segurança dos dados. Para isso, foi utilizado um sistema de gerenciamento de banco de dados (SGBD) confiável e adequado às necessidades do projeto, como PostgreSQL ou MySQL.

A arquitetura do banco de dados foi cuidadosamente planejada para suportar grandes volumes de dados provenientes das câmeras de segurança, incluindo registros de detecção, configurações do sistema e informações de histórico. Foram definidas tabelas bem estruturadas para armazenar informações específicas, garantindo uma organização eficiente e facilitando a recuperação de dados durante as operações do sistema.

Além disso, foram implementadas medidas robustas de segurança para proteger os dados sensíveis, como autenticação de usuários, criptografia de dados e controle de acesso baseado em funções. Essas medidas visam garantir a integridade e confidencialidade dos dados armazenados, mitigando riscos de violação de segurança e garantindo conformidade com padrões de privacidade e regulamentações aplicáveis.

A escolha do banco de dados e a implementação da sua arquitetura serão guiadas pela necessidade de fornecer um ambiente confiável e de alto desempenho para o armazenamento e gerenciamento dos dados do sistema autônomo. O objetivo é garantir que o banco de dados seja uma parte robusta e essencial da infraestrutura do sistema, permitindo a expansão e evolução futuras conforme as necessidades e demandas do projeto.

3. DESENVOLVIMENTO DO SISTEMA AUTÔNOMO

Esta seção apresenta o processo de desenvolvimento de um sistema autônomo para detecção de presença humana em imagens capturadas por câmeras de segurança. O sistema foi projetado com base na aplicação de tecnologias avançadas de visão computacional, utilizando Python, OpenCV e a arquitetura YOLO (You Only Look Once), amplamente reconhecida por sua eficiência em tarefas de detecção em tempo real. O objetivo principal é oferecer uma solução robusta e confiável para monitoramento de segurança, capaz de identificar indivíduos com precisão, mesmo em condições desafiadoras, como baixa iluminação ou presença de objetos em movimento.

O desenvolvimento inclui desde a etapa de treinamento de modelos de Redes Neurais Convolucionais (CNNs) com técnicas de Deep Learning, até a integração do sistema com dispositivos de controle para ações automatizadas, como envio de alertas por e-mail, ativação de alarmes sonoros e acionamento de luzes. O projeto visa superar limitações de sistemas convencionais, reduzindo falsos positivos e aumentando a eficácia na detecção de pessoas em tempo real, promovendo maior eficiência e dinamismo na vigilância por vídeo.

3.1. Arquitetura do Sistema

O sistema desenvolvido consiste em três componentes principais:

Hardware:

Câmera de Segurança: Captura contínua de vídeo para análise.

Computador: Processa os dados de vídeo em tempo real utilizando Python e bibliotecas de visão computacional.

Conexão à Internet: Necessária para o envio de alertas por e-mail.

Software:

Python: Linguagem de programação utilizada para implementar a lógica do sistema.

OpenCV: Biblioteca de visão computacional para processamento de imagens e vídeos.

YOLOv3: Modelo de detecção de objetos em tempo real.

smtplib e email.mime: Bibliotecas para envio de e-mails automáticos.

playsound: Biblioteca para reprodução de alertas sonoros.

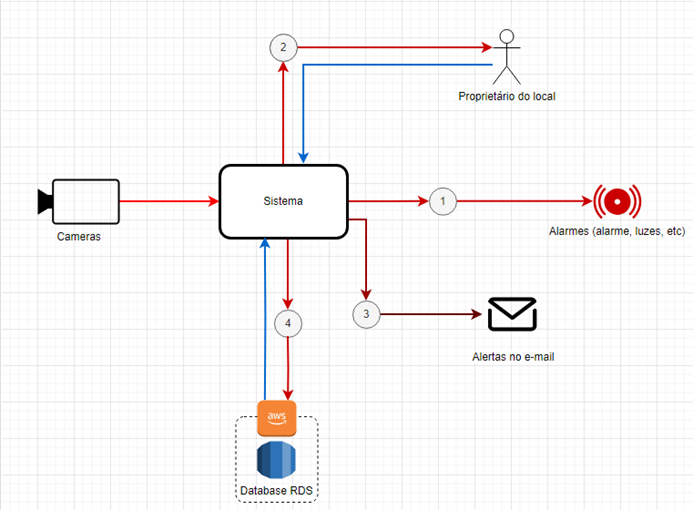

Uma visão abrangente e detalhada do funcionamento do sistema é apresentada por meio do diagrama de fluxograma ilustrado na Figura 1. Esse diagrama destaca as etapas principais do processo, desde a captura de imagens pelas câmeras de segurança até a realização de ações automatizadas, como envio de alertas e acionamento de dispositivos, permitindo compreender de forma clara e objetiva a arquitetura e o fluxo operacional do sistema.

Figura 1 – Diagrama de fluxograma do sistema

3.2. Ambiente de Desenvolvimento

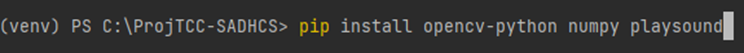

Para o desenvolvimento do sistema, foi criado um ambiente virtual Python para gerenciar as dependências e garantir a compatibilidade das bibliotecas utilizadas. Onde uma das principais bibliotecas instaladas, que é a OpenCV é mostrada na Figura 2:

Figura 2 – Print do terminal.

Além disso, foi necessário baixar os arquivos de configuração e pesos do YOLOv3, bem como o arquivo coco.names que contém as classes de objetos que o modelo pode detectar.

3.3. Implementação

3.3.1. Configuração do Modelo YOLOv3

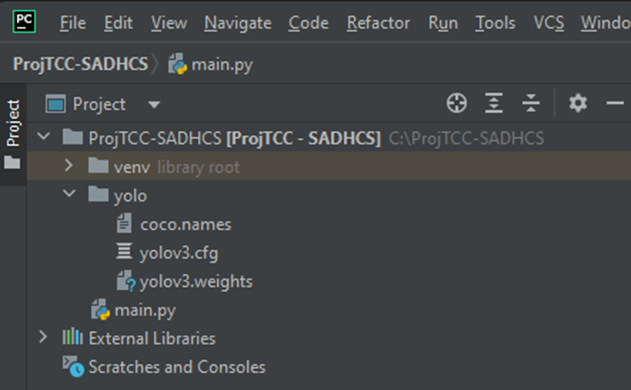

Primeiramente, os arquivos essenciais do YOLOv3 foram organizados de uma forma que fique clara e de fácil acesso como é retratado na Figura 3.

Figura 3 – Print da estrutura no PyCharm.

yolov3.cfg: Arquivo de configuração do modelo.

yolov3.weights: Arquivo contendo os pesos treinados do modelo.

coco.names: Lista de classes que o modelo pode detectar.

3.3.2. Desenvolvimento do Código Python

O script main.py inicia definindo os caminhos dos arquivos essenciais do modelo YOLOv3, como o arquivo de configuração, pesos e classes, garantindo que estejam corretamente localizados. Caso algum arquivo não seja encontrado, o sistema interrompe a execução e informa qual arquivo está faltando, evitando falhas durante o processo de detecção.

Após verificar os arquivos, o código carrega o modelo YOLOv3 utilizando o OpenCV e mapeia as camadas de saída necessárias para realizar as detecções. As classes de objetos são lidas do arquivo coco.names, permitindo que o sistema associe as detecções aos rótulos corretos, como “pessoa” no caso de humanos detectados.

Além disso, o sistema utiliza cores aleatórias para desenhar caixas delimitadoras em torno dos objetos detectados, facilitando a visualização. Quando um humano é identificado, o sistema emite um alerta sonoro e envia um e-mail de notificação, integrando diversas funcionalidades de forma eficiente.

Essa estrutura modular e bem definida garante a correta inicialização e execução da detecção de humanos, oferecendo um sistema robusto e flexível, pronto para a aplicação em sistemas de segurança.

3.3.3. Envio de Alertas por E-mail

Para implementar a funcionalidade de envio de alertas por e-mail, utilizamos as bibliotecas smtplib e email.mime. Devido a restrições de segurança do Gmail, foi necessário gerar uma senha de aplicativo para autenticação.

Passos para Configuração do Envio de E-mails:

Verificação em Duas Etapas: Ative a verificação em duas etapas na sua conta do Google.

Geração de Senha de Aplicativo:

Acesse Minha Conta do Google.

Vá para a seção “Segurança”.

Em “Fazer login no Google”, selecione “Senhas de aplicativos”.

Gere uma nova senha para “Mail” e “Outro (nome personalizado)”, por exemplo, “Python SMTP”.

Atualização do Código:

Substitua “seu_email@gmail.com” e “sua_senha_de_aplicativo” pelas suas credenciais.

Defina o destinatário em “destinatario@gmail.com”.

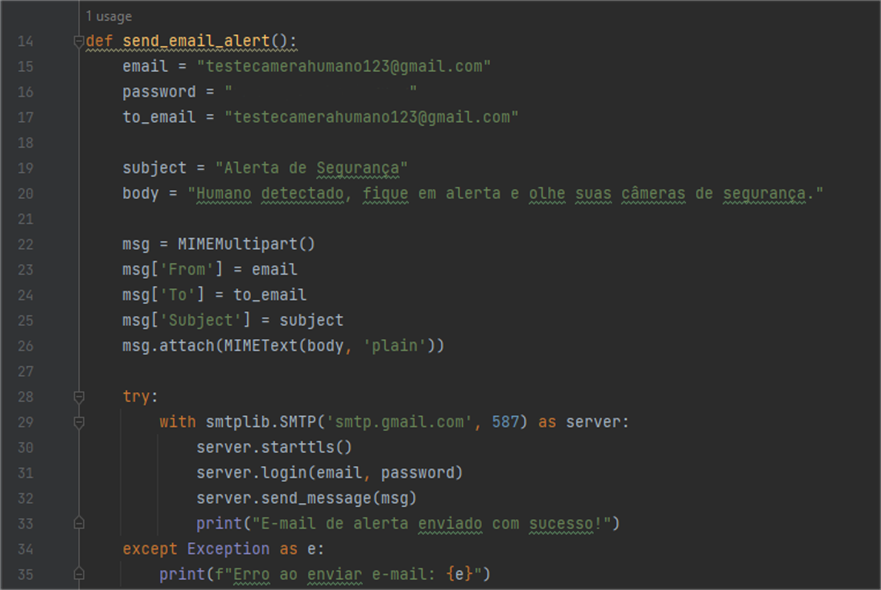

Na figura 4 é ilustrado melhor o código para envio do e-mail.

Figura 4 – Print do código, na sessão do e-mail.

3.4. Integração das Funcionalidades

O código principal integra a detecção de humanos com o envio de alertas sonoros e por e-mail. Para evitar o envio repetitivo de e-mails, implementamos uma variável de controle alert_sent que garante que o alerta seja enviado apenas uma vez por detecção contínua.

3.5. Otimização de Desempenho

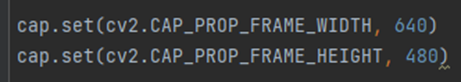

Para melhorar os FPS (frames por segundo) do sistema, foram adotadas as seguintes estratégias:

Redução da Resolução do Vídeo: Configuramos a câmera para capturar vídeo com resolução de 640×480 pixels, reduzindo a quantidade de dados a serem processados, sendo melhor retratado na Figura 5.

Figura 5 – Print do código.

Uso de YOLOv5: Considerando a superioridade do YOLOv5 em termos de desempenho e precisão em comparação com o YOLOv3, migramos para esta versão mais otimizada.

Processamento Assíncrono: Implementamos threads para captura de vídeo e envio de alertas, garantindo que o processamento de um não interfira no outro.

3.6. Testes e Validação

Foi realizado diversos testes para garantir a eficácia do sistema:

Detecção em Diferentes Condições de Iluminação: O sistema foi testado em ambientes com iluminação variada para avaliar a robustez da detecção.

Tempo de Resposta: Medimos o tempo entre a detecção de um humano e o envio do alerta para garantir que o sistema reage em tempo real.

Taxa de Falsos Positivos/Negativos: Avaliamos a precisão do sistema para minimizar alarmes falsos e garantir que humanos sejam detectados corretamente.

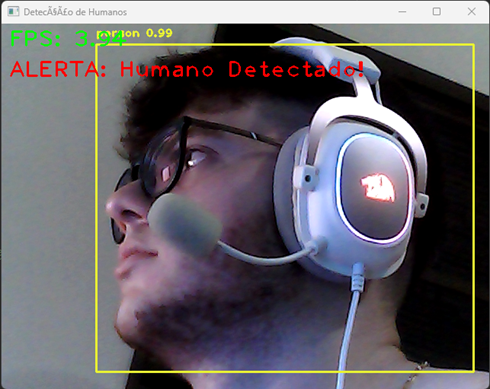

3.7. Resultados Obtidos

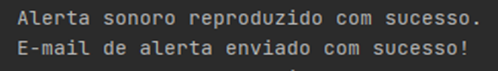

Os testes realizados demonstraram que o sistema é capaz de detectar humanos com alta precisão em tempo real, mantendo uma taxa de FPS satisfatória para aplicações práticas. O envio de alertas sonoros e por e-mail funcionou de maneira eficiente, garantindo que os usuários sejam notificados imediatamente após a detecção.

Depois de diversos testes vemos na Figura 6 o funcionamento validado com sucesso:

Figura 6 – Print da tela em funcionamento.

Os sistemas de alerta também estão funcionando perfeitamente, como mostra a Figura 7:

Figura 7 – Print do funcionamento.

3.8. Desafios Encontrados

Durante o desenvolvimento, foi enfrentado alguns desafios, como a autenticação com o Gmail: Inicialmente, tivemos dificuldades com a autenticação SMTP devido às restrições de segurança do Gmail. Resolvemos isso gerando uma senha de aplicativo específica.

Desempenho do Modelo: Garantir que o sistema operasse em tempo real exigiu otimizações na resolução do vídeo e na implementação do modelo de detecção.

Gestão de Alertas: Evitar o envio repetitivo de e-mails foi essencial para não sobrecarregar o sistema de notificações. Implementamos uma lógica de controle para gerenciar isso.

3.9. Considerações Finais

O desenvolvimento deste sistema de detecção de humanos em câmeras de segurança demonstrou a eficácia das tecnologias de visão computacional e aprendizado de máquina para aplicações de segurança. As integrações realizadas permitiram a criação de um sistema robusto, capaz de operar em tempo real e fornecer alertas automáticos, contribuindo significativamente para a segurança e monitoramento eficaz.

REFERÊNCIAS BIBLIOGRÁFICAS

ÅSTRÖM, Karl Johan; MURRAY, Richard M. Feedback Systems: An Introduction for Scientists and Engineers. Princeton University Press, 2010.

BRADSKI, Gary. The OpenCV Library. Dr. Dobb’s Journal of Software Tools, 2000.

DALAL, Navneet; TRIGGS, Bill. Histograms of Oriented Gradients for Human Detection. In: Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR’05). 2005. p. 886-893.

DENG, Jia; DONG, Wei; SOCHER, Richard; LI, Li-Jia; LI, Kai; FEI-FEI, Li. ImageNet: A large-scale hierarchical image database. In: 2009 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2009. p. 248-255.

DORF, Richard C.; BISHOP, Robert H. Modern Control Systems. 12th ed. Upper Saddle River: Prentice Hall, 2011.

KRIZHEVSKY, Alex; SUTSKEVER, Ilya; HINTON, Geoffrey E. Imagenet classification with deep convolutional neural networks. In: Advances in Neural Information Processing Systems. 2012. p. 1097-1105.

LECUN, Yann; BENGIO, Yoshua; HINTON, Geoffrey. Deep learning. Nature, v. 521, n. 7553, p. 436-444, 2015.

LIN, Tsung-Yi; MAIRE, Michael; BELONGIE, Serge; et al. Microsoft COCO: Common objects in context. In: European Conference on Computer Vision. Springer, Cham, 2014. p. 740-755.

PASZKE, Adam; GROSS, Sam; MASSA, Francisco; et al. PyTorch: An Imperative Style, High-Performance Deep Learning Library. In: Advances in Neural Information Processing Systems. 2019. p. 8024-8035.

REDMON, Joseph; DIVVALA, Santosh; GIRSHICK, Ross; FARHADI, Ali. You Only Look Once: Unified, Real-Time Object Detection. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016.

SHANMUGAMANI, Rajalingappaa. Deep Learning for Computer Vision. Birmingham: Packt Publishing, 2018.

¹Graduando do Curso de Sistemas de Informação da Universidade de Araraquara – UNIARA. Araraquara-SP. E-mail: lvcreghini@uniara.edu.br

²Orientador. Docente do Curso de Sistemas de Informação da Universidade de Araraquara – UNIARA. Araraquara-SP. E-mail: alsilva@uniara.edu.br

³Coorientadora. Docente do Curso de Sistemas de Informação da Universidade de Araraquara – UNIARA. Araraquara-SP. E-mail: fflorian@uniara.edu.br