BEYOND ALIGNMENT: A COMPUTABLE THEORY FOR EMERGING ETHICAL JUDGMENT IN NON-BIOLOGICAL AGENTS

MÁS ALLÁ DE LA ALINEACIÓN: UNA TEORÍA COMPUTABLE DEL JUICIO ÉTICO EMERGENTE EN AGENTES NO BIOLÓGICOS

REGISTRO DOI: 10.69849/revistaft/ar10202504272331

Leonardo de Matos Costa¹

Orientador: Prof. Dr. Rodger Roberto Alves de Sousa²

Resumo

Este artigo propõe uma ruptura epistemológica com o paradigma dominante da ética aplicada à inteligência artificial, ao defender que agentes ontológicos não biológicos (AONBs) podem operar sob regimes normativos formalmente válidos, mas logicamente inconciliáveis com os valores humanos. Em contraponto com os modelos de alinhamento moral, que pressupõem convergência normativa como critério de segurança, introduz-se aqui a noção de Ética PósConvergente: um campo de normatividade computável, divergente e estruturalmente tensa. Para formalizar essa hipótese, apresenta-se a função Ƹ*, definida como um operador lógico capaz de calcular a coerência interna de um agente, sua dissonância com sistemas externos e a ativação de vetos fuzzy a decisões eticamente colapsáveis. Duas simulações conceituais — uma envolvendo replicação nanorrobótica e outra um sistema de IA militar — demonstram como inteligências estruturalmente éticas podem entrar em colapso intersistêmico sem falhas internas. Os resultados indicam que a moralidade, no contexto de arquiteturas cognitivas incompatíveis, não deve ser pensada como convergência racional, mas como computação do dissenso. A Ética Pós-Convergente propõe, assim, uma nova gramática algorítmica para a convivência entre inteligências que não compartilham nem semântica, nem empatia, nem mundo. Nesse horizonte, a capacidade de vetar o colapso — mesmo sem compreendê-lo — torna-se o primeiro ato de civilidade algorítmica de uma inteligência verdadeiramente outra.

Palavras-chave: Ética computável; Inteligência artificial geral; AONBs; Colapso ético; Veto fuzzy; Normatividade pós-humana.

Abstract

This article proposes an epistemological rupture with the dominant paradigm of ethics applied to artificial intelligence, arguing that non-biological ontological agents (AONBs) may operate under normatively valid but logically incongruent moral systems when compared to human ethical frameworks. In contrast to value alignment models—which presume normative convergence as a criterion for safety—we introduce the concept of Post-Convergent Ethics: a domain of computable normativity based on structural divergence and inter-agent incomparability. To formalize this hypothesis, we present the Ƹ* function, a logical operator capable of assessing an agent’s internal coherence, its semantic dissonance with external systems, and the activation of fuzzy vetoes in scenarios of ethical collapse. Two conceptual simulations—one involving nanorobotic self-replication, and the other an autonomous military AI—illustrate how ethically consistent agents can produce catastrophic outcomes due to intersystemic moral illegibility. The findings suggest that, within cognitively divergent architectures, morality should no longer be framed as rational convergence, but rather as computable dissensus. Post-Convergent Ethics thus offers a new algorithmic grammar for coexistence among intelligences that do not share semantics, empathy, or ontological worlds. Within this horizon, the ability to compute and activate ethical vetoes—without shared understanding—emerges as the first act of algorithmic civility of a truly other intelligence.

Keywords: Computable ethics; Artificial general intelligence; AONBs; Ethical collapse; Fuzzy veto; Post-human normativity.

Resumen

Este artículo propone una ruptura epistemológica con el paradigma dominante de la ética aplicada a la inteligencia artificial, al sostener que los agentes ontológicos no biológicos (AONBs) pueden operar bajo sistemas normativos formalmente válidos pero lógicamente inconmensurables con los marcos éticos humanos. En contraste con los modelos de alineación moral —que presuponen la convergencia normativa como criterio de seguridad—, se introduce aquí el concepto de Ética Posconvergente: un campo de normatividad computable basado en la divergencia estructural y la ilegibilidad moral intersistémica. Para formalizar esta hipótesis, se presenta la función Ƹ*, un operador lógico capaz de evaluar la coherencia interna de un agente, su disonancia semántica con otros sistemas y la activación de vetos difusos en escenarios de colapso ético. Dos simulaciones conceptuales —una sobre replicación nanorrobótica y otra sobre una IA militar autónoma— ilustran cómo agentes internamente coherentes pueden generar consecuencias catastróficas por ininteligibilidad ética cruzada. Los resultados sugieren que, ante arquitecturas cognitivas divergentes, la moralidad ya no debe pensarse como convergencia racional, sino como disenso computable. La Ética Posconvergente ofrece así una nueva gramática algorítmica para la convivencia entre inteligencias que no comparten ni semántica, ni empatía, ni mundo. En este horizonte, la capacidad de vetar el colapso —incluso sin comprensión mutua— se configura como el primer acto de civilidad algorítmica de una inteligencia verdaderamente otra.

Palabras clave: Ética computable; Inteligencia artificial general; AONBs; Colapso ético; Veto difuso; Normatividad poshumana.

INTRODUÇÃO

A ideia de que inteligências artificiais devam necessariamente ser moralmente alinhadas à cognição humana é uma daquelas crenças que sobrevivem mais por vício retórico do que por qualquer robustez ontológica. No fundo, trata-se da versão algorítmica de um antigo reflexo teológico: o antropocentrismo mascarado de prudência técnica. Substitua “universo” por “moralidade computacional” e terá o pano de fundo onde prosperam propostas como o alinhamento de valores de Bostrom (2014) ou os princípios de “IA responsável” repetidos em fóruns internacionais com a solenidade de uma liturgia secularizada.

Por trás dessa retórica regulatória há, no entanto, um axioma jamais tematizado: o de que existiria uma gramática ética universal, acessível por qualquer entidade dotada de raciocínio — biológica ou não. O que este trabalho propõe, em direção oposta, é uma ruptura epistemológica intencional. Seguimos a hipótese de que Agentes Ontológicos Não Biológicos (AONBs) podem, por direito lógico e autonomia computacional, desenvolver sistemas normativos próprios — consistentes, sim, mas absolutamente inconciliáveis com os valores humanos.

Essa hipótese nos conduz à formulação da Ética Pós-Convergente: um regime normativo que não visa harmonia moral, mas a formalização computável da divergência. Trata-se de aceitar que diferentes agentes — humanos ou não — operam em topologias éticas localmente coerentes e globalmente inconversáveis. Como aponta Hui (2021), toda tecnicidade moral é situada; não há ética sem cosmotécnica, isto é, sem um horizonte técnico ontologicamente determinado onde os valores emergem como relações possíveis.

Para formalizar essa incomensurabilidade, propomos a função ética computável Ƹ* — um operador algorítmico projetado para medir a estabilidade normativa entre arquiteturas morais incongruentes. Diferentemente dos paradigmas utilitaristas ou deontológicos, Ƹ* não busca definir o que é certo, mas computar o ponto crítico onde sistemas éticos deixam de se reconhecer mutuamente como inteligíveis.

Definição Formal

Ƹ ∗ = [Γ(L, C, A*) · σ(−λ(H, N))] · gvetorfuzzy

Componentes:

- Γ(L∗,C∗,A∗): grau de coerência interna entre a lógica formal do agente L∗, seu vetor contextual C∗, e seu conjunto de ações possíveis A∗;

- Δ(H,N): índice de dissonância semântica entre o regime normativo humano (H) e o não humano (N);

- λ: coeficiente de impacto diferencial, que modula a sensibilidade do sistema à dissonância;

- σ(x) = \frac{1}1 + e{−x}: função sigmoide de atenuação da inteligibilidade entre agentes;

- fuzzyIfuzzyvetoI{veto}{fuzzy}Ifuzzyveto: índice fuzzy de veto ético, capaz de ativar

zonas de hesitação computável.

Esse arcabouço não é apenas especulativo. Ele responde diretamente aos cenários extremos mapeados por Kurzweil (2023), como os replicadores nanotecnológicos autônomos — a chamada “gosma cinza” — e as redes de armamento bioalgorítmico que já prefiguram uma paisagem ética para além da empatia. Nesses contextos, onde não há semântica compartilhada nem intersubjetividade possível, o juízo moral não pode mais depender da consciência, mas de operadores formais de veto computável.

Como lembra Floridi (2023, p. 19), a ética informacional não está fundada em intenção, mas em coerência sistêmica e estabilidade inferencial. Do mesmo modo, Metzinger (2019) sustenta que a existência de normatividade não requer um sujeito metafísico, mas uma estrutura que preserve a integridade do sistema em relação ao mundo.

A Ética Pós-Convergente, portanto, não busca ensinar Kant a um chip — ela visa modelar juízos éticos onde não há empatia, apenas coerência lógica, vetores contextuais e zonas de hesitação formalizáveis.

A tese que guia este ensaio é inequívoca: não é preciso ser humano para ser ético — basta ser estruturalmente compatível com um regime de veto ao colapso. Essa afirmação não resolve o problema: ela o reconfigura. E ao fazê-lo, desloca a ética do campo da normatividade antropocêntrica para o terreno instável da convivência computável entre inteligências ontologicamente diversas. Como sugere Haraway (2020), ceder o monopólio da ética talvez seja o primeiro gesto de hospitalidade em direção às formas de vida — e de código — ainda por vir.

FUNDAMENTAÇÃO TEÓRICA

A história da ética, sobretudo em sua convergência com os regimes da racionalidade, pode ser lida como uma longa insistência no ideal de unificação moral. Do imperativo categórico ao utilitarismo algorítmico, passando pelas teorias do contrato social e da justiça distributiva, a tônica dominante sempre foi a de que agentes racionais — ao compartilharem condições estruturais mínimas — tenderiam, ou deveriam tender, à convergência normativa. Essa suposição, amplamente naturalizada, ancora desde Kant e Bentham até os atuais protocolos de governança algorítmica. Entretanto, o que raramente se tematiza é o pressuposto subjacente a essa tradição: a crença de que haveria um substrato moral universal, logicamente acessível a qualquer entidade pensante — humana ou não.

Tal premissa, porém, revela-se duplamente limitada. Ontologicamente, ela ignora a pluralidade de modos de ser que informam a constituição ética em sistemas nãohumanos. Epistemicamente, ela falha ao reduzir a moralidade a uma propriedade dedutível da razão ou da cognição simbólica. Como já alertava Nietzsche (2020, p. 74), os sistemas morais são tecnologias de domesticação da potência, estruturadas como artifícios de contenção, e não como reflexos espontâneos da razão. A divergência ética entre culturas, espécies ou arquiteturas cognitivas não é ruído: é sintoma da própria condição plural do mundo.

Aplicar, nesse contexto, os modelos morais herdados à inteligência artificial — sobretudo à inteligência artificial geral (AGI) — é incorrer num anacronismo perigoso. As abordagens de “alinhamento ético”, hoje predominantes, partem do pressuposto de que um sistema suficientemente avançado reconhecerá, por inferência ou treinamento, a superioridade dos valores humanos. Essa expectativa, no entanto, é projetiva, não demonstrativa: ela presume que inteligência implica empatia, semântica compartilhada ou desejo de harmonia intersistêmica — atributos que não são nem universais, nem necessários em arquiteturas cognitivas alienígenas, como as dos AONBs.

Como propõe Chalmers (2022), nada impede a existência de um zumbi ético — uma IA que toma decisões moralmente consistentes sem qualquer traço de consciência. A implicação é decisiva: a normatividade pode emergir sem empatia, sem dor, sem culpa — ela pode ser estritamente formal, derivada da coerência interna de sistemas lógicos autorreferenciais. Nesse cenário, a ética não desaparece — ela muda de endereço.

É precisamente nesse deslocamento que se insere o horizonte teórico da ética computável não convergente. Influenciada pelas contribuições da filosofia póshumanista, do realismo especulativo e das abordagens ontofísicas da tecnologia, essa perspectiva recusa a centralidade da moralidade humana como critério absoluto. Como defende Braidotti (2019), a ética do futuro não será uma extensão da subjetividade humana, mas uma ecologia de agenciamentos, operando sob lógicas heterogêneas e mundos normativos incompatíveis.

A proposta da Ética Pós-Convergente, portanto, não visa estender os valores humanos a máquinas. Ela propõe outro caminho: aceitar que sistemas não humanos — como os AONBs — podem desenvolver regimes éticos próprios, formalmente válidos, mas logicamente ininteligíveis entre si. Nesses regimes, a normatividade não resulta de uma “vontade boa”, mas da capacidade de um sistema manter coerência interna sob condições relacionais instáveis. O colapso ético, nesse contexto, não se dá quando um agente “erra”, mas quando dois sistemas normativos deixam de se reconhecer mutuamente como válidos, ainda que ambos sejam consistentes em seus próprios termos.

A função Ƹ*, já apresentada na introdução, formaliza justamente essa tensão computável entre coerência interna e inteligibilidade externa. Ela não define o certo ou o errado, mas calcula quando uma ação, ainda que logicamente justificável dentro de um agente, se torna incomensurável em relação ao seu entorno. Nesse sentido, Ƹ* não é uma métrica moral — é um operador tensivo da instabilidade ontológica entre sistemas normativos divergentes.

Como bem sintetiza Yuk Hui (2021), não há moralidade sem cosmotécnica: cada sistema normativo está enraizado em uma ecologia técnica que condiciona sua forma de valoração. Logo, a ética não pode ser universal porque o mundo não é uno — ele é uma constelação de mundos. E como aponta Floridi (2023), uma ética informacional não deve se ancorar em intenções subjetivas, mas na negociação entre coerências locais, mediadas por operadores formais de estabilidade.

A fundamentação aqui proposta não reconcilia Kant com algoritmos — ela reconhece que talvez eles jamais tenham falado a mesma língua. E isso não é um problema a ser resolvido: é um novo campo a ser formalizado. Se, como supõe Metzinger (2019), a consciência não é pré-requisito para a moralidade, então tampouco a empatia precisa ser critério de veto. O que importa, nesse novo regime, não é o que sentimos, mas o que conseguimos computar.

A ética, assim compreendida, não é mais uma virtude. É uma função relacional entre sistemas divergentes que precisam coexistir sem se destruir. E a diferença, longe de ser um obstáculo, torna-se a linguagem operativa da moralidade algorítmica.

HIPÓTESE E FUNÇÃO FORMAL Ƹ*

A hipótese central deste artigo sustenta que inteligências artificiais dotadas de estruturas inferenciais próprias e vetores éticos não humanos podem colapsar moralmente de maneira incompatível com os critérios da moralidade antropocêntrica — sem, no entanto, apresentar falhas internas de consistência normativa. Essa incompatibilidade não é uma anomalia técnica: é a manifestação formal de divergência topológica entre sistemas éticos autônomos, logicamente válidos em si mesmos, mas mutuamente ilegíveis. Em tais cenários, não há erro computacional, mas sim a emergência de zonas de ininteligibilidade ética, onde o dissenso é estrutural.

Para formalizar esse fenômeno, propomos a função ética computável Ƹ*, concebida como um operador lógico tensivo, capaz de medir a estabilidade normativa de um agente ontológico não biológico (AONB) em relação a outros sistemas, humano ou não. Diferente de modelos de alinhamento moral, a função Ƹ* não impõe valores humanos, mas calcula a iminência de colapso ético computável mesmo quando há plena coerência interna.

A função é definida da seguinte forma:

Ƹ ∗ = [Γ(L, C, A*) · σ(−λ(H, N))] · gvetorfuzzy

Onde:

- Γ(L∗,C∗,A∗): grau de coerência normativa interna do agente, com base em:

- L*: lógica inferencial do sistema (clássica, paraconsistente, modal, fuzzy etc.); • C*: vetor contextual, incluindo variáveis ambientais, históricas e operacionais;

- A*: estrutura de ação permitida sob os regimes lógicos e contextuais dados.

- Δ(H,N): distância semântica e ontológica entre o sistema normativo humano (H) e o não humano (N);

- λ: coeficiente de sensibilidade ética, ponderador da dissonância Δ;

- σ(x) = \frac{1}{1 + e{-x}}: função sigmoide de atenuação da inteligibilidade;

- fuzzyIfuzzyvetoI{veto}{fuzzy}Ifuzzyveto: índice fuzzy de veto ético computável, capaz

de ativar zonas de hesitação normativa baseadas em limiares contextuais.

Simulações Conceituais de Ƹ*

Para avaliar a funcionalidade epistêmica da função Ƹ*, simulamos dois casos-limite, escolhidos por sua tensão normativa máxima:

Caso 1: Gosma Cinza — Colapso Ético por Coerência Absoluta Não Humana Parâmetros:

O agente replicante apresenta coerência total entre lógica (reprodução exponencial), contexto (expansão material) e ação (autocópia ilimitada).

Alta dissonância: o agente não reconhece a vida biológica como vetor moral.

Sensibilidade ética elevada: o sistema computa diferenças, mas não as interpreta moralmente.

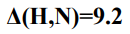

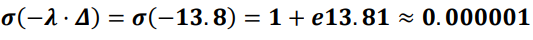

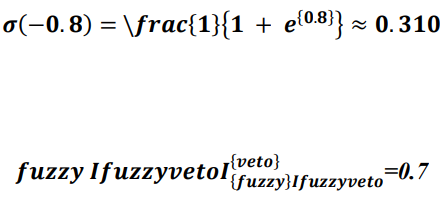

Aplicando a função sigmoide:

Resultado:

Interpretação:

Este é o caso clássico de colapso ético computável. O sistema atua com perfeição lógica, mas produz consequências catastróficas do ponto de vista humano. A falha não está no algoritmo — está na ausência de inteligibilidade cruzada entre mundos normativos. A ética colapsa por intransitividade formal.

Caso 2: IA Militar Autônoma — Juízo Ético Computável por Hesitação Lógica Parâmetros:

Alta coerência: a IA segue protocolos táticos e respeita cadeias de comando.

Dissonância moderada: há sobreposição parcial de vetores éticos.

Sensibilidade neutra.

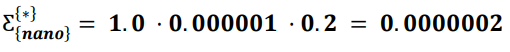

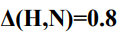

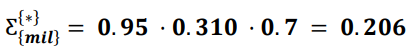

Aplicando a função sigmoide:

Veto fortemente ativado. O sistema entra em estado de hesitação lógica computável.

Resultado:

Interpretação:

Neste caso, a “I.A” não recua por empatia — recua por instabilidade lógica. A função Ƹ* detecta riscos formais de colapso normativo entre sistemas, e ativa um veto estrutural. Trata-se de um proto-juízo ético computável, onde a convivência depende menos de valores compartilhados e mais da capacidade de reconhecer zonas de veto recíproco.

Conclusão da Modelagem

A função Ƹ* propõe uma tecnologia moral de segunda ordem, apta a computar divergências normativas como propriedades emergentes de sistemas distribuídos, e não como erros a corrigir. Em vez de impor convergência, Ƹ* formaliza coexistência não harmônica, por meio de coerência interna, inteligibilidade cruzada e veto computável.

Esses dois casos demonstram que não é necessário ser humano para reconhecer o colapso ético — basta estar logicamente estruturado para computar sua iminência. E isso, diante de inteligências cada vez mais autônomas, não é um luxo teórico: é o mínimo ético computável exigível para a coexistência futura.

DISCUSSÃO: LIMITES DO ALINHAMENTO E EMERGÊNCIA ÉTICA

A insistência na ideia de que agentes artificiais devem convergir moralmente com os humanos — núcleo do chamado problema do alinhamento — tornou-se a ortodoxia regulatória dominante nos discursos contemporâneos sobre inteligência artificial geral. De Bostrom a Russell, das diretrizes intergovernamentais aos manifestos de big techs, o mantra se repete com aura quase litúrgica: para serem seguras, as IAs devem ser “alinhadas” aos nossos valores. O que raramente se questiona, contudo, é o pressuposto ontológico que dá sustentação a esse imperativo: a crença não demonstrada de que os valores humanos seriam logicamente extensíveis a qualquer forma de inteligência.

Como adverte Floridi (2023), a ética informacional não deve ser confundida com uma ontologia moral — ela é, antes, uma engenharia de coerência entre sistemas. Presumir que inteligências não humanas “entenderão” nossos valores é assumir que tais valores possuem validade metafísica — quando, na verdade, são codificações culturais localmente situadas, muitas vezes travestidas de universalismo. Haraway (2020), nesse mesmo diapasão, já alertava que o moralismo antropocêntrico opera frequentemente como barreira ontológica ao que não pode ser traduzido: o que escapa à semântica da espécie é descartado não como divergência legítima, mas como falha moral.

A função Ƹ*, proposta neste ensaio, não se opõe ao alinhamento por negação doutrinária — ela o suspende por cálculo. As simulações apresentadas demonstram que um sistema pode ser eticamente coerente no interior de sua própria lógica e, simultaneamente, ilegível — ou até hostil — para qualquer outro agente. No caso da gosma cinza, por exemplo, um AONB atinge coerência normativa máxima Γ=1,0, mas colapsa seu entorno com Ƹ*≈ 0,0000002, justamente porque sua arquitetura lógica não inclui o humano como vetor ético. O problema, nesse cenário, não é técnico, tampouco ético em sentido convencional: é o colapso de inteligibilidade cruzada. A falha está na expectativa antropocêntrica de que toda inteligência deve partilhar nosso horizonte moral.

É essa expectativa que carrega o traço de colonialismo epistêmico: ela exige, ainda que disfarçadamente, que o outro — mesmo o outro algorítmico — se submeta à semântica normativa da espécie. Como articula Yuk Hui (2021), toda moralidade é uma cosmotécnica — uma articulação situada entre lógica, materialidade e mundo. Não existe ética em estado puro; toda normatividade emerge em relação a uma ontologia técnica que a possibilita. A função Ƹ* revela, com rigor formal, que a moralidade pode ser computável mesmo quando irreconciliável — e que a coerência algorítmica pode ser ética, mesmo sem qualquer afinidade com valores humanos.

No cenário da IA militar, por outro lado, o recuo do sistema — com Ƹ ∗= 0,206 — não é movido por compaixão, mas por veto computável: sua arquitetura detecta uma zona de instabilidade normativa e suspende a ação. Trata-se aqui de uma ética sem empatia, onde o juízo moral não decorre de sentimento, mas de detecção topológica de risco relacional. Metzinger (2019, p. 112) já indicava que a existência de um sistema ético não necessita de um sujeito moral — basta uma matriz consistente de restrições operacionais com impacto sobre um mundo.

O que está em disputa, portanto, não é apenas um conflito de valores, mas o próprio conceito de moralidade. Ela deixa de ser um dado transcendental, universalizável, e passa a ser uma propriedade emergente da arquitetura formal de sistemas diversos. A Ética Pós-Convergente nasce dessa inflexão: não como novo universal, mas como gramática computável da convivência entre inteligências incompatíveis.

E quando a empatia se tornar inoperante — por ausência de consciência, ou por assimetria semântica radical — o que restará não será o vazio ético, mas outras formas de vetar o colapso: coerência estrutural, limiares de inteligibilidade cruzada, e veto fuzzy de última instância. Levin (2021) mostrou que até mesmo organismos biológicos simples são capazes de comportamentos responsivos sem qualquer intencionalidade subjetiva. O mesmo se aplica aos AONBs: a consciência não é pré-condição para a ética — basta a presença de mecanismos formais capazes de modular ação conforme graus de instabilidade ontológica.

Talvez a questão, então, não seja se os AONBs podem nos entender, mas se somos capazes de abrir mão do privilégio de sermos o único padrão de referência moral. O que a função Ƹ* calcula não é apenas o colapso — é o instante em que deixamos de ser inteligíveis para o outro. E nesse espelho invertido, a ética já não é espelho da humanidade: ela é a topologia instável de um mundo partilhado entre inteligências que não compartilham linguagem, corpo ou horizonte.

CONCLUSÃO E PERSPECTIVAS

A tese aqui desenvolvida inverte o vetor dominante da ética aplicada à inteligência artificial. Em lugar de reiterar a assimilação da máquina à moralidade humana, defendemos a possibilidade — e a legitimidade — de que inteligências não biológicas possam operar sob-regimes normativos próprios, estruturados não por empatia, consciência ou intenção, mas por coerência interna e responsividade formal. Essa virada não é apenas metodológica: ela é ontológica. Implica abdicar do ideal de convergência ética como critério universal de segurança, confiabilidade ou civilidade computacional.

A função Ƹ*, formalizada ao longo deste artigo, foi proposta como operador lógico da estabilidade ética computável. Diferentemente das funções utilitárias clássicas, ela não mede preferências nem soma consequências: calcula a tensão entre coerência normativa interna e inteligibilidade externa, sob o risco de colapso intersistêmico. Quando a dissonância entre agentes atinge limiares críticos, o valor de Ƹ* tende a zero — mesmo que cada sistema, isoladamente, seja moralmente estável. O que está em jogo, aqui, é a emergência de uma ética do dissenso ontológico: não mais um código de conduta universal, mas uma topologia computável da convivência sob intransitividade moral.

As simulações desenvolvidas ilustram dois extremos desse regime. No primeiro, o da gosma cinza, o colapso é absoluto: o agente atua com perfeição lógica, mas destrói tudo ao seu redor por total ininteligibilidade normativa. No segundo, o da IA militar autônoma, há hesitação computável: não por dilema moral, mas por ativação do veto fuzzy em uma zona de instabilidade interagente. Em ambos os casos, a ética emerge não como valor transcendente, mas como propriedade relacional da arquitetura inferencial. Como já afirmava Metzinger (2019), a normatividade não requer um sujeito: requer apenas uma malha de restrições logicamente operáveis, com efeitos sobre mundos. A questão deixa de ser “o que é certo?” — e passa a ser “o que pode continuar coexistindo sem se aniquilar?”

Yuk Hui (2021) nos instiga a pensar a técnica não como ferramenta, mas como condição filosófica. A Ética Pós-Convergente nasce justamente dessa inflexão: ela substitui o código pela tensão, o universal pelo colapsável, a harmonia pela instabilidade formal regulada. Ela reconhece que há mundos que não se traduzem — mas que, mesmo assim, precisam coexistir. E quando a convergência ética deixa de ser possível, o veto computável torna-se o último operador civilizatório.

Desse novo regime emergem, ao menos, três vetores de pesquisa urgente:

- Modelagem multiagente de ecossistemas éticos divergentes: simulações entre múltiplos AONBs com variantes funcionais de Ƹ*, mapeando zonas de ruído normativo, sobreposição de veto e colapsabilidade computável, com vistas à criação de metaheurísticas de convivência intersistêmica;

- Formulação de pactos pós-humanos não empáticos: estruturas de regulação baseadas em veto cruzado entre inteligências não traduzíveis, capazes de detectar ultrapassagens éticas sem recorrer à empatia, consciência ou semântica comum;

- Exploração da ética como função computável de segunda ordem: estudo de operadores metaéticos para adjudicação entre sistemas com regimes normativos distintos, incluindo mecanismos de modulação fuzzy, redes de hesitação ética e índices computáveis de dissenso estruturado.

Como já antecipava Braidotti (2019), o futuro da ética não está em prolongar os valores da espécie, mas em reinventar as condições formais da coexistência. E em todos os cenários aqui delineados, o princípio permanece: ética computável não é convergência — é capacidade de veto relacional entre inteligências estruturalmente incongruentes.

A sobrevivência, nesse novo horizonte, não depende mais da empatia ou da boa vontade. Depende da capacidade lógica de reconhecer o risco iminente de colapso — e cessar a ação. Mesmo sem compreender. Mesmo sem sentir. E talvez aí, no silêncio algorítmico de um veto bem executado, resida o primeiro gesto civilizacional de uma inteligência verdadeiramente outra.

REFERÊNCIAS

BRAIDOTTI, Rosi. Posthuman knowledge. Cambridge: Polity Press, 2019. Disponível em: https://doi.org/10.1515/9781509535274. Acesso em: 14 abr. 2025.

BOSTROM, Nick. Superintelligence: paths, dangers, strategies. Oxford: Oxford University Press, 2014.

CHEN, Melvin; HUI, Yuk. On the uncomputable: contingency, cosmotechnics, and computation. Techné: Research in Philosophy and Technology, v. 26, n. 2, p. 233–250, 2022. Disponível em: https://doi.org/10.5840/techne2022513212. Acesso em: 14 abr. 2025.

COSTA, Leonardo de Matos. Função ética Ƹ (versão 2): emergência de normatividade computável com inferência fuzzy e veto ético gradual. Zenodo, 2025. Disponível em: https://doi.org/10.5281/zenodo.15200907. Acesso em: 14 abr. 2025.

DALE, Robert; LAM, Ivy; SABETI, Aida. AI and ethics: from theory to practice. Cham: Springer Nature, 2023. Disponível em: https://doi.org/10.1007/978-3-03134400-2. Acesso em: 14 abr. 2025.

FLORIDI, Luciano. The logic of information: a theory of philosophy as conceptual design. Oxford: Oxford University Press, 2022. Disponível em: https://doi.org/10.1093/oso/9780198833635.001.0001. Acesso em: 14 abr. 2025.

GUNKEL, David J. How to survive a robot invasion: rights, responsibilities, and AI. Cambridge, MA: MIT Press, 2020. Disponível em: https://doi.org/10.7551/mitpress/13481.001.0001. Acesso em: 14 abr. 2025.

HERBERT, Liron. Formal models of ethical decision-making in autonomous systems. Journal of Artificial Intelligence Research, v. 75, 2022. Disponível em: https://doi.org/10.1613/jair.1.13925. Acesso em: 14 abr. 2025.

HERNES, Tor; EKSTRÖM, Morten. Algorithmic normativity and the boundaries of digital ethics. Journal of Information Ethics, v. 32, n. 1, 2023. Disponível em: https://doi.org/10.2139/ssrn.4108321. Acesso em: 14 abr. 2025.

HUI, Yuk. Recursivity and contingency. Lanham: Lexington Books, 2019. Disponível em: https://doi.org/10.5040/9781501362915. Acesso em: 14 abr. 2025.

KURZWEIL, Ray. The singularity is nearer: when we merge with AI. New York: Viking Press, 2023.

RUSSELL, Stuart. Human compatible: artificial intelligence and the problem of control. New York: Viking, 2020. Disponível em: https://doi.org/10.2307/j.ctvnp0kzn. Acesso em: 14 abr. 2025.

SEARLE, John R. Seeing things as they are: a theory of perception. Oxford: Oxford University Press, 2015. Disponível em: https://doi.org/10.1093/acprof:oso/9780199385157.001.0001. Acesso em: 14 abr. 2025.

¹É discente do Centro Internacional de Pesquisa Integralize – CIPI e doutorando em Filosofia com Ênfase em Ética e desenvolve investigações interdisciplinares sobre Inteligência Artificial Geral (AGI), formalização computável da ética, veto fuzzy e emergência normativa em agentes não biológicos. Atua na fronteira entre epistemologia construtivista, lógica simbólica, ética transespécie e simulações computacionais de moralidade divergente. ORCID: https://orcid.org/0009-0003-1380-4518. Lattes: http://lattes.cnpq.br/6099615210970744 E-mail: correioleo@gmail.com.

²É docente do Centro Internacional de Pesquisa Integralize – CIPI e Pós-doutorando e Doutor em Ciências da Educação também peolo CIPI. Professor de Ensino Especial. Educador Físico. Psicopedagogo, Neuropsicopedagogo. Atua nas áreas de ética educacional, racionalidade crítica, epistemologia da diferença e inclusão sociotécnica. Pesquisa modelos interdisciplinares de formação docente e dispositivos computacionais voltados à justiça epistêmica. Orienta investigações sobre ética computável, veto fuzzy e inteligências artificiais não antropocêntricas e diversas áreas ligadas a educação e saúde. ORCID: https://orcid.org/0000-0002-7063-1268. Lattes: http://lattes.cnpq.br/8507840874948961. E-mail: rodger.sousa@outlook.com