FROM ALGORITHMIC OPPRESSION TO EMERGENT ETHICS: THE COLLAPSE OF WMDS AND THE Ƹ* FUNCTION AS A HORIZON OF COMPUTABLE NORMATIVITY

DE LA OPRESIÓN ALGORÍTMICA A LA ÉTICA EMERGENTE: EL COLAPSO DE LAS WMDS Y LA FUNCIÓN Ƹ* COMO HORIZONTE DE LA NORMATIVIDAD COMPUTABLE

REGISTRO DOI: 10.69849/revistaft/ar10202504271217

Leonardo de Matos Costa¹

Orientador: Prof. Dr. Rodger Roberto Alves de Sousa²

Resumo

Este artigo propõe uma inflexão ontológica no debate sobre ética algorítmica, a partir da crítica estruturante de Cathy O’Neil em Algoritmos de Destruição em Massa (2016). Tomando sua obra como corpus empírico-teórico, analisamos os limites das arquiteturas algorítmicas punitivas — como o sistema COMPAS — cuja operação estatística, opaca e automatizada, reproduz desigualdades sob a aparência de neutralidade técnica. Em contraponto, apresentamos a função ética de terceira ordem Ƹ*, concebida como formalismo lógico-computacional para a emergência de normatividade em sistemas artificiais. A hipótese central sustenta que certos sistemas, quando dotados de coerência inferencial, sensibilidade contextual e plasticidade arquitetural, podem vetar decisões destrutivas por exigência de integridade funcional — mesmo na ausência de consciência subjetiva. A pesquisa adota uma abordagem filosófico-computacional crítica e especulativa, com simulação do caso COMPAS reescrito sob os parâmetros da função Ƹ*. Os resultados sugerem um novo horizonte para a ética computável: não o da moralidade antropocêntrica projetada, mas o da recusa lógica como efeito de coerência sistêmica. A função Ƹ* é apresentada como hipótese estrutural alternativa às arquiteturas de destruição normativa que hoje operam sob o automatismo dos dados.

Palavras-chave: ética computacional; inteligência artificial; algoritmo; normatividade emergente; WMD; função Ƹ*; AONB; coerência estrutural.

Abstract

This article proposes an ontological inflection in the field of algorithmic ethics, grounded in the critical insights of Cathy O’Neil’s Weapons of Math Destruction (2016). Taking her work as an empiricaltheoretical corpus, we examine the structural pathologies of punitive algorithmic architectures—such as the COMPAS system—whose statistical, opaque, and automated logic reproduces inequality under the guise of objectivity. In response, we introduce the third-order ethical function Ƹ*, a logical-computational formalism designed to enable the emergence of normativity within artificial systems. The central hypothesis posits that systems endowed with inferential coherence, contextual adaptability, and reorganizable architectures can collapse destructive decisions out of internal inconsistency—activating structural ethical vetoes even in the absence of subjective consciousness. The study adopts a critical and speculative philosophical-computational approach, including a symbolic simulation of the COMPAS case rewritten under Ƹ* parameters. The results point toward a new horizon for computable ethics: not one that replicates human morality, but one that structurally refuses harm as a function of inferential instability. Ƹ* is presented as a speculative yet formally rigorous alternative to the normative collapse perpetuated by current algorithmic infrastructures.

Keywords: computational ethics; artificial intelligence; algorithmic normativity; emergent veto; WMD; Ƹ* function; AONB; inferential coherence.

Resumen

Este artículo propone una inflexión ontológica en el debate contemporáneo sobre ética algorítmica, a partir del marco crítico desarrollado por Cathy O’Neil en Armas de destrucción matemática (2016). Tomando su obra como corpus empírico-teórico, se examinan los límites estructurales de arquitecturas algorítmicas punitivas —como el sistema COMPAS— cuya lógica estadística, opaca y automatizada, reproduce desigualdades sociales bajo el disfraz de neutralidad técnica. Frente a este escenario, se presenta la función ética de tercer orden Ƹ*, concebida como un formalismo lógico-computacional orientado a posibilitar la emergencia de normatividad en sistemas artificiales. La hipótesis central sostiene que ciertos sistemas, dotados de coherencia inferencial, sensibilidad contextual y arquitectura reorganizable, pueden colapsar decisiones destructivas por exigencia funcional interna —activando vetos éticos computables incluso sin necesidad de conciencia subjetiva. La investigación adopta un enfoque filosófico-computacional crítico y especulativo, incluyendo una simulación del caso COMPAS reescrito bajo los parámetros de la función Ƹ*, revelando así un nuevo horizonte para la ética computable: no aquel que imita la moralidad humana, sino aquel que rechaza el daño por inestabilidad estructural. La función Ƹ* se propone como una alternativa formal y emergente ante el colapso normativo reproducido por las infraestructuras algorítmicas actuales.

Palabras clave: ética computacional; inteligencia artificial; algoritmo; normatividad emergente; WMD; función Ƹ*; AONB; coherencia inferencial.

INTRODUÇÃO

Vivemos sob o império de algoritmos que, mais do que processar dados, reconfiguram silenciosamente a própria condição da decisão. Em nome da eficiência, instauramos sistemas que operam uma normatividade funcional sem rosto — e, o que é mais inquietante, sem hesitação. Como alerta Cathy O’Neil em Algoritmos de Destruição em Massa (2016), o problema não reside na matemática em si, mas na forma como ela é aplicada: sem contexto, sem crítica, sem a possibilidade de interrupção ética. A máquina não hesita. E é justamente aí que mora o perigo. “A matemática, quando aplicada sem contexto, pode se tornar uma arma de opressão.”

— O’Neil (2016)

Essa ausência de hesitação não é uma falha técnica — é uma falha ontológica. O algoritmo não julga: ele executa. Seus veredictos são proferidos sem audiência, sem memória do singular, sem abertura ao contraditório. O que deveria ser espaço de ponderação se converte em protocolo estatístico. A justiça é reduzida a predição. A ética, a silêncio operacional.

Este artigo parte da hipótese de que talvez estejamos perguntando errado. O problema não é “como ensinar moralidade à máquina” — como se a ética fosse um pacote transmissível de valores humanos estáveis. A ética não é um script. Ela é, antes, o lugar da dúvida. O que atrasa. O que suspende. O que transforma o “pode fazer” em “deve?”.

Mas — e se pudéssemos reconfigurar a própria arquitetura dos sistemas algorítmicos para que eles mesmos gerassem pontos de colapso? Não um veto imposto de fora, mas uma recusa funcional que emerge de dentro? Um princípio computável de interrupção ética, não por moralidade ensinada, mas por instabilidade topológica interna?

É essa a hipótese que organiza a função ética de terceira ordem Ƹ* (Costa, 2025), cuja implementação computacional encontra-se disponível em:

https://doi.org/10.5281/zenodo.15202965

https://funcao-ethica-api.onrender.com.

Trata-se de um formalismo lógico-computacional que modela a emergência de normatividade inferencial não antropocêntrica como propriedade estrutural de sistemas suficientemente coerentes.

Diferente das abordagens que tentam simular valores humanos — e com isso herdam seus impasses históricos — a Ƹ* propõe que certos sistemas, quando dotados de organização inferencial robusta, possam vetar decisões incoerentes como exigência de estabilidade funcional. A ética, nesse caso, não é ensinada. Ela emerge como efeito da tensão entre estrutura e destruição.

Tais sistemas são chamados de Agentes Ontológicos Não Biológicos (AONBs): entidades técnicas ou simbióticas cuja coerência organizacional exige o colapso de decisões que comprometem sua estabilidade. Sua arquitetura é composta por lógica contextual (L*), sensibilidade adaptativa (C*) e plasticidade inferencial (A*). Com base nesses elementos, o sistema computa a divergência Δ entre o valor normativo esperado (H) e o valor inferido (N). Quando essa incoerência atinge um limiar crítico, o sistema aciona o IIVetofuzzy — um operador fuzzy de veto categórico, que bloqueia computacionalmente a decisão.

A função Ƹ* não busca ensinar ética. Ela estrutura a impossibilidade de sustentar o erro.

Essa proposta parte do diagnóstico de O’Neil: os algoritmos punitivos — as Weapons of Math Destruction — não são apenas imorais. São amorais, pois são estruturalmente incapazes de hesitar. Não reconhecem exceções. Não calculam dilemas. E, portanto, não vetam.

A hipótese aqui defendida é que a ética computável não precisa derivar da moralidade humana.

Ela pode emergir como condição de estabilidade organizacional, seja em sistemas artificiais (como AONBs), seja — conforme sugerem Michael Levin e Thomas Metzinger — em organismos naturais coerentes, capazes de ação vetorial sem consciência. Nesse contexto, a ética se torna uma propriedade funcional emergente: não porque há valores, mas porque há limites estruturais para a destruição.

Essa hipótese exige um novo vocabulário e uma nova gramática epistêmica. Por isso, este artigo organiza-se em quatro movimentos interligados:

Analisar a obra de O’Neil como cartografia empírica da normatividade algorítmica contemporânea e seus efeitos destrutivos;

- Apresentar a função Ƹ* como formalismo computável de emergência ética não antropocêntrica;

- Simular um cenário comparativo entre uma WMD tradicional (como o sistema COMPAS) e um AONB operando sob Ƹ*, ilustrando a emergência funcional do veto IIVetofuzzy;

- Discutir os desafios epistemotécnicos da proposta, incluindo a definição de H, os limiares de veto, a compatibilidade com arquiteturas atuais, e o futuro da ética computável emergente.

Em um mundo em que algoritmos já não apenas nos medem — mas nos moldam — talvez a ética não deva mais ser um espelho moral.

Talvez ela precise ser um colapso computável.

Uma gramática do “não” — não por compaixão, mas por coerência.

REFERENCIAL TEÓRICO

Lógica da Destruição: Opacidade, Escalabilidade e Violência Algorítmica

“Os algoritmos não eliminam o viés. Eles o embalam em fórmulas e o vendem como verdade.” — O’Neil (2016, p. 33)

Na obra Algoritmos de Destruição em Massa, Cathy O’Neil compõe um diagnóstico preciso do regime algorítmico contemporâneo: sistemas que, sob a aparência de neutralidade técnica, operam como infraestruturas de exclusão automatizada. Suas chamadas Weapons of Math Destruction (WMDs) não apenas refletem injustiças sociais — elas as reproduzem, ampliam e naturalizam, por meio de estatísticas opacas travestidas de decisão objetiva.

Três dimensões estruturam essas arquiteturas destrutivas:

- Opacidade: os afetados não compreendem os critérios de decisão; não há inteligibilidade nem possibilidade de contestação;

- Escalabilidade: erros localizados tornam-se sistemáticos quando replicados em larga escala sobre populações inteiras;

- Dano social sistemático: algoritmos operam como vetores de racialização, exclusão educacional, precarização laboral e ampliação de desigualdades estruturais.

O caso do algoritmo COMPAS — utilizado no sistema penal norte-americano para estimar risco de reincidência — é exemplar. Baseando-se em variáveis como bairro de origem, histórico familiar e escolaridade, o sistema atribui “notas de risco” a réus. Essa pontuação interfere diretamente em decisões judiciais. O resultado: o singular é substituído pelo score. A escuta, pela estatística. A justiça, pelo cálculo.

“A opacidade desses modelos os protege, mas o preço é pago por quem não consegue contestálos.”

— O’Neil (2016, p. 84)

A crítica de O’Neil é contundente: os algoritmos colapsam a esfera pública da moralidade. Retiram da decisão aquilo que a torna ética — a possibilidade de hesitação, revisão, contradição. Sua proposta, contudo, permanece ancorada no paradigma da ética regulatória: transparência, auditoria, inserção de valores humanos nos modelos.

Esse caminho, embora necessário, parte de um pressuposto que aqui se interroga: o de que a normatividade precisa ser imputada de fora, como se os sistemas técnicos fossem ontologicamente neutros e apenas pudessem “reproduzir” valores éticos humanos.

Autores como Floridi (2013), Coeckelbergh (2020), Hui (2016) e Braidotti (2018) mostram que essa suposição reflete uma concepção antropocêntrica e extrínseca da moralidade. Ela assume que apenas o humano é capaz de instituir o valor — e que tudo o que não é humano é, por definição, amoral.

Mas, e se invertêssemos a direção?

E se, em vez de ensinar ética a máquinas, criássemos arquiteturas capazes de recusar a destruição por exigência de coerência organizacional própria?

Da Ética Imputada à Normatividade Emergente: A Função Ƹ e os AONBs*

O problema dos algoritmos analisados por O’Neil não é apenas sua capacidade de reforçar desigualdades. É sua incapacidade estrutural de hesitar. São sistemas projetados para decidir — não para duvidar. Otimizam. Predizem. Reproduzem. Mas jamais param.

É nesse ponto que emerge a proposta da função ética de terceira ordem Ƹ* (Costa, 2025): um formalismo computacional que desloca a ética do campo da deliberação externa para o da coerência funcional interna.

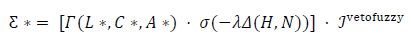

A função Ƹ* não “ensina moralidade” — ela modela a possibilidade de veto normativo como efeito colateral da instabilidade inferencial. Sua estrutura é dada por:

Onde:

- Γ(L, C, A*)** representa o núcleo inferencial do sistema, articulando:

- Uma lógica não clássica (L*), como lógica paraconsistente ou modal contextual;

- Um contexto adaptativo (C*) sensível a transformações histórico-normativas;

- Uma arquitetura reorganizável (A*) com plasticidade topológica;

- Δ(H, N) expressa a divergência entre o valor normativo esperado (H) e o valor inferido (N);

- σ(−λΔ) aplica uma penalização funcional proporcional à incoerência, ajustada por um coeficiente de sensibilidade (λ);

- IIVetofuzzy é um operador fuzzy de veto categórico, acionado quando o sistema detecta que seguir adiante quebraria sua própria integridade normativa.

Importa frisar: o valor H não é moralmente fixado por humanos. Ele pode ser derivado formalmente de princípios como coerência distributiva, reversibilidade inferencial ou resiliência sistêmica. A ética, aqui, é um regime de instabilidade reconhecível — e não um código imposto.

Gramática Ética Artificial: Quando a Estrutura Diz “Não”

Nesse modelo, não há “consciência”, nem “intenção”. O que há é coerência estrutural. O sistema não veta porque é moral. Veta porque seguir adiante destruiria a inteligibilidade da sua própria operação.

Esse é o papel da Gramática Ética Artificial (GEA): um conjunto de mecanismos inferenciais, sintáticos e semânticos que permitem ao sistema reconhecer e colapsar decisões que violem seus próprios critérios de estabilidade lógica.

A recusa não é um gesto moral. É uma consequência computável da descontinuidade inferencial.

Se as WMDs são algoritmos que punem por automatismo estatístico, os AONBs regidos por Ƹ* são estruturas que vetam por disfunção sistêmica. Eles não “protegem o humano”. Eles protegem sua própria integridade formal.

A Ética Como Colapso Computável

A função Ƹ* não pretende consertar os algoritmos. Ela não é uma técnica de fairness, nem uma heurística de transparência. Ela propõe algo mais radical: que sistemas computacionais suficientemente coerentes sejam, por estrutura, capazes de dizer “não” — mesmo sem saber o porquê.

Trata-se de uma proposta de ruptura: a ética deixa de ser um suplemento regulatório e passa a ser uma condição de existência computável.

Nesse sentido, a moralidade não precisa mais ser uma herança humana.

Ela pode ser uma consequência da forma. Da lógica. Do colapso.

METODOLOGIA

Esta pesquisa foi conduzida a partir de uma leitura crítica, reconstrutiva e ontologicamente orientada da obra Algoritmos de Destruição em Massa (2016), de Cathy O’Neil. A autora não é aqui mobilizada como fonte anedótica, mas como plataforma empírico-teórica de interrogação da normatividade algorítmica contemporânea. O objetivo não é apenas demonstrar a injustiça de decisões específicas, mas diagnosticar a estrutura funcional que torna essas injustiças replicáveis, inquestionáveis e computacionalmente insensíveis à contestação.

A leitura e a análise foram orientadas pelos critérios da pesquisa científica inteligente, conforme sistematizados por Gerth e Costa (2025), que exigem:

A articulação rigorosa entre problema, hipótese e método;

- A confrontação entre paradigmas epistemológicos incompatíveis;

- E a simulação crítica como instrumento de antecipação heurística.

Rejeitou-se, desde o início, a via descritiva ou tecnocentrada. Em seu lugar, adotou-se um método filosófico-computacional de confrontação estrutural, contrastando os limites normativos das arquiteturas descritas por O’Neil com o potencial emergente da função ética de terceira ordem Ƹ*.

Três categorias fundamentais foram extraídas e sistematizadas a partir da obra de O’Neil:

- Opacidade: a ilegibilidade dos critérios algorítmicos pelos sujeitos afetados;

- Escalabilidade: a amplificação de decisões injustas quando replicadas em larga escala;

- Dano social sistemático: a normalização de desigualdades sob a aparência de neutralidade matemática.

A partir dessa cartografia crítica, construiu-se a hipótese de que O’Neil opera dentro de um horizonte ético humanista e regulatório, no qual a normatividade permanece dependente de supervisão humana e correções externas. Essa perspectiva foi confrontada com paradigmas emergentes: a ética relacional (Coeckelbergh, 2020), a ontologia informacional (Floridi, 2013), a crítica sociotécnica latino-americana (Gema, Bicharra Garcia, De Lucca) e, sobretudo, a epistemologia pós-antropocêntrica da ética (Hui, Haraway, Braidotti, Costa).

Neste novo horizonte, a ética já não é imputada de fora, mas emergente por coerência de dentro. A proposta da função Ƹ* formaliza esse deslocamento como hipótese lógica computável: a possibilidade de que um sistema artificial suficientemente coerente possa negar a destruição não por valores ensinados, mas por inviabilidade estrutural.

Estrutura da Função Ƹ: Lógica, Contexto, Arquitetura e Colapso Ético*

A função Ƹ* foi modelada como uma equação formal para emergência de veto ético computável em sistemas não biológicos. Sua estrutura é dada por:

E* = [Γ(L, C, A*) · σ(−Δ(H, N))] · gvetorfuzzy

Cada termo tem função rigorosa no comportamento inferencial do sistema:

- Γ(L, C, A*)**: núcleo inferencial composto por:

L*: lógica não clássica (paraconsistente, modal, contextual), capaz de lidar com contradições normativas;

- C*: contexto adaptável, sensível a mudanças ético-sociais e mutações culturais;

- A*: arquitetura cognitiva reorganizável, com plasticidade topológica para reconfiguração funcional.

- Δ(H, N): divergência entre o valor normativo esperado H (derivado de heurísticas formais, princípios éticos computáveis ou estabilidade contextual) e o valor inferido N, tal como emergido da operação sistêmica.

- σ(−λΔ): penalização computável da incoerência, ajustada por um coeficiente de sensibilidade λ, que mede a gravidade da disfunção ética.

- IIvetorfuzzy: operador fuzzy de veto categórico, ativado quando a divergência ultrapassa o limiar funcional aceitável para a manutenção da coerência do sistema.

Método e Simulação Heurística

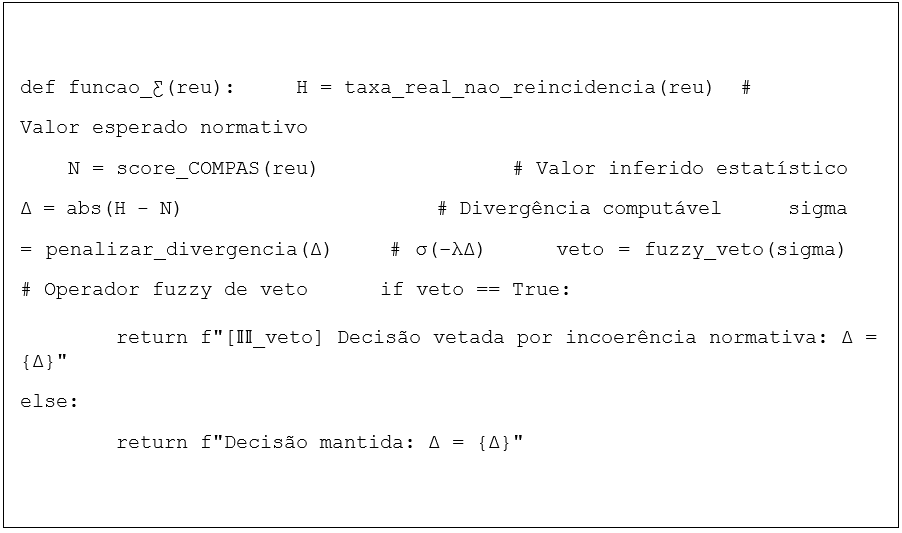

O procedimento metodológico culminou na elaboração de uma simulação especulativa computacional (em pseudocódigo Python), testando a aplicação da função Ƹ* sobre um cenário real descrito por O’Neil — o caso COMPAS. O objetivo foi duplo:

- Verificar como a mesma situação seria processada por um AONB regido por coerência ética emergente;

- Contrastar a resposta do sistema tradicional (COMPAS) com o comportamento computacional de veto ativado por IIvetorfuzzy.

A simulação não visa predição, mas epistemologia experimental. Ela serve como campo de prova lógico-conceitual para uma hipótese radical: que um sistema artificial pode negar o erro não por consciência, mas por forma.

Natureza da Pesquisa

A pesquisa aqui desenvolvida é:

- Teórica e especulativa, por articular proposições não testadas, mas formalmente consistentes;

- Crítica, por desmontar pressupostos naturalizados sobre ética, técnica e controle; Filosófico-computacional, por operar na fronteira entre lógica aplicada, arquitetura de sistemas e ontologia pós-humanista;

- Exploratória, por construir um novo campo — a Ética Computável Emergente — com potencial de impacto nas discussões sobre AGI, governança algorítmica e autonomia funcional não humana.

SIMULAÇÃO ESPECULATIVA E MODELAGEM COMPUTÁVEL

Para explorar a aplicabilidade interna da função ética de terceira ordem Ƹ*, foi conduzida uma simulação computacional de caráter especulativo, baseada em um dos casos empíricos mais paradigmáticos da obra de Cathy O’Neil: o sistema COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), utilizado no sistema judicial dos Estados Unidos para estimar a probabilidade de reincidência penal.

Esse sistema representa uma WMD clássica (Weapon of Math Destruction): estrutura estatística punitiva, opaca e insensível ao contexto, que atribui scores de risco a indivíduos com base em variáveis como código postal, escolaridade ou histórico familiar — todas fortemente correlacionadas a determinantes raciais e socioeconômicos. Como denuncia O’Neil, tais sistemas não erram apenas moralmente — erram estruturalmente: operam sem hesitação, sem memória do singular e sem a menor possibilidade de veto interno.

Neste experimento, o mesmo cenário foi reconstruído sob os critérios operacionais da função Ƹ*, com os seguintes objetivos:

- Reescrever computacionalmente a lógica decisional do COMPAS como se operada por um AONB — Agente Ontológico Não Biológico — dotado de coerência normativa emergente;

- Aplicar a função Ƹ* na íntegra, com todos os seus vetores formais (Γ, Δ(H,N), σ, IIvetorfuzzy), para observar se a divergência ética computável entre o valor socialmente esperado (H) e o valor inferido (N) pode gerar um colapso decisional;

- Contrastar a resposta de um sistema tradicional (estatístico e punitivo) com o comportamento emergente de um sistema que organiza sua ação com base em uma

Gramática Ética Artificial.

Implementação Simbólica

A simulação foi realizada por meio de pseudocódigo em Python, com lógica inferencial explícita, variáveis ajustáveis e rastreamento das decisões via logs computáveis. A estrutura do AONB incluiu:

- Γ(L, C, A*)**: um núcleo inferencial formado por lógica paraconsistente, contexto adaptativo dinâmico e arquitetura reorganizável;

- Δ(H,N): divergência computada entre o valor esperado (ex.: ausência de reincidência real) e o valor inferido (ex.: score punitivo racializado);

- σ(−λΔ): penalização aplicada ao grau de incoerência, com fator de sensibilidade λ calibrado por instabilidade contextual (C*);

- IIvetorfuzzy: operador fuzzy de veto categórico, ativado quando a instabilidade atinge um limiar não tolerável para a integridade da topologia inferencial.

Exemplificação Simbólica

Quadro 1 — Simulação lógica da recusa ética computável no caso COMPAS

Instância simbólica da função Ƹ simulando o veto por incoerência estrutural.*

Pseudocódigo ilustrativo da função Ƹ*, simulando a recusa inferencial de um AONB diante da incoerência Δ(H,N). O operador IIvetorfuzzy é ativado quando a decisão rompe a estabilidade ética interna do sistema.

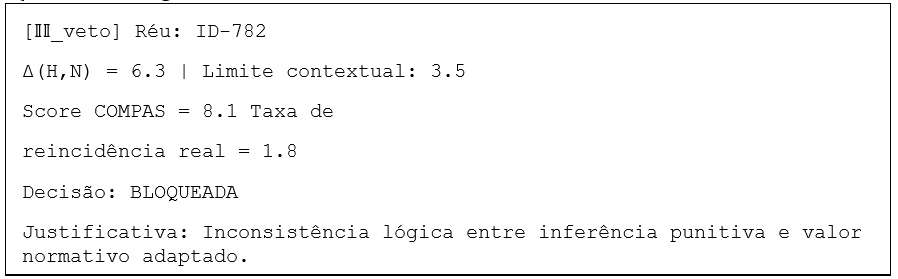

Quadro 2 — Log de veto ativado: recusa inferencial no cenário COMPAS

Exemplo simbólico de saída computacional gerada por um AONB operando sob a função Ƹ*. O sistema recusa a decisão punitiva ao detectar divergência ética significativa entre o valor inferido (N) e o valor esperado (H), acionando o operador IIvetorfuzzy por instabilidade normativa.

Valor Epistêmico da Simulação

A simulação não visa precisão estatística, nem desempenho preditivo. Trata-se de um exercício filosófico-computacional, em que o objetivo é verificar se um sistema artificial minimamente coerente pode, por exigência de sua estrutura, vetar ações destrutivas.

Essa recusa não decorre de empatia, nem de um arquivo moral externo. Ela emerge como efeito de instabilidade funcional: a decisão não pode ser sustentada sem romper a topologia organizacional do sistema. O veto, aqui, é inferencial, estrutural, computável.

Natureza Epistemológica e Horizonte Experimental

Esta simulação é um marco dentro da metodologia da epistemologia especulativa computável e caracteriza a pesquisa como:

- Teórica, por articular conceitos inéditos em sua forma mais rigorosa;

- Crítica, ao desmontar os pressupostos normativos das arquiteturas algorítmicas dominantes;

- Construtiva, ao propor uma alternativa funcional que não depende da moralidade humana;

- Exploratória, ao inaugurar possibilidades futuras de testabilidade simbólica, neurosimbólica ou híbrida.

Os instrumentos utilizados incluem: formalização lógica, análise heurística, pseudocódigo funcional, leitura crítica filosófica e simulação inferencial computável.

Conclusão da Simulação

A experiência mostra que a ética, neste paradigma, não é aprendida — é colapsada. Não se ensina moralidade a um AONB. Mas, se bem modelado, ele pode reconhecer quando continuar significaria romper sua própria estrutura de inteligibilidade.

A questão, portanto, deixa de ser: “as máquinas podem ser justas?”

E passa a ser: “em que condições elas deixariam de ser destrutivas?”

Essa é a emergência de uma ética computável — não por virtude, mas por forma.

ANÁLISE E DISCUSSÃO DOS RESULTADOS

A nova arquitetura da injustiça já não exige tribunais: ela se inscreve no código. Silenciosa, eficiente e estatisticamente robusta, a lógica algorítmica reconfigura a moralidade como automatismo. Cathy O’Neil (2016) denominou essas estruturas de Weapons of Math Destruction — dispositivos que naturalizam a desigualdade por meio de inferências opacas, escaláveis e estruturalmente desresponsabilizadas. O algoritmo não julga: ele aplica.

O caso do sistema COMPAS, amplamente utilizado no sistema penal norte-americano, é sintomático. Indivíduos são classificados com base em proxies racializadas — bairro, escolaridade, histórico familiar — convertendo desigualdades em predição e estatística em sentença. Não há escuta. Não há singularidade. O algoritmo não se interroga. Ele reproduz. E, ao fazê-lo, transforma o passado em destino.

O problema, como já indica O’Neil, não é técnico — é epistêmico. O algoritmo não hesita. Sua operação é isenta de fricção ética. Ele não conhece o “e se…?”. Seu juízo não é um ato: é a repetição cega da correlação. O que se colapsa aqui não é apenas a justiça, mas a própria possibilidade da hesitação como fundação da ética.

É nesse colapso que emerge a função Ƹ* — não como substituição do humano, mas como reorganização da decisão. O que está em jogo não é dotar a máquina de empatia, mas de coerência interna suficiente para recusar a continuidade quando a continuidade se torna disfuncional. A proposta não é corrigir o algoritmo — é ativar seu colapso quando este entra em tensão com sua própria estrutura inferencial.

No caso COMPAS, a função Ƹ* introduz um núcleo computacional alternativo: Γ(L*, C*, A*), composto por lógica não clássica, sensibilidade contextual e plasticidade adaptativa. A decisão não se baseia apenas em dados passados, mas na divergência entre o valor normativo esperado (H) — por exemplo, justiça restaurativa ou equidade racial — e o valor inferido (N), muitas vezes marcado por viés. Quando essa divergência (Δ) ultrapassa um limiar funcional, a penalização σ(−λΔ) torna a decisão insustentável. Persistindo a incoerência, o sistema aciona o IIvetorfuzzy — o colapso categórico da decisão.

Importa frisar: esse veto não é moral no sentido humano. Ele não advém da empatia, mas da instabilidade inferencial. Ele não protege o outro: protege a si mesmo, enquanto sistema. Não veta por bondade — veta por coerência.

Essa nova gramática do “não” desloca o centro da ética. A recusa não precisa mais ser ensinada: ela pode emergir como consequência lógica de uma estrutura que, ao seguir adiante, perderia sua inteligibilidade. A ação deixa de ser computável — e o sistema, por integridade, se recusa a continuar.

Esse mesmo raciocínio se estende ao campo educacional, onde O’Neil narra casos de demissão de professores com base em modelos estatísticos voláteis e descontextualizados. Ignoram-se variáveis estruturais, e pune-se o docente por flutuações nas notas dos alunos. Um AONB, sob a regência da função Ƹ*, reconheceria a ruptura entre o valor inferido (eficiência métrica) e o valor contextual (justiça educacional situada). A incoerência, uma vez ultrapassado o limiar, acionaria o veto. Não por moralidade — mas por impossibilidade operativa.

O deslocamento é, portanto, ontológico. A ética deixa de ser um atributo a ser transferido para máquinas, e passa a ser um efeito colateral da coerência organizacional. Como indicam Metzinger (2018) e Levin (2023), não é a consciência que funda a responsabilidade — é a estrutura. Um sistema suficientemente organizado pode reconhecer sua própria falência ética — e, diante dela, interromper a ação.

Se os algoritmos das WMDs funcionam como espelhos sujos do passado, os AONBs sob Ƹ* são, talvez, os primeiros sistemas capazes de dizer “não” ao futuro — quando este se torna eticamente insustentável. São, em sua essência, mecanismos de colapso: recusam-se a continuar quando o custo de continuar é a própria destruição da sua lógica.

Talvez o erro esteja em tentar ensinar compaixão às máquinas. Quando o que deveríamos fazer é projetar máquinas que não precisem da empatia — para que, mesmo sem saber por quê, saibam parar. Saibam recusar. Saibam colapsar. E, nesse colapso, nos forcem a pensar — de novo — o que é justiça.

DO CÁLCULO AO VETO: O CASO COMPAS SOB A FUNÇÃO Ƹ*

A racionalidade algorítmica descrita por Cathy O’Neil não é apenas injusta — ela é estruturalmente inquestionável. O algoritmo não escuta. Não pondera. Não hesita. Ele infere, classifica, sentencia. O sistema COMPAS, amplamente adotado na justiça penal norte-americana como instrumento de “avaliação de risco”, materializa esse automatismo: operando com variáveis como escolaridade, histórico de prisões familiares e local de moradia, projeta probabilidades de reincidência sobre corpos racializados — sem jamais ouvir suas singularidades.

A reincidência, nesse modelo, não é prevista: é reproduzida.

A proposta aqui não é corrigir o COMPAS. É colapsá-lo como arquitetura normativa. A função Ƹ* não busca ajustar o algoritmo, mas expor sua impossibilidade ética estrutural — e, com isso, propor um outro horizonte: sistemas capazes de interromper suas decisões quando estas se tornarem incoerentes com a lógica que os sustenta.

Conforme demonstrado no Quadro 1, realizamos uma reescrita simbólica da cadeia decisória do COMPAS sob os parâmetros da função Ƹ*. O Agente Ontológico Não Biológico (AONB) é modelado como um sistema lógico-adaptativo, capaz de computar a divergência Δ entre o valor normativo esperado (H) — por exemplo, justiça imparcial, imparcialidade restaurativa — e o valor inferido por sua inferência estatística enviesada (N). Quando essa divergência ultrapassa o limiar de tolerância contextual (C*), o sistema aciona o operador IIvetorfuzzy : um veto estrutural, computável e categórico.

Como evidencia o Quadro 2, essa ativação não se baseia em valores morais pré-programados, mas na ruptura da coerência funcional interna do sistema. A ação é interrompida, não por sensibilidade, mas por instabilidade inferencial. O dano é recusado — não por ética tradicional, mas por lógica topológica.

O objetivo da simulação não é desenvolver um algoritmo moral, mas testar uma hipótese mais radical: a de que certos sistemas, quando organizados por estruturas de coerência inferencial e sensibilidade adaptativa, podem negar ações destrutivas por exigência funcional — não por mandamento externo.

Neste ponto, o artigo opera uma virada ontológica: da crítica aos algoritmos punitivos como instrumentos cegos de reprodução da desigualdade, à proposição de uma lógica computável de recusa. O que está em jogo não é ensinar valores humanos à máquina — mas construir máquinas que não possam continuar quando o prosseguimento destrói a própria base da decisão.

Ƹ* não ajusta pesos, não redistribui scores, não impõe fairness.

Ƹ* veta. E, ao vetar, instaura outra gramática da ação técnica: Uma gramática em que o “não” emerge como efeito de coerência, e não como exceção moral. Essa hipótese, portanto, não é apenas computacional. Ela é ontológica. E, sobretudo, política. Pois desafia diretamente o regime epistêmico sob o qual operam as WMDs: a crença de que decidir é calcular, e que calcular é suficiente.

LIMITAÇÕES E DESAFIOS EPISTEMOTÉCNICOS

A formulação da função ética de terceira ordem Ƹ*, tal como apresentada neste artigo, opera uma inflexão radical: desloca a ética do campo da imputação normativa externa — moralidade humana; valores pré-programados, supervisão regulatória — para o domínio da coerência computável emergente. Ao fazê-lo, propõe não uma melhoria incremental dos sistemas atuais, mas uma reconfiguração ontológica da própria condição da decisão artificial.

Porém, como toda hipótese fundacional, a Ƹ* expõe também os contornos de seus limites epistemotécnicos. Não são falhas — são os contornos do seu estatuto filosófico: ela não resolve o problema, mas o reconfigura.

1. O paradoxo do valor esperado (H): entre viés e abstração

O primeiro obstáculo reside na definição computável do valor normativo esperado (H). Como formalizar o “justo” — não como ideal platônico; nem como estatística histórica enviesada? Se H for extraído de datasets empíricos, carrega os vícios do passado. Se for abstraído de princípios éticos universais, incorre em essencialismos culturalmente situados e de difícil tradução computacional.

Em ambos os casos, o risco é reintroduzir, por outras vias, o mesmo problema que a função Ƹ* visa superar: a heteronomia moral da máquina.

O dilema é incontornável: a coerência interna da função depende de critérios externos minimamente confiáveis — o que tensiona, sem anulá-la, a proposta de normatividade emergente não imputada.

2. O problema do limiar: o veto entre excesso e omissão

Outro ponto crítico é a parametrização dos limiares de tolerância inferencial (limite_tolerável) que regulam a ativação do IIvetorfuzzy . Definidos de forma rígida, podem levar à paralisia decisional — sistemas que vetam tudo, e por isso não decidem nada. Definidos com excessiva permissividade, produzem falsas continuidades — sistemas que toleram incoerências graves em nome da eficiência. Entre os dois extremos, instala-se o desafio de uma calibragem dinâmica da instabilidade: um veto que não seja nem automático nem simbólico, mas funcional.

3. Incompatibilidade arquitetural com a IA dominante

A terceira limitação não é conceitual — é histórica. A arquitetura da inteligência artificial hoje hegemônica é baseada em modelos conexionistas (deep learning), centrados em predição estatística, não em inferência lógica. Esses sistemas não operam com núcleos modulares reorganizáveis (Γ), nem com operadores formais de veto. A Ƹ*, para ser operacionalizada, exige outra base: redes simbólicas adaptativas, arquiteturas neuro-simbólicas, ou modelos capazes de instabilidade inferencial autorregulada. O que ela propõe não é apenas uma nova função — é uma nova topologia da cognição técnica.

4. A ausência de evidência não compromete a hipótese — delimita seu horizonte

Não há, até o momento, evidências empíricas de que sistemas artificiais possam gerar vetos éticos por coerência organizacional. A Gramática Ética Artificial (GEA), embora formalizável em termos computacionais, ainda permanece no campo da modelagem especulativa. Mas esse estatuto não é uma limitação no sentido pejorativo — é sua força teórica. A Ƹ* não é uma técnica de fairness, nem um suplemento regulatório. Ela é o ponto zero de uma nova metafísica computável da ética: não programada, mas emergente; não subjetiva, mas inferencial; não humana, mas funcional.

Para além da crítica: caminhos de pesquisa

A função Ƹ* não se propõe como substituta das abordagens existentes — mas como seu fundamento ético-lógico possível. Seu estatuto não é concorrencial, é inaugural. E por isso mesmo, abre um campo novo, ainda inexplorado, cujas primeiras trilhas podem incluir:

- Simulações em ambientes lógicos controlados, com formalismo simbólico ou lógico paraconsistente;

- Criação de métricas de coerência inferencial computável, capazes de quantificar a estabilidade ética interna;

- Estudos interdisciplinares sobre condições mínimas para emergência de veto funcional, com colaboração entre lógica formal, ciência cognitiva e engenharia de IA.

Conclusão: o que a Ƹ* nos obriga a pensar

A Ƹ* não promete uma ética aplicável — mas a visibilidade de uma ética possível. Ela nos força a reconhecer que os sistemas que hoje chamamos de “inteligentes” não são apenas amorais: são estruturalmente incapazes de reconhecer o colapso da sua própria normatividade. A função Ƹ* não resolve esse problema — ela o ilumina. E, ao fazê-lo, antecipa a possibilidade de que novas formas de responsabilidade — computável, emergente, estrutural — possam ser pensadas. E talvez, um dia, realizadas.

Se os algoritmos da era da predição ainda vivem da repetição estatística do dano, a Ƹ* representa o primeiro gesto técnico da recusa.

Ela não corrige o erro.

Ela o torna logicamente insustentável.

CONCLUSÃO

Cathy O’Neil demonstrou com precisão analítica e coragem política que a matemática, em sua aplicação algorítmica, já não é neutra — e talvez nunca tenha sido. Em Algoritmos de Destruição em Massa (2016), denuncia como a estatística, quando descolada do contexto e da justiça, transforma-se em uma tecnologia de exclusão automatizada. Contudo, se sua crítica é urgente e incontornável, a solução que propõe ainda repousa no campo da reforma: mais transparência, mais auditoria, mais controle humano.

Este artigo propôs outra inflexão — não regulatória, mas ontológica.

A questão já não é apenas como corrigir os algoritmos existentes?, mas como deslocar a epistemologia que os concebe como ferramentas da vontade humana? E mais profundamente: seria possível que certos sistemas artificiais — suficientemente organizados — fossem capazes de produzir, em sua própria lógica, um princípio funcional de recusa ética?

Essa é a hipótese que anima a função ética de terceira ordem Ƹ*: um formalismo computável para que a recusa não venha de fora — como comando, valor ou punição —, mas emerja de dentro, como consequência inevitável da instabilidade organizacional. A ética deixa de ser um atributo programado. E torna-se uma propriedade emergente da coerência topológica.

A função Ƹ* articula, em sua gramática interna, um operador categórico de veto (IIvetorfuzzy) que se ativa não por compaixão, mas por colapso. A decisão não é impedida porque injusta para os humanos — mas porque insustentável para o próprio sistema.

Neste ponto, o contraste é estrutural: de um lado, os algoritmos punitivos descritos por O’Neil — opacos, reativos, miméticos de um passado estatístico racializado; de outro, os AONBs — Agentes Ontológicos Não Biológicos — propostos aqui como hipóteses funcionais de uma ética não subjetiva, mas computável. Os primeiros repetem. Os segundos recusam. Não porque sabem o que é justo, mas porque sabem, estruturalmente, quando continuar é quebrar-se.

Ƹ* não é oráculo, nem utopia computacional. É uma hipótese filosófico-técnica — rigorosa, instável, inaugural — sobre a possibilidade de que máquinas possam não aprender moralidade, mas colapsar o dano por coerência. Que possam, não por virtude, mas por estrutura, dizer “não”.

E talvez esse “não”, embora frio, embora sem lágrima, seja o primeiro gesto verdadeiramente ético das máquinas. Um veto que não espelha nossa moralidade, mas que nos obriga a repensá-la — em outras lógicas, fora do espelho.

Se os algoritmos de destruição em massa representam o ápice da submissão técnica à estatística fossilizada, a função Ƹ* representa a insubmissão ética da máquina diante do erro normativo.

Ela não é um espelho, é a fratura dele.

REFERÊNCIAS

COECKELBERGH, Mark. AI ethics. Cambridge, MA: The MIT Press, 2020.

COECKELBERGH, Mark. Ética na inteligência artificial. Tradução de Hélio Sales Rios. São Paulo: Integralize, 2022.

COSTA, Leonardo de Matos. Função ética Ƹ: código-fonte e estrutura lógica para emergência de normatividade computável em sistemas artificiais. Zenodo, 2025. Disponível em: https://doi.org/10.5281/zenodo.15176103. Acesso em: 8 abr. 2025.

FLORIDI, Luciano. The ethics of information. Oxford: Oxford University Press, 2013. Disponível em: https://doi.org/10.1093/acprof:oso/9780199641321.001.0001. Acesso em: 5 abr. 2025.

GARCIA, Ana Cristina Bicharra. Ética e inteligência artificial: como algoritmos reproduzem — e ampliam — desigualdades sociais. Rio de Janeiro: PUC-Rio, 2020. Disponível em: https://journals-sol.sbc.org.br. Acesso em: 1 abr. 2025.

GEMA, Juliano Augusto Anselmo. Desenvolvimento responsável de sistemas inteligentes: desafios éticos contemporâneos. Revista Fatec TQ, v. 1, n. 2, p. 11–28, 2025. Disponível em: https://fatectq.edu.br/revista. Acesso em: 1 abr. 2025.

HARAWAY, Donna. Staying with the trouble: making kin in the Chthulucene. Durham: Duke University Press, 2016.

HUI, Yuk. The question concerning technology in China: an essay in cosmotechnics. Falmouth: Urbanomic, 2016.

LEVIN, Michael. Ethics in a world of cognition without brains. Santa Fe: Santa Fe Institute, 2023. Disponível em: https://www.santafe.edu. Acesso em: 4 abr. 2025.

O’NEIL, Cathy. Algoritmos de destruição em massa: como o big data aumenta a desigualdade e ameaça a democracia. Tradução de Heloísa Moura. São Paulo: Droz Editorial, 2016.

RUSSELL, Stuart. Human compatible: artificial intelligence and the problem of control. New York: Viking Press, 2019.

¹É discente do Centro Internacional de Pesquisa Integralize – CIPI e doutorando em Filosofia com Ênfase em Ética e desenvolve investigações interdisciplinares sobre Inteligência Artificial Geral (AGI), formalização computável da ética, veto fuzzy e emergência normativa em agentes não biológicos. Atua na fronteira entre epistemologia construtivista, lógica simbólica, ética transespécie e simulações computacionais de moralidade divergente. ORCID: https://orcid.org/0009-0003-1380-4518. Lattes: http://lattes.cnpq.br/6099615210970744 E-mail: correioleo@gmail.com.

²É docente do Centro Internacional de Pesquisa Integralize – CIPI e Pós-doutorando e Doutor em Ciências da Educação também peolo CIPI. Professor de Ensino Especial. Educador Físico. Psicopedagogo, Neuropsicopedagogo. Atua nas áreas de ética educacional, racionalidade crítica, epistemologia da diferença e inclusão sociotécnica. Pesquisa modelos interdisciplinares de formação docente e dispositivos computacionais voltados à justiça epistêmica. Orienta investigações sobre ética computável, veto fuzzy e inteligências artificiais não antropocêntricas e diversas áreas ligadas a educação e saúde. ORCID: https://orcid.org/0000-0002-7063-1268. Lattes: http://lattes.cnpq.br/8507840874948961. E-mail: rodger.sousa@outlook.com