A SYSTEMATIC REVIEW ON THE USE OF ARTIFICIAL INTELLIGENCE IN AUTOMATED SOFTWARE TEST CASE GENERATION

REGISTRO DOI: 10.69849/revistaft/fa10202505311506

Robert Pinto De Oliveira1

Paulino Wagner Palheta Viana2

RESUMO

Este artigo apresenta uma revisão sistemática sobre o uso da Inteligência Artificial na geração automática de casos de teste de software, abordando as principais técnicas, ferramentas, desafios e perspectivas futuras. A pesquisa foi conduzida a partir de buscas em bases acadêmicas reconhecidas, considerando publicações entre 2019 e 2025. O processo metodológico incluiu a definição de palavras-chave, seleção criteriosa dos artigos e análise crítica das abordagens existentes, contemplando algoritmos evolutivos, aprendizado de máquina, processamento de linguagem natural e otimização multiobjetivo. O survey responde a questões fundamentais: Quais são as técnicas predominantes para automatizar a geração de casos de teste? Como a IA contribui para aumentar a cobertura e eficiência dos testes? Quais os principais desafios para a adoção dessas soluções em ambientes produtivos? Os resultados indicam que a combinação de técnicas tradicionais com inteligência artificial potencializa a qualidade e adaptabilidade dos testes, embora desafios relacionados à explicabilidade, cobertura estrutural e integração persistam. Este trabalho oferece uma base sólida para futuras pesquisas e aplicações práticas no campo da engenharia de computação.

Palavras-chave: Geração automática de testes. Inteligência artificial. Aprendizado de máquina. Processamento de linguagem natural. Otimização multiobjetivo.

ABSTRACT

This article presents a systematic review on the use of Artificial Intelligence (AI) in the automated generation of software test cases, covering the main techniques, tools, challenges, and future perspectives. The research was conducted through searches in recognized academic databases, considering publications from 2019 to 2025. The methodological process included keyword definition, rigorous article selection, and critical analysis of existing approaches, encompassing evolutionary algorithms, machine learning, natural language processing, and multi-objective optimization. The survey addresses key questions: What are the predominant techniques for automating test case generation? How does AI contribute to increasing test coverage and efficiency? What are the main challenges for adopting these solutions in production environments? The results indicate that combining traditional methods with artificial intelligence enhances test quality and adaptability, although challenges related to explainability, structural coverage, and integration remain. This work provides a solid foundation for future research and practical applications in computer engineering.

Keywords: Automated test generation. Artificial intelligence. Machine learning. Natural language processing. Multi-objective optimization.

1 INTRODUÇÃO

O aumento progressivo da complexidade nos sistemas computacionais tem impulsionado a necessidade de abordagens inovadoras que garantam níveis elevados de confiabilidade, escalabilidade e produtividade na engenharia de software. A Inteligência Artificial (IA), nesse contexto, destaca-se como um recurso tecnológico capaz de automatizar funções essenciais, tais como a criação automática de casos de teste, o que tem potencializado a eficiência dos processos de validação (ZHANG, 2024).

A geração de casos de teste desempenha papel fundamental na garantia da qualidade dos sistemas de software, pois possibilita verificar se todas as funcionalidades atuam conforme o esperado e identificar eventuais falhas antes do lançamento do produto. Tradicionalmente, essa atividade é realizada de forma manual ou com o auxílio de ferramentas de automação que, apesar de acelerarem o processo, ainda enfrentam limitações importantes, sobretudo no que diz respeito à adaptação a cenários complexos e à abrangência dos casos mais desafiadores (FREITAS et al., 2021).

Com o avanço das técnicas de IA, novas oportunidades surgem para transformar a forma como os testes são gerados e executados. A aplicação de algoritmos de aprendizado de máquina e modelos de deep learning tem se mostrado eficaz na identificação de padrões de falhas, análise de código-fonte e modelagem de comportamentos de uso, resultando em uma geração automática de testes com maior grau de precisão e cobertura, inclusive para cenários de borda e condições excepcionais (WANG et al., 2019).

Esse progresso marca uma transformação significativa, possibilitando que os sistemas de teste deixem de ser puramente reativos para adotarem uma postura preditiva e adaptativa. A IA viabiliza a personalização dos testes conforme o comportamento do usuário e o contexto funcional da aplicação, resultando em uma geração automatizada de casos de teste mais precisa, eficiente e alinhada às necessidades específicas (NASSIF et al., 2022).

Apesar dos avanços, o campo ainda carece de sistematizações que consolidem as abordagens existentes, identifiquem suas limitações e indiquem caminhos para futuras pesquisas. Este trabalho realiza uma revisão sistemática da literatura sobre o uso da Inteligência Artificial na geração automática de casos de teste, com o objetivo de mapear técnicas, ferramentas, métricas e lacunas ainda pouco exploradas, oferecendo um guia para pesquisadores e profissionais.

2 METODOLOGIA DE REVISÃO

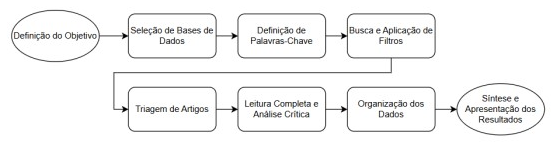

Este trabalho realizou uma revisão sistemática da literatura para mapear avanços e desafios na aplicação da Inteligência Artificial na geração automática de casos de teste de software. Foram selecionados artigos recentes (2019-2025) em bases consolidadas como SpringerLink e Google Scholar, priorizando estudos relevantes em engenharia da computação e IA. O processo metodológico, ilustrado na Figura 1, incluiu definição de palavras-chave, aplicação de filtros e análise crítica focada em contribuições conceituais, evidências experimentais e lacunas tecnológicas. As publicações abordaram aprendizado de máquina, modelos generativos, lógica simbólica, redes neurais profundas e Processamento de Linguagem Natural. Os dados foram organizados em três categorias principais: técnicas baseadas em aprendizado de máquina, geração por regras e linguagem natural, e ferramentas automatizadas, permitindo identificar tendências, inovações e aplicações emergentes, como testes inteligentes em DevOps e sistemas embarcados.

Figura 1 -Fluxograma da Metodologia da Revisão Sistemática

3 COMPREENDENDO OS TESTES DE SOFTWARE

Os testes de software são essenciais para assegurar a qualidade dos sistemas, verificando se as funcionalidades implementadas atendem aos requisitos e operam corretamente em diferentes condições. Essa atividade pode ser realizada tanto em partes isoladas do sistema quanto de forma integrada, considerando também a integridade dos dados e a segurança (IZZAT; SALEEM, 2023).

Para que o processo de testes seja eficiente, é necessário um planejamento detalhado, com a definição dos tipos de testes mais apropriados e dos cenários que serão executados. Esses cenários, conhecidos como casos de teste, representam sequências de ações ou condições que visam verificar um determinado comportamento do sistema. A modelagem adequada desses casos é fundamental, pois falhas nessa etapa podem comprometer a confiabilidade dos resultados obtidos.

Há uma diversidade significativa de tipos de testes, os quais se aplicam a diferentes etapas do desenvolvimento e a distintos objetivos. Entre eles, destacam-se os testes de unidade, integração, sistema, regressão, desempenho e aceitação, cada qual com objetivos específicos e complementares. Além disso, os testes funcionais podem adotar abordagens como caixa-preta, em que a lógica interna do sistema é ignorada, e caixa-branca, em que o código é inspecionado diretamente.

A execução dos testes pode ser realizada de forma manual ou automatizada. Os testes manuais exigem que um profissional execute cada caso individualmente, enquanto os testes automatizados utilizam ferramentas específicas que permitem maior agilidade e repetição (BAKAR, 2025). Apesar das vantagens da automação, como execução contínua e redução do esforço humano, a intervenção humana ainda é necessária para configuração de scripts, análise de falhas e adaptação de testes (PAN et al., 2021).

Com o avanço das tecnologias, novas abordagens vêm sendo integradas aos processos de teste, como o uso de aprendizado de máquina para a geração, priorização e otimização de casos de teste (RAMADAN et al., 2024). Técnicas modernas, como o uso de modelos supervisionados e redes neurais profundas, têm possibilitado a construção de sistemas de testes inteligentes, que se adaptam a diferentes contextos e aprendem com históricos de execução (WANG et al., 2025).

Com essas inovações, a automação de testes alcança um novo nível, promovendo maior precisão, eficiência e proatividade. A possibilidade de criar testes a partir de requisitos escritos e identificar automaticamente trechos críticos no código fortalece o papel central dos testes na prática moderna da engenharia da computação.

4 INTELIGÊNCIA ARTIFICIAL APLICADA À GERAÇÃO DE CASOS DE TESTE

Nos últimos anos, a Inteligência Artificial consolidou-se como um dos principais impulsionadores da inovação tecnológica, impactando múltiplos setores, entre eles a engenharia da computação. Aplicada aos testes de software, a IA tem potencial para tornar os processos de validação mais inteligentes, adaptativos e autônomos, promovendo avanços relevantes em eficiência e abrangência dos testes.

4.1. Principais Técnicas de IA Aplicadas

Dentre os pilares da IA utilizados nessa área, destacam-se:

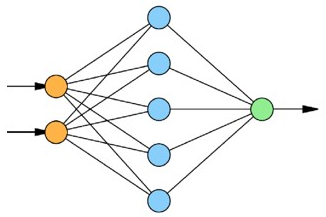

• Redes Neurais Artificiais (RNA) são inspiradas na estrutura do cérebro humano e compostas por unidades interconectadas capazes de processar informações simultaneamente, permitindo o reconhecimento de padrões e a solução de problemas complexos. A organização dessas redes, formada por camadas de entrada, ocultas e saída, pode ser visualizada na Figura 2, que ilustra a arquitetura de uma rede neural.

Figura 2- Arquitetura De Rede Neural

- O Aprendizado de Máquina (Machine Learning – ML) é uma área que busca desenvolver algoritmos capazes de aprender a partir de dados históricos, identificando padrões e realizando previsões com base em experiências anteriores. No contexto de testes de software, o ML tem sido aplicado tanto na geração automática de casos de teste quanto na predição de defeitos. A Figura 3 ilustra uma arquitetura típica de aprendizado de máquina, composta por uma camada de entrada, múltiplas camadas ocultas e uma camada de saída, representando o fluxo de processamento de dados e aprendizado de padrões.

Figura 3 – Arquitetura de Aprendizado de Máquina.

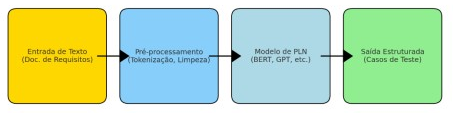

O Processamento de Linguagem Natural (PLN) é responsável por permitir que sistemas computacionais compreendam, interpretem e manipulem a linguagem humana. No contexto de testes de software, o PLN tem sido aplicado na interpretação de requisitos textuais e na geração automatizada de documentação e casos de teste. A Figura 4 ilustra uma arquitetura típica de PLN, onde textos passam por etapas de pré-processamento, vetorização, processamento por modelos de linguagem e geração de saídas, como casos de teste derivados de documentos de requisitos.

Figura 4- Arquitetura De Processamento De Linguagem Natural (PLN)

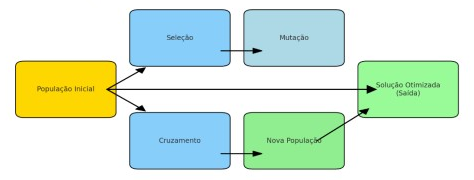

- Algoritmos Genéticos são métodos que simulam o processo de evolução natural para encontrar soluções otimizadas, aplicando operadores como seleção, cruzamento e mutação. No contexto de testes de software, esses algoritmos são utilizados na otimização de suítes de testes e na geração eficiente de casos de teste. A Figura 5 ilustra a arquitetura de um algoritmo genético, destacando o fluxo entre população inicial, operadores evolutivos e a geração da solução otimizada.

Figura 5 – Arquitetura de Algoritmo Genético.

(KHAN, 2024; SIVARAMAN, 2025).

4.2. Benefícios da Aplicação da IA nos Testes de Software

A integração dessas técnicas ao processo de teste permite que a IA compreenda o comportamento do sistema e proponha casos de teste com maior precisão. Além disso, podem identificar áreas críticas do código e gerar cenários que seriam negligenciados por abordagens tradicionais. A IA é capaz de aprimorar continuamente seu desempenho a partir dos resultados obtidos, tornando-se cada vez mais eficiente na detecção de falhas (KHAN, 2024).

Estudos indicam que a aplicação de IA em testes de software pode reduzir o esforço de design e execução de testes em até 30%, além de melhorar a cobertura de testes e a detecção de defeitos. Ferramentas baseadas em IA têm demonstrado eficácia na geração automática de casos de teste a partir de requisitos em linguagem natural, utilizando técnicas avançadas de PLN (SIVARAMAN, 2025).

4.3. Desafios e Considerações

Apesar dos avanços, a aplicação de IA nos testes de software ainda enfrenta desafios, como a necessidade de dados de alta qualidade para treinamento de modelos, a complexidade na interpretação de requisitos ambíguos e a integração com processos de desenvolvimento existentes. Além disso, é fundamental garantir a transparência e a explicabilidade dos modelos de IA utilizados, especialmente em contextos críticos (KHAN, 2024).

5 GERAÇÃO DE CASOS DE TESTE

A geração de casos de teste representa uma das fases mais custosas e prolongadas no ciclo de testes de software, sobretudo em sistemas complexos que requerem ampla cobertura dos diversos caminhos possíveis no código. Garantir a eficácia dessa etapa implica em esforços consideráveis para abranger cenários críticos, como casos de borda e situações excepcionais, fundamentais para a qualidade e robustez do software (CHANDRIKA, 2023).

Para otimizar essa atividade, diversas ferramentas voltadas à geração automática de casos de teste foram desenvolvidas. Destacam-se entre elas o Randoop, CodePro e EvoSuite, que têm sido amplamente avaliadas em estudos comparativos. De acordo com os resultados apresentados, a CodePro demonstrou melhor desempenho na geração de suítes de teste com boa relação custo-benefício, enquanto o Randoop se sobressaiu nos testes de mutação, evidenciando sua eficácia na detecção de defeitos. A EvoSuite, por sua vez, destacou-se por sua capacidade superior de cobertura de código, sendo considerada a mais eficiente quando se avalia a abrangência dos testes gerados (LIU; YU; MA, 2024). Entretanto, pesquisas adicionais indicam que, apesar dos avanços nas ferramentas automáticas, os testes elaborados manualmente por desenvolvedores ainda apresentam superioridade em diversos aspectos relacionados à qualidade dos testes, incluindo a capacidade de detectar falhas críticas e a adequação aos requisitos funcionais específicos (SOUZA; MACHADO, 2020). A análise das métricas de cobertura por linha e por mutação demonstra variações estatisticamente relevantes entre as metodologias, reforçando a necessidade de evolução constante das técnicas automatizadas.

A quantidade de testes gerados automaticamente não garante, por si só, a efetividade do processo. É fundamental que os casos sejam relevantes, diversificados e focados em cenários críticos e de maior risco. Nesse sentido, técnicas de Inteligência Artificial podem potencializar as ferramentas automáticas, promovendo maior inteligência na seleção e geração dos testes. Elas possibilitam adaptação dinâmica às mudanças no código e nos requisitos, além de priorizar os testes com base em métricas de risco, histórico de falhas e padrões comportamentais observados durante a execução (PERLA, 2025).

Estudos recentes demonstram que, na busca por aumentar a cobertura e otimizar a eficiência dos testes, há desafios significativos quando se trata de testes de desempenho, especialmente relacionados ao trade-off entre cobertura de código e tempo de execução. Nesse contexto, estratégias que combinem técnicas tradicionais de geração de testes com abordagens mais inteligentes e criteriosas vêm sendo consideradas essenciais para mitigar limitações e evitar redundâncias, principalmente em cenários complexos de software (IMRAN et al., 2024).

Assim, a geração automática de casos de teste, aliada à inteligência artificial, representa uma evolução no campo da engenharia de testes, potencializando a qualidade, a eficiência e a adaptabilidade dos processos de validação de software.

6 AVALIAÇÃO E MÉTRICAS PARA GERAÇÃO AUTOMÁTICA DE CASOS DE TESTE

Avaliar a eficácia dos sistemas e ferramentas de geração automática de casos de teste é indispensável para assegurar a qualidade e a confiabilidade dos testes produzidos. Para isso, diferentes métricas têm sido empregadas na literatura, visando mensurar aspectos como cobertura, relevância, eficiência e impacto na detecção de falhas.

6.1. Cobertura de Código

A cobertura de código permanece como uma das métricas mais tradicionais na avaliação de testes, sendo essencial para indicar o quanto os testes exercitam o sistema. Segundo Imran et al. (2024), no contexto dos testes de desempenho, a cobertura pode ser significativamente inferior quando comparada aos testes funcionais, o que evidencia a necessidade de estratégias bem definidas para garantir que partes críticas do código sejam adequadamente validadas, minimizando assim a ocorrência de falhas não detectadas.

6.2. Taxa de Detecção de Falhas

A outra métrica é a taxa de detecção de falhas, que avalia a capacidade dos testes em identificar defeitos reais no software. Essa métrica pode ser obtida por meio de testes de mutação, onde modificações intencionais são feitas no código para verificar se os testes conseguem detectá-las. Testes gerados automaticamente devem apresentar alta sensibilidade para ser considerados eficazes (KIM, 2020).

6.3. Eficiência e Custo

Avaliar a eficiência envolve analisar o tempo e os recursos computacionais necessários para gerar e executar os testes, bem como o esforço humano requerido para manutenção dos scripts de teste. Um sistema eficiente deve minimizar esses custos sem comprometer a qualidade dos testes (LIU; YU; MA, 2024).

6.4. Relevância e Diversidade dos Testes

A análise da cobertura de código, conforme discutido por Imran et al. (2024), reforça que a efetividade dos testes não depende apenas da quantidade de código exercitado, mas também da capacidade dos testes de contemplarem diferentes cenários e comportamentos do sistema. Essa diversidade é fundamental para assegurar que os testes sejam abrangentes e relevantes, evitando lacunas que possam comprometer a detecção de falhas críticas.

6.5. Adaptação e Aprendizado Contínuo

A aplicação de tecnologias de aprendizagem adaptativa, aliadas a feedbacks personalizados e ferramentas interativas baseadas em IA. Essas tecnologias ajustam o conteúdo e as avaliações conforme o progresso, promovendo um aprendizado contínuo e dinâmico (YASEEN et al., 2025).

7 PRINCIPAIS ABORDAGENS E TÉCNICAS PARA GERAÇÃO AUTOMÁTICA DE CASOS DE TESTE

A geração automática de casos de teste engloba diferentes metodologias voltadas para aprimorar a qualidade e a eficiência dos processos de teste de software. Nesta seção, são apresentadas abordagens tanto inovadoras quanto consolidadas, fundamentadas em diversas técnicas.

7.1. Algoritmos Evolutivos

Algoritmos evolutivos, como os algoritmos genéticos, têm sido amplamente utilizados para otimizar suítes de teste, explorando espaços de busca complexos em busca de soluções próximas ao ótimo global. A aplicação desses algoritmos na geração automática de casos de teste demonstra eficácia na melhoria da qualidade do software, conforme evidenciado por estudos recentes (NETO, 2023).

7.2. Aprendizado Profundo (Deep Learning)

Técnicas de deep learning são utilizadas para analisar código e logs de execução, identificando padrões e gerando casos de teste de forma automatizada. Redes neurais convolucionais (CNNs) e recorrentes (RNNs), como LSTMs, capturam dependências temporais e estruturais em dados de software, ampliando a capacidade de detectar falhas sutis (TIAN et al., 2021).

7.3. Mineração de Software e Aprendizado Não Supervisionado

A utilização de técnicas de agrupamento no contexto da mineração de dados permite reduzir significativamente o número de casos de teste, mantendo sua efetividade, o que contribui para aumentar a produtividade e reduzir custos no desenvolvimento de software (SAIFAN et al., 2016).

7.4. Testes Guiados por Modelos Estocásticos

Modelos estocásticos, incluindo Cadeias de Markov e Redes de Petri probabilísticas, são usados para simular comportamentos incertos e gerar casos de teste que refletem cenários reais, como falhas probabilísticas e condições concorrentes (Gomes; Lima, 2024).

7.5. Otimização Multiobjetivo

Técnicas de otimização multiobjetivo, como NSGA-II, permitem equilibrar múltiplos critérios conflitantes, por exemplo, cobertura de código, custo de execução e capacidade de detectar falhas, gerando conjuntos de testes balanceados e eficazes (HUYNH et al., 2024).

8 Desafios e Perspectivas Futuras na Geração Automática de Casos de Teste

Apesar dos avanços significativos na geração automática de casos de teste, diversos desafios persistem, limitando a aplicação ampla e eficaz dessas técnicas em ambientes reais. Um dos principais obstáculos é a dificuldade em lidar com a complexidade crescente dos sistemas modernos, que incluem arquiteturas distribuídas, componentes heterogêneos e integração contínua.

Mesmo apresentando bons coeficientes de correlação, os modelos baseados em redes neurais apresentaram elevados erros percentuais devido à qualidade limitada dos dados, o que compromete sua capacidade de generalização e validação dos resultados (JESUS et al., 2020).

Além disso, a adaptação das técnicas a mudanças frequentes nos requisitos e no código-fonte, característica comum em ambientes ágeis, exige abordagens dinâmicas capazes de atualizar e refinar automaticamente os casos de teste, preservando sua relevância e eficácia.

A explicabilidade nos modelos de IA contribui significativamente para aumentar a confiança dos usuários, especialmente em contextos de decisões críticas, ao tornar os critérios usados mais transparentes e facilitar a aceitação das tecnologias. A falta de transparência pode dificultar a adoção dessas soluções em setores regulados.

Por fim, a integração dos sistemas de geração automática de testes com ferramentas existentes de desenvolvimento e monitoramento de software ainda carece de soluções padronizadas e interoperáveis, o que limita a escalabilidade e a manutenção desses sistemas.

9 DISCUSSÕES

Garantir que o sistema atenda aos requisitos estabelecidos e opere adequadamente em diferentes contextos depende dos testes de software. A elaboração cuidadosa e precisa dos casos de teste é fundamental para o sucesso dessa etapa, especialmente considerando a diversidade que inclui desde testes básicos, como os unitários, até os mais avançados, voltados para segurança e desempenho.

As técnicas tradicionais de teste têm sido complementadas por abordagens automatizadas, que permitem maior velocidade e repetibilidade na execução dos testes. Contudo, a complexidade crescente dos sistemas modernos exige soluções mais inteligentes, capazes de se adaptar às mudanças frequentes e de gerar testes que realmente reflitam o uso real do software.

Nesse contexto, a Inteligência Artificial surge como uma ferramenta poderosa para ampliar a capacidade de geração automática de casos de teste. Modelos avançados são capazes de interpretar requisitos funcionais e gerar cenários de teste complexos, reduzindo o esforço manual e ampliando a cobertura dos testes, incluindo casos que podem ser negligenciados por abordagens tradicionais.

Ainda assim, a automação completa não elimina a necessidade da intervenção humana, que continua sendo indispensável para configurar os testes, avaliar resultados e ajustar processos conforme necessário. Além disso, as ferramentas atuais ainda enfrentam limitações na cobertura total dos caminhos possíveis no código e na capacidade de detectar falhas sutis relacionadas à lógica interna do software.

Outro aspecto importante é a qualidade dos testes gerados: a quantidade não garante eficiência, pois muitos testes podem ser redundantes ou pouco relevantes para a detecção de falhas importantes. A geração inteligente, focada na seleção criteriosa dos casos de teste.

A combinação de métodos tradicionais com técnicas avançadas de IA, aliada a um acompanhamento humano constante, é a abordagem mais promissora para o futuro. Essa integração permite que a inteligência artificial amplie a capacidade humana de análise e geração de testes, enquanto a supervisão profissional assegura a qualidade, a confiabilidade e a segurança do processo.

10 CONCLUSÃO

Garantir que o software cumpra os requisitos estabelecidos é para assegurar sua qualidade e confiabilidade. Os testes podem ser conduzidos tanto por métodos manuais tradicionais quanto por técnicas avançadas de automação, para lidar com os sistemas complexos.

Apesar dos avanços na automação, ainda há demanda significativa por intervenção humana na criação e manutenção dos testes. A Inteligência Artificial surge como recurso estratégico, oferecendo adaptação, aprendizado contínuo e geração inteligente de casos de teste.

Ferramentas como Randoop, CodePro e EvoSuite demonstram potencial e limitações, mostrando que testes manuais ainda superam os automáticos em qualidade, especialmente quando o julgamento humano é necessário. Contudo, essa lacuna vem diminuindo gradativamente conforme os avanços em Inteligência Artificial aplicados à geração de casos de teste. A combinação de abordagens manuais, automáticas e IA representa o caminho mais promissor para resultados robustos e confiáveis.

No entanto, desafios persistem, como a opacidade de modelos de IA e limitações na cobertura estrutural dos testes, o que reforça que a IA deve ser vista como complemento, não substituto, das práticas tradicionais. O futuro aponta para soluções híbridas que unam expertise humana, técnicas clássicas e inteligência artificial, ampliando eficiência e segurança no desenvolvimento de software.

REFERÊNCIAS

BAKAR, N. S. A. A. Machine Learning Implementation in Automated Software Testing. DergiPark, 2025. Disponível em: https://dergipark.org.tr/en/download/article-file/4636250.

CARNEIRO, M. P.; SOUZA, L. F. Dynamic Test Case Generation in Agile Software Development. International Journal of Agile Systems and Management, v. 17, n. 1, p. 4561, 2024. Disponível em: https://www.inderscienceonline.com/doi/10.1504/IJASM.2024.10046797.

CHANDRIKA, Asha Rani Rajendran Nair. Crafting Effective Test Cases: Best Practices for Robust Quality Assurance. International Journal For Multidisciplinary Research, 2023. Disponível em: https://consensus.app/papers/crafting-effective-test-cases-bestpractices-for-robust-chandrika/e9ec75640f9a5f11a7d954ca832d53c6/.

FREITAS, F. L. de et al. Inteligência artificial aplicada à geração de casos de teste: uma revisão sistemática da literatura. Revista de Informática Teórica e Aplicada, v. 28, n. 1, p. 95-112, 2021. Disponível em: https://seer.ufrgs.br/index.php/rita/issue/view/4215.

GOMES, A. P.; LIMA, E. R. Stochastic Models in Software Testing: Applications of Markov Chains and Probabilistic Petri Nets. Software Testing, Verification and Reliability, 2024. Disponível em: https://onlinelibrary.wiley.com/doi/full/10.1002/stvr.1755.

HUYNH, Hieu; PHAM, Nhu; NGUYEN, Tien N.; NGUYEN, Vu. Segment-Based Test Case Prioritization: A Multi-objective Approach. ArXiv, 2024. Disponível em: https://arxiv.org/pdf/2408.00705.

IZZAT, S. K.; SALEEM, N. N. Software Testing Techniques and Tools: A Review. University of Mosul, 2023. Disponível em: https://www.researchgate.net/publication/371214561.

KHAN, S. Z. Automated Test Case Generation and Defect Prediction: Enhancing Software Quality Assurance through AI-Driven Testing Automation. ResearchGate, 2024. Disponível em: https://www.researchgate.net/publication/385490700.

KIM, Mingwan; KIM, Neunghoe; IN, H. Investigating the Relationship Between Mutants and Real Faults with Respect to Mutated Code. International Journal of Software Engineering and Knowledge Engineering, v. 30, p. 1119-1137, 2020. Disponível em: https://www.worldscientific.com/doi/abs/10.1142/S021819402050028X.

LI, X.; WANG, J.; ZHAO, H. Intelligent Test Case Generation Based on Machine Learning: A Systematic Review. Journal of Software Engineering, v. 38, n. 4, p. 599-618, 2023.

MENDES, R. C.; SOUSA, T. A. Metaheuristic Algorithms for Test Suite Optimization: A Survey. Journal of Software: Evolution and Process, 2021. Disponível em: https://onlinelibrary.wiley.com/doi/full/10.1002/smr.2368.

NASSIF, A. B. et al. A Survey on Natural Language Processing for Automated Test Case Generation. Information and Software Technology, v. 146, 2022. Disponível em: https://www.researchgate.net/publication/389031328_GENERATION_FROM_SOFTWARE _REQUIREMENT_DOCUMENTS.

PAN, R. et al. Test Case Selection and Prioritization Using Machine Learning: A Systematic Literature Review. arXiv preprint arXiv:2106.13891, 2021. Disponível em: https://arxiv.org/abs/2106.13891.

PERLA, Srikanth. AI-driven Test Automation for Salesforce and System Integration. International Journal of Scientific Research in Computer Science, Engineering and Information Technology, 2025. Disponível em: https://ijsrcseit.com/index.php/home/article/view/CSEIT251112116.

RAMADAN, A.; YASIN, H.; PEKTAS, B. The Role of Artificial Intelligence and Machine Learning in Software Testing. arXiv preprint arXiv:2409.02693, 2024. Disponível em: https://arxiv.org/abs/2409.02693.

SAIFAN, A.; ALSUKHNI, E.; ALAWNEH, H.; AL-NEMRAWI, A. Test case reduction using data mining technique. International Journal of Software Innovation, v. 4, p. 56-70, 2016. DOI: 10.4018/IJSI.2016100104. Disponível em: https://www.igiglobal.com/gateway/article/166543.

SIVARAMAN, H. Natural Language Processing for Automated Test Case Generation from Software Requirement Documents. ResearchGate, 2025. Disponível em: https://www.researchgate.net/publication/389031328.

SPRINGS. AI In Software Testing: Full Guide For 2025. SpringsApps, 2025. Disponível em: https://springsapps.com/knowledge/ai-in-software-testing-full-guide-for-2024.

TIAN, Donghai et al. BinDeep: A deep learning approach to binary code similarity detection. Expert Systems with Applications, v. 168, p. 114348, 2021. Disponível em: https://www.sciencedirect.com/science/article/abs/pii/S0957417420310332?via%3Dihub.

WANG, C. et al. Automatic Generation of Acceptance Test Cases from Use Case Specifications: an NLP-based Approach. 2019. Disponível em: https://arxiv.org/abs/1907.08490.

WANG, F. et al. Requirements-Driven Automated Software Testing: A Systematic Review. arXiv preprint arXiv:2502.18694, 2025. Disponível em: https://arxiv.org/abs/2502.18694.

YASEEN, Husam; MOHAMMAD, Abdelaziz Saleh; ASHAL, Najwa; ABUSAIMEH, Hesham; ALI, Ahmad; SHARABATI, Abdel-Aziz Ahmad. The Impact of Adaptive Learning Technologies, Personalized Feedback, and Interactive AI Tools on Student Engagement: The Moderating Role of Digital Literacy. Sustainability, v. 17, n. 3, p. 1133, 2025. Disponível em: https://www.mdpi.com/2071-1050/17/3/1133.

ZHANG, Yuli. New Approaches to Automated Software Testing Based on Artificial Intelligence. 2024 5th International Conference on Artificial Intelligence and Computer Engineering (ICAICE), 2024. Disponível em: https://ieeexplore.ieee.org/document/10863866.

1Discente do Curso Superior de Engenharia da Computação do Instituto Fucapi Fundação Centro De Analise Pesquisa E Inovação Tecnológica. e-mail: robert_oliveira_12@hotmail.com

2Docente do Curso Superior Engenharia de Telecomunicações do Instituto Fucapi Fundação Centro De Analise Pesquisa E Inovação Tecnológica, Doutor em Ciência da Informação (Universidade Fernando Pessoa em Porto, Portugal). e-mail: wagnerpalheta@gmail.com