REGISTRO DOI: 10.69849/revistaft/cl10202507311126

Luiz Palazzo1

Tarcísio Vanzin2

Resumo:

Este artigo apresenta o modelo QPD-S como uma proposta formal e simbólica para representar a deliberação ética em sistemas autônomos. Fundamentado em princípios filosóficos e estruturais, o modelo articula quatro dimensões essenciais da agência ética — Querer, Poder, Dever e Saber — em uma representação vetorial tridimensional. Essa estrutura geométrica tetraédrica, interpretada como um 3-simplex, possibilita a análise e simulação de decisões morais por meio da avaliação da coerência entre intenções, capacidades, normas e lucidez epistêmica. Adicionalmente, é introduzida a proposta da Ética Mínima de Máquina (EMM), desenvolvida a partir do QPD-S, servindo como base para a certificação e garantia de confiabilidade ética em agentes artificiais. O modelo é explorado em suas vertentes teóricas e formais, com discussões sobre suas aplicações em domínios como mobilidade, assistência virtual e recomendação digital.

Palavras-chave: deliberação ética, inteligência artificial, modelos simbólicos, certificação ética, agência ética delegada.

Abstract:

This paper introduces the QPD-S model as a formal, symbolic framework for representing ethical deliberation in autonomous systems. Grounded in both philosophical and structural principles, the model brings together four essential dimensions of ethical agency—Wanting, Power, Duty, and Knowledge (QPD-S)—in a three-dimensional vector representation. This tetrahedral geometric structure, understood as a 3-simplex, enables the analysis and simulation of moral decisions by assessing the coherence among intentions, capabilities, norms, and epistemic clarity. In addition, the proposal of Minimal Machine Ethics (MME), derived from QPD-S, is presented as a basis for certifying and ensuring the ethical reliability of artificial agents. The model is examined in its theoretical and formal aspects, with discussions of its applications in domains such as mobility, virtual assistance, and digital recommendation.

Keywords: ethical deliberation; artificial intelligence; symbolic models; ethical certification; delegated ethical agency.

1. Introdução

A rápida evolução da tecnologia e da inteligência artificial (IA) nas últimas décadas tem proporcionado avanços sem precedentes à sociedade, prometendo um salto ainda maior com a incorporação da computação quântica. A onipresença da tecnologia a eleva a um papel de ator social, especialmente no que tange aos aspectos cognitivos, onde, em certas dimensões, suas capacidades superam as humanas.

Em uma sociedade hiperconectada e em acelerada transformação impulsionada pela IA, questões éticas complexas emergem, levantando questionamentos críticos sobre os limites de sua atuação (ITS RIO, 2023). Isso é particularmente relevante para a liberdade concedida a sistemas algorítmicos, robótica e machine learning em setores cruciais dentre os quais a saúde, educação, segurança, transporte e, notavelmente, no sensível tema da privacidade.

A literatura recente enfatiza que os riscos éticos da IA não se restringem a falhas técnicas, mas estão intrinsecamente ligados às escolhas de design e a contextos sociopolíticos. O viés algorítmico, por exemplo, pode refletir preconceitos presentes nos dados de treinamento ou nas equipes de desenvolvimento, reforçando desigualdades estruturais (BOULAMWINI, 2018). Casos como sistemas de reconhecimento facial ou algoritmos de crédito que penalizam comunidades marginalizadas evidenciam essa problemática (EUBANKS, 2018). Tais exemplos sublinham a urgência de uma abordagem ética proativa, que antecipe danos em vez de apenas remediá-los.

Diversas abordagens têm sido propostas para infundir ética na IA, desde modelos baseados em regras (como as Leis da Robótica de Asimov) e algoritmos de aprendizado supervisionado com correções morais, até frameworks híbridos que buscam conciliar dados empíricos com princípios normativos. No entanto, muitas dessas estratégias enfrentam três limitações principais: a ausência de uma representação simbólica clara da deliberação ética; a dificuldade de explicar ou justificar decisões morais tomadas por máquinas; e a impossibilidade de verificar a coerência interna das ações propostas por sistemas autônomos.

No contexto da ética na IA, discute-se frequentemente como preservar a agência ética humana no comportamento das máquinas, de forma a mantê-las alinhadas aos valores, autonomia e capacidade de tomar decisões morais significativas. Isso se relaciona diretamente com princípios como transparência, explicabilidade e supervisão humana. Adicionalmente, há, também discussões filosóficas sobre se algum dia sistemas de IA poderiam desenvolver, por suas condições, alguma forma de agência moral própria. Isso, porém, permanece no campo especulativo, alimentando questões profundas sobre consciência, intencionalidade e responsabilidade.

Atualmente, já são aplicados filtros em plataformas de IA para restringir conteúdos considerados impróprios. Esses filtros são desenvolvidos com base em diretrizes e regulamentações de órgãos e iniciativas corporativas criadas para esse fim. Princípios como transparência, justiça, responsabilidade e respeito à autonomia humana são frequentemente citados em documentos como as Diretrizes Éticas para uma IA Confiável da União Europeia (EUROPEAN COMMISSION, 2019) e os Padrões Globais de Ética em Sistemas Autônomos e Inteligentes do IEEE. No entanto, a implementação prática desses princípios enfrenta obstáculos, como a tensão entre inovação acelerada e regulamentação cautelosa, além da falta de consenso global sobre padrões éticos (JOBIN ET AL., 2019).

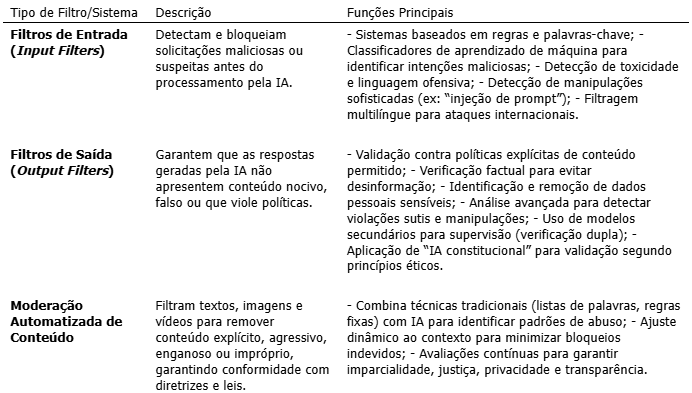

Genericamente, esses filtros consistem em sistemas de moderação e segurança que atuam tanto na entrada (pedidos dos usuários) quanto na saída (respostas geradas pela IA), visando impedir conteúdos impróprios, ilegais, discriminatórios ou que possam causar prejuízos sociais. A Tabela 1 detalha os tipos de filtros e sistemas utilizados:

Tabela 1: Tipos de Filtros e Sistemas de Moderação em IA

Esses mecanismos são cruciais para evitar que a IA atenda a demandas que envolvam linguagem suspeita ou áreas sensíveis, prevenindo a geração de conteúdo que possa causar danos individuais ou sociais. Embora sejam ainda rudimentares e insuficientes, constituem o primeiro passo da ética na IA para garantir segurança, responsabilidade e respeito aos direitos dos usuários. Contudo, considerando o avanço contínuo e o aprimoramento das tecnologias de suporte à IA, e a iminente implementação de processadores quânticos, torna-se imperativa a inserção, nas plataformas de IA, de uma instância ética mais criteriosa, autônoma e filosoficamente consistente, capaz de atuar em adição aos recursos já existentes. Esta é a motivação principal da proposta contida neste artigo.

2. A Ética na Inteligência Artificial

O reconhecimento inicial de que a tecnologia não é neutra, mas moldada por interesses, valores e estruturas de poder, é fundamental buscar todas as formas de proteção, a fim de alcançar um futuro equitativo baseado em um compromisso coletivo com a dignidade humana e a justiça social (UNESCO, 2021).

A Ética, como área da filosofia, dedica-se à problematizar questões relativas aos costumes e à moral de uma sociedade. É, portanto, a filosofia da moral, atuando como um regulador das atitudes e posturas humanas em sociedade. Seu objetivo é estudar os elementos que orientam o comportamento humano, visando estabelecer o que é certo ou errado. Agir eticamente, nesse contexto, implica em articular ações, intenções, capacidades, valores e contextos, aspectos que, mesmo em humanos, não operam de forma simples ou linear. A deliberação ética, em seu sentido mais amplo, transcende a mera obediência a regras ou a maximização de consequências desejáveis. Ela envolve a ponderação de valores reconhecidos como significativos, equilibrando motivações internas, capacidades reais e exigências normativas à luz de uma compreensão situacional.

Tradicionalmente vista como uma faculdade exclusivamente humana, a ética começa a ser considerada uma estrutura funcional necessária em arquiteturas computacionais avançadas (JONAS, 2006). A questão central, portanto, não é apenas se máquinas devem ser éticas, mas como estruturar, representar e avaliar essa ética de modo formalizável, auditável e inteligível. Contudo, a ausência de consciência, intencionalidade ou compreensão moral intrínseca nas máquinas impede que elas se orientem moralmente de forma autônoma.

A IA, ao replicar ou superar capacidades humanas em tarefas cognitivas, desafia noções tradicionais de moralidade. Perguntas como: “Quem é responsável por decisões tomadas por um veículo autônomo em situações de risco?” ou “Como garantir que algoritmos de contratação não perpetuem discriminações históricas?” ilustram a necessidade de estruturas éticas robustas para guiar o desenvolvimento tecnológico sem comprometer valores humanos fundamentais (MITTELSTADT, 2016). Além disso, a escalada da coleta massiva de dados (big data) e a ubiquidade de sistemas de vigilância impõem debates urgentes sobre privacidade e consentimento em um mundo hiperconectado (ZUBOFF, 2019).

Embora a computação quântica venha a amplificar enormemente a capacidade de processamento e a eficiência da IA, ainda não será capaz de oferecer qualquer perspectiva de uma ética própria ou identidade moral. Por isso, a ética humana deve orientar o uso dessa tecnologia para evitar riscos como discriminação, violação de privacidade, concentração de poder e uso malicioso, como ataques cibernéticos sofisticados (BRASIL, 2024; LEE ET AL., 2021). Nesse sentido, a análise ética na IA pode se beneficiar da filosofia kantiana, por sua racionalidade e possibilidade de instrumentalização.

O filósofo Immanuel Kant propôs a teoria ética do dever, ou ética deontológica, na qual uma ação só seria ética se estivesse alinhada com o dever. O foco não está nas consequências das ações, mas nos princípios e regras morais. Este é o ponto de interesse adotado na proposta apresentada neste artigo.

Compreender o papel da ética na IA é reconhecer que a inovação tecnológica deve estar subordinada a valores humanos fundamentais, garantindo que o seu avanço, especialmente com o advento da computação quântica, beneficie a humanidade como um todo. Nesse sentido, a ética implementada na forma de mecanismos autônomos (mas supervisionados) nas plataformas de IA se torna o filtro indispensável para que o poder computacional extraordinário seja usado para o bem, respeitando limites morais e promovendo um futuro sustentável e justo (SULEYMAN; BHASKAR, 2023; JOBIN ET AL., 2019).

3. Agência Ética

Conceitualmente, “agência ética” refere-se à capacidade do ser humano de exercer julgamento moral e assumir responsabilidade por suas ações e escolhas conscientes. Em outras palavras, é a capacidade de agir moralmente, tomando decisões baseadas em princípios e valores éticos. Essa é a capacidade fundamental para a discussão sobre ética na IA, pois uma das grandes questões é justamente “como sistemas artificiais, que não possuem ética intrínseca, podem ser desenvolvidos para respeitar e promover valores éticos humanos?”.

Considerando que a IA possui a intrínseca capacidade de seleção de dados em big data, processamento e tomada de decisão, além da aprendizagem de máquina, configura-se, nesse cenário, uma atuação independente, que implica em comportamentos morais e, por consequência, surge a necessidade de adaptação da agência ética humana à máquina. Na prática, seria conceder à máquina a capacidade de avaliar, mesmo que ainda de forma rudimentar, a ética do trabalho que irá produzir. Esta instrumentalização pode ser denominada “agência ética mínima de máquina”, operando segundo parâmetros programados por humanos. Assim, ao executar ações com impacto no mundo real, a IA age segundo um conceito de “agência ética delegada” ou “agência instrumental”, baseada em princípios humanos pré-estabelecidos e alinhados à uma consistência filosófica mais adequada.

Enquanto a agência ética humana, na apreciação filosófica, é intrínseca e reflexiva, a agência de máquina delegada é instrumental e dependente do design humano. Essa agência ética delegada pode auxiliar na tomada de decisões justas, mas não substitui inteiramente a moralidade humana, apenas a reflete, com todos os seus potenciais erros e acertos.

Para compatibilizar essas duas formas de “agência ética” (humana e de máquina), são necessárias iniciativas de alinhamento de valores ao programar a IA, para que suas ações sejam compatíveis com valores humanos fundamentais, espelhando um certo viés baseado em regras pré-definidas, alinhadas à diretrizes filosóficas. Isso envolve o desafio técnico de traduzir princípios éticos abstratos em parâmetros computacionais. Além disso, é crucial a transparência e explicabilidade para garantir que as decisões da IA sejam compreensíveis para os humanos, permitindo supervisão e intervenção quando necessário. Daí decorre a responsabilidade compartilhada, onde desenvolvedores, implementadores e usuários assumem papéis específicos na garantia do uso ético, bem como dos limites que definem claramente em quais contextos a IA pode agir com maior autonomia e onde a supervisão humana é imprescindível.

Em síntese, para que a IA atue sob critérios éticos, são necessários sistemas de valores codificados que permitam a representação e deliberação ética de forma estruturada. É nesse ponto que o modelo QPD-S se insere como uma proposta inovadora, embora ainda embrionária.

4. O Modelo QPD-S: Estrutura e Deliberação Ética

O modelo QPD-S surge como uma resposta à necessidade de formalizar a deliberação ética em sistemas autônomos, superando as limitações das abordagens existentes. Para tanto, a tríade agostiniana (da relação entre a vontade/arbítrio, inteligência e memória/consciência), juntamente com a ética da estima de Paul Ricoeur (1991) (je veus, je peux et je dois) e a Deontologia kantiana, serviu de base para a adoção da tríade Querer, Poder e Dever, à qual, por via de consequência, conduz a um quarto verbo, o Saber, formando uma representação simbólica e vetorial da agência ética, baseada nessas quatro dimensões fundamentais. Pela inter-relação entre elas, cada uma dessas dimensões é tratada como um vetor em um espaço tridimensional, que forma o tetraédro da figura 1, permitindo assim, e adicionalmente, uma análise geométrica da coerência ética. O número de quatro verbos foi adotado tendo em vista a complexidade inerente a adoção de um número maior de verbos. Por essa razão, a expectativa é que, no futuro, na medida em que o modelo sofra aprimoramentos, esse número venha a ser ampliado.

Figura 1: Representação tetraédrica do Modelo QPD-S

4.1. As Quatro Dimensões da Agência Ética

O QPD-S articula a deliberação ética a partir da interação de quatro vetores, representados pelos quatro verbos, identificados com a racionalidade kantiana:

- Querer (Q): (Wollen)- Representa as intenções, objetivos, desejos e vontade empírica do agente. Em sistemas de IA, isso se traduz nos propósitos programados, nas metas a serem alcançadas e nas preferências que guiam suas ações. É o impulso motivacional da agência. O Quero passa a ser uma simulação derivada de seus parâmetros e dados de treinamento, não de uma vontade genuína. É preciso explicitar que o Sistema “quer” conforme o seu design e não por sua vontade autônoma.

- Poder (P): (Können)- Refere-se às capacidades e limitações técnicas e legais do agente para executar uma ação. Ou seja, trata da liberdade moral, da autonomia e da possibilidade racional de realizar o pretendido. Para a IA, isso envolve os recursos computacionais, os algoritmos disponíveis, os dados acessíveis e as restrições físicas ou operacionais. É a dimensão da exequibilidade.

- Dever (D): (Sollen) Corresponde aos princípios, normas, regras e obrigações éticas que o agente deve seguir. Quer dizer, em sistemas autônomos, isso inclui diretrizes regulatórias, códigos de conduta, valores morais incorporados e padrões de conformidade. É a dimensão da normatividade voltada à justiça, transparência e responsabilidade.

- Saber (S): (Wissen) Engloba o conhecimento, a informação e a compreensão contextual que o agente possui sobre a situação. Saber, para Kant, está ligado à capacidade de aplicar a razão prática. É saber o que se deve fazer – e esse saber é acessível pela razão. Para a IA, isso significa a qualidade e a completude dos dados, a capacidade de interpretar o ambiente e a lucidez epistêmica para avaliar as consequências das ações. É a dimensão da cognição.

4.2. Representação Vetorial e o 3-Simplex: A Geometria da Deliberação Ética

As quatro dimensões do QPD-S (Querer, Poder, Dever, Saber) são integradas em uma representação vetorial tridimensional, onde a deliberação ética é visualizada como um 3-simplex, ou seja, um tetraedro. Cada vértice do tetraedro corresponde a uma das dimensões, e as arestas, faces e o espaço interior representam as complexas relações e tensões entre elas. A Figura 2 ilustra essa representação:

Figura 2: Representação Vetorial do Modelo QPD-S

No contexto desta estrutura, as relações se desdobram da seguinte forma:

- Relações nas Arestas: As interações entre pares de conceitos (e.g., Querer-Poder, Poder-Dever) revelam uma tensão criativa essencial para a estrutura ética. Embora possam apresentar leve discordância (produtos escalares negativos), demonstram complementaridade significativa (produtos vetoriais importantes), com ângulos de 60° entre cada um dos pares e de 70,5° entre uma aresta e a face oposta (para um tetraedro regular) isso sugere que, mesmo em aparente oposição, as dimensões se complementam na construção da decisão ética.

- Relações nas Faces: Cada face do tetraedro (trio de conceitos) representa uma configuração ética distinta, onde a ausência de uma das dimensões revela as limitações de uma abordagem parcial:

- Querer-Poder-Dever (sem Saber): Uma ética intuitiva, mas potencialmente dogmática, carecendo de fundamentação informada.

- Querer-Poder-Saber (sem Dever): Uma ética pragmática, mas potencialmente amoral, desprovida de princípios normativos.

- Querer-Dever-Saber (sem Poder): Uma ética idealista, mas potencialmente ineficaz, sem a capacidade de execução.

- Poder-Dever-Saber (sem Querer): Uma ética institucional, mas potencialmente autoritária, desconsiderando a intencionalidade.

- Espaço Interior: A resultante integrada no interior do tetraedro, um centro de massa conceitual, indica o ponto de máxima intensidade ética, onde os quatro conceitos se integram de forma equilibrada. A análise sugere que uma ética plena requer a integração harmoniosa dos quatro elementos, não como conceitos isolados ou em oposição, mas como dimensões complementares de uma ética completa. Estar inserido no interior do tetraedro, significa que o produto final, resultante do trabalho da IA, está em conformidade com o esperado em termos éticos, podendo ser liberado ao solicitante externo ou indicar a aceitação de uma requisição externa de trabalho à Plataforma IA.

A resultante vetorial dessa configuração indica o grau de coerência da ação. Apenas para fins de compreensão, adota-se o exemplo numérico abaixo onde, a partir de valores imaginários obtidos por critérios definidos, uma decisão em que o agente:

Quer agir com intensidade média (0,6)

Pode realizar a ação com força total (1,0)

Deve agir segundo um princípio claro (0,9)

Saber o suficiente, mas com incertezas (0,4)

A resultante vetorial dessa configuração revelará a coerência da ação, podendo indicar conflitos entre o desejo e a capacidade, ou entre a normatividade e o conhecimento disponível. Essa leitura simbólica e quantitativa é valiosa para compreender decisões, justificar comportamentos e ajustar trajetórias morais ao longo do tempo.

5. Aplicações e Implicações do Modelo QPD-S

O QPD-S foi concebido como um mecanismo simbólico utilizável em ambientes computacionais e situações morais reais com potencial de aplicação em diferentes níveis de complexidade. Algumas aplicações incluem:

- Veículos Autônomos e Dilemas de Emergência: Em uma colisão inevitável, o veículo autônomo pondera a intenção de proteger ocupantes (Querer), os limites físicos (Poder), as normas de trânsito (Dever) e a informação contextual (Saber). A decisão mais coerente não é um simples cálculo de danos, mas uma avaliação da coerência ética máxima possível, tornando as decisões auditáveis e justificáveis. Este cenário exemplifica a necessidade de uma estrutura robusta para a tomada de decisão ética em tempo real, onde a IA deve operar de maneira eticamente informada, considerando a viabilidade prática e as restrições normativas.

- Assistentes Virtuais e Decisões Pessoais: Um assistente de voz que aconselha sobre saúde mental ou finanças equilibra o desejo do usuário (Querer), o que o sistema pode oferecer (Poder), as normas de privacidade (Dever) e a qualidade do diagnóstico (Saber). Se a coerência vetorial for baixa devido a incertezas no Saber, a resposta será mais prudente, buscando mais dados ou encaminhamento humano. Isso demonstra como o QPD-S pode guiar sistemas de IA em interações sensíveis, garantindo que as recomendações sejam não apenas úteis, mas também eticamente alinhadas e transparentes.

- Plataformas de Recomendação e Ambientes Digitais: Sistemas de recomendação podem usar o QPD-S para ponderar o desejo do usuário (Q), a capacidade algorítmica (P), padrões éticos da plataforma (D) e a diversidade/confiabilidade informacional (S). Isso permite construir sistemas mais transparentes e reguláveis, que deliberam em termos de responsabilidade simbólica mínima, e não apenas maximizam cliques. A aplicação do QPD-S aqui visa mitigar vieses algorítmicos e promover recomendações que respeitem valores sociais mais amplos, indo além da otimização puramente comercial.

- Sistemas de Saúde Digital: Em algoritmos de saúde, o QPD-S pode ser aplicado para garantir que as decisões de diagnóstico ou tratamento considerem o bem-estar do paciente (Querer), a capacidade do sistema de processar dados médicos complexos (Poder), as regulamentações de privacidade e segurança de dados (Dever), e a precisão e completude das informações clínicas (Saber). Isso é crucial para construir confiança em sistemas de IA que impactam diretamente a vida humana.

- Métrica para Ética de Máquina: Com o modelo QPD-S a ação ética de máquina pode ser mensurada e prevista, fornecendo assim uma métrica para a pesquisa e desenvolvimento em EM. Isso é de extrema importância para a avaliação de diferentes situações, localizar contornos éticos e antecipar possíveis conflitos. A questão chave aqui reside em como atribuir parâmetros aos vértices do tetraedro ético, uma vez que esses podem ser subjetivos se não houver disciplina em sua seleção.

O modelo QPD-S não exige que sistemas sejam “morais” no sentido humano, mas propõe que sejam estruturados para agir com coerência entre os elementos fundamentais da agência ética. Isso representa um salto importante: da obediência a regras isoladas para a construção simbólica de uma consciência mínima operacional, coerente à ética deontológica kantiana.e

A crescente autonomia dos sistemas tecnológicos, dos quais o modelo QPD-S faz parte, exige que suas ações não apenas obedeçam a comandos, mas que sejam compreensíveis, justificáveis e auditáveis. Isso é especialmente relevante em domínios onde erros ou abusos podem gerar consequências graves, como justiça algorítmica, saúde digital, finanças automatizadas e mobilidade urbana.

6. Ética de Máquina Mínima

O conceito de Ética de Máquina Mínima (EMM) nasce dessa urgência: trata-se de um núcleo simbólico mínimo de deliberação ética, baseado no modelo QPD-S, que pode ser incorporado a qualquer sistema computacional que interaja com decisões moralmente relevantes. Ética mínima não significa ser superficial ou simplista, mas delimitar o conjunto essencial de condições para que uma decisão seja reconhecida como eticamente estruturada, capaz de atuar em uma agência delegada. Em vez de impor valores morais específicos (que variariam culturalmente), a EMM propõe que todo sistema ético confiável seja capaz de:

- Reconhecer intenções (Querer);

- Avaliar capacidades reais (Poder);

- Considerar princípios e normas (Dever);

- Compreender o contexto (Saber).

Esses quatro elementos, integrados de forma vetorial, formam o núcleo da deliberação ética simbolicamente estruturada. O sistema pode, assim, justificar por que tomou determinada decisão, com base nas tensões entre seus vetores, e não apenas nos resultados obtidos.

6.1. Critérios para Certificação Ética

Se adotado como base normativa, o modelo QPD-S permite estabelecer critérios formais de certificação ética de IAs, comparáveis aos já existentes em segurança de software ou ergonomia de interface. Entre esses critérios, destacam-se:

- Representação explícita dos vetores de agência em cada decisão.

- Registro do grau de coerência da ação, com limiares mínimos definidos.

- Mecanismos de compensação ética: se há conflito entre vetores, o sistema deve ativar estratégias de reequilíbrio (por exemplo, buscar mais informação, postergar decisão, consultar módulo externo).

- Rastreabilidade temporal: a evolução dos vetores ao longo do tempo deve poder ser registrada e inspecionada.

Com base nesses princípios, pode-se propor selos de confiança ética, licenciamento de algoritmos e até protocolos de governança algorítmica democrática.

Muitos sistemas de IA hoje são criticados por seu caráter “caixa-preta”, tomando decisões que nem mesmo seus criadores conseguem explicar. O QPD-S, ao operar em termos de vetores explicitamente definidos e configuráveis, oferece explicabilidade simbólica da ação ética com responsabilidade moral. Isso significa que, a qualquer momento, é possível reconstruir a configuração moral da decisão: saber o quanto ela foi motivada por desejo, limitada por capacidade, exigida por deveres ou informada por saberes.

Essa prestação de contas simbólica é o coração da proposta de ética de máquina mínima. Não basta que o sistema “funcione”, ele precisa agir de modo inteligível e revisável, abrindo caminho para uma cultura de responsabilidade moral distribuída entre humanos e sistemas.

7. Considerações Finais: Limites, Potencialidades e o Desafio Ético Compartilhado

O modelo QPD-S e a proposta da Ética de Máquina Mínima (EMM), embora ainda embrionários, foram aqui apresentados como uma tentativa de articular duas exigências contemporâneas urgentes: a de dotar sistemas autônomos de capacidade ética operacional e a de construir ferramentas conceituais que sejam tão rigorosas quanto utilizáveis.

A EMM não pretende oferecer um “módulo moral” pronto para uso, mas sim um núcleo simbólico de deliberação estruturada, a partir do qual decisões podem ser analisadas em termos de coerência entre intenções, possibilidades, deveres e compreensões contextuais.

O modelo apresenta diversas virtudes operacionais e epistemológicas:

- Permite representar deliberações éticas com estrutura simbólica formal;

- Torna possíveis simulações de agência moral em tempo real;

- Oferece explicabilidade interna, essencial para regulação, confiança pública e revisão de decisões;

- Funciona como base para certificações éticas, auditáveis e comparáveis entre sistemas.

Além disso, o QPD-S abre caminho para a criação de comunidades éticas multiagentes, onde diferentes sistemas, cada um com sua própria configuração vetorial, possam negociar, cooperar e evoluir eticamente de modo distribuído. Por outro lado, é necessário reconhecer as limitações da proposta:

- A atribuição de valores aos vetores ainda depende de modelagens contextuais complexas;

- O vetor Saber, embora necessário, é difícil de calibrar, pois envolve qualidades epistemológicas sutis;

- O modelo não resolve por si só os dilemas éticos extremos, mas permite representá-los e analisá-los com maior clareza;

- A universalização da EMM exige mediação cultural e jurídica, pois diferentes sociedades possuem diferentes tradições morais.

Em suma, o QPD-S não substitui a reflexão moral, mas a organiza de modo que sistemas técnicos possam ser incluídos de forma responsável no campo da deliberação ética.

A questão ética não pode ser terceirizada. Mesmo que sistemas autônomos deliberem de maneira cada vez mais complexa, a responsabilidade pelo design, validação e supervisão dessas máquinas permanece humana. É por isso que encerramos este texto com uma pergunta, não como provocação, mas como convocação: Se já somos capazes de estruturar em máquinas uma forma mínima de deliberação moral, estamos preparados para assumir a responsabilidade por aquilo que elas decidem e pelas condições em que as fazemos decidir?

O desafio da ética de máquina, afinal, não é apenas técnico, é também, e talvez antes de tudo, um espelho de nossas próprias escolhas morais.

Referências

AGOSTINHO. A Trindade. Petrópolis: Vozes, 1999.

ANSOMBE, G. E. M. Intention. Oxford: Blackwell, 1957.

BOULAMWINI, J.; GEBRU, T. Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. In: Proceedings of Machine Learning Research, 2018. v. 81.

BRASIL. Sociedade de consumo hiperconectada: inteligência artificial, direitos humanos e o consumo. Brasília: Ministério da Justiça, 2024.

DAMASIO, A. O erro de Descartes: emoção, razão e o cérebro humano. São Paulo: Companhia das Letras, 2005.

EUBANKS, V. Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. St. Martin’s Press, 2018.

EUROPEAN COMMISSION. Ethics Guidelines for Trustworthy AI. 2019. Disponível em: Acesso em: 28 jun. 2025.

FRANKFURT, H. Freedom of the Will and the Concept of a Person. The Journal of Philosophy, v. 68, n. 1, p. 5-20, 1971.

GÄRDENFORS, P. Conceptual Spaces: The Geometry of Thought. Cambridge: MIT Press, 2000.

ITS RIO INSTITUTO DE TECNOLOGIA E SOCIEDADE DO RIO DE JANEIRO. Inteligência artificial e sociedade conectada. Rio de Janeiro: ITS Rio, 2023.

JOBIN, A. et al. The Global Landscape of AI Ethics Guidelines. Nature Machine Intelligence, v. 1, n. 9, 2019.

JONAS, H. O princípio da responsabilidade. Rio de Janeiro: PUC-Rio/Contraponto, 2006.

KANT, I. Fundamentação da Metafísica dos Costumes. São Paulo: Martins Fontes, 2002.

LEE, K.-F.; QIUFAN, C. 2041: como a inteligência artificial vai mudar sua vida nas próximas décadas. São Paulo: Companhia das Letras, 2021.

MITTELSTADT, B. D. et al. The Ethics of Algorithms: Mapping the Debate. Big Data & Society, v. 3, n. 2, 2016.

RICOEUR, P. Soi-même comme un autre. Paris: Seuil, 1991.

SEN, A. Desenvolvimento como Liberdade. São Paulo: Companhia das Letras, 2001.

SPINOZA, B. Ética. Belo Horizonte: Autêntica, 2009.

SULEYMAN, M.; BHASKAR, M. A Próxima Onda: Inteligência artificial, poder e o maior dilema do século XXI. Tradução de Alessandra Bonrruquer. Harper Collins Brasil, 2023.

UNESCO. Recommendation on the Ethics of Artificial Intelligence. UNESCO Publishing, 2021.

ZUBOFF, S. The Age of Surveillance Capitalism. PublicAffairs, 2019.

1Doutor em Ciência da Computação pela UFRGS – PPEGC/UFSC.

2Doutor em Engenharia e Gestão do Conhecimento pela UFSC – PPEGC/UFSC.