EVOLUTION OF DATA TOOLS: FROM EXCEL TO POWER BI AND ARTIFICIAL INTELLIGENCE

REGISTRO DOI: 10.69849/revistaft/ar10202505280928

Lanna Eduarda Pimenta Feitoza¹

Paulino Wagner Palheta Viana²

Resumo

A área de tratamento de dados e Business Intelligence (BI) demonstra uma evolução contínua, caracterizando-se, contudo, por um conhecimento frequentemente disperso. Diante desse cenário, o presente artigo propõe uma síntese abrangente do panorama tecnológico e conceitual que marca essa jornada, iniciando no papel fundamental das planilhas eletrônicas e estendendo-se até a integração da Inteligência Artificial (IA). Exploramos o surgimento e as inerentes limitações de ferramentas como o Microsoft Excel e outras planilhas históricas, contrastando-as com a ascensão do BI e o posicionamento de soluções contemporâneas como o Power BI. Adicionalmente, distinguimos as metodologias de Extração, Transformação e Carga (ETL), examinando as abordagens Clássica e Moderna, com especial atenção ao papel do Power Query. O impacto da IA também é analisado, delineando sua integração nas diversas etapas do ciclo de dados que culminam na tomada de decisão. Dessa forma, este trabalho busca contribuir para a organização e apresentação coesa dessa trajetória evolutiva, salientando a relevância das tecnologias atuais e as projeções futuras influenciadas pela Inteligência Artificial.

Palavras-chave: Excel, Planilhas Eletrônicas, Business Intelligence, Power BI, ETL, ETL Clássica, ETL Moderna, Power Query, Inteligência Artificial, Tratamento de Dados, Tomada de Decisão.

Abstract

The realm of data processing and Business Intelligence (BI) tools and approaches is characterized by continuous evolution, though knowledge often remains fragmented. Accordingly, this article endeavors to synthesize the comprehensive panorama of this technological and conceptual journey, tracing its path from the foundational role of electronic spreadsheets to the sophisticated integration of Artificial Intelligence (AI). We discuss the initial emergence and inherent limitations of tools such as Microsoft Excel and other historical spreadsheets, subsequently exploring the rise of BI and the current positioning of modern solutions like Power BI. The distinction between Classic and Modern Extract, Transform, Load (ETL) approaches is also examined, with particular focus on the capabilities offered by Power Query. Furthermore, the paper analyzes the increasing integration of AI across the various stages of the datato-decision cycle. This effort aims to contribute by organizing and presenting this evolutionary trajectory in a cohesive manner, underscoring the relevance of contemporary technologies and the future perspectives driven by Artificial Intelligence.

Keywords: Excel, Electronic Spreadsheets, Business Intelligence, Power BI, ETL, Classic ETL, Modern ETL, Power Query, Artificial Intelligence, Data Processing, Decision Making.

1. INTRODUÇÃO

A gestão de dados tornou-se uma competência essencial em ambientes corporativos, dado o crescimento exponencial do volume de informações e a complexidade envolvida. Ferramentas tradicionais como planilhas eletrônicas, embora fundamentais, apresentam limitações que motivaram a adoção de soluções mais escaláveis, como plataformas de Business Intelligence (BI). A integração de Inteligência Artificial (IA) nesse ecossistema tem elevado a capacidade analítica e a qualidade das decisões. Este artigo explora essa evolução, destacando ferramentas e abordagens fundamentais como Power BI, Power Query, ETL moderno e recursos de IA.

Além disso, o contexto atual exige decisões cada vez mais orientadas por dados, especialmente em setores como saúde, finanças e logística, onde a precisão analítica pode gerar impacto direto nos resultados operacionais e estratégicos. A transformação digital não apenas acelerou a adoção de ferramentas analíticas, mas também impôs novos desafios em relação à governança de dados, privacidade e ética algorítmica, aspectos que começam a ser integrados nos sistemas mais avançados de análise e visualização.

2. AS FERRAMENTAS PIONEIRAS: PLANILHAS ELETRÔNICAS E SUAS LIMITAÇÕES

Ferramentas como o Microsoft Excel popularizaram a análise de dados ao oferecerem funcionalidades acessíveis para cálculo e visualização. Seu uso democratizou a manipulação de dados em contextos variados, desde tarefas acadêmicas até decisões gerenciais. Contudo, têm dificuldades em lidar com grandes volumes de dados, integração de fontes variadas e manutenção de processos complexos. Estudos apontam para limitações em performance, segurança e colaboração quando comparadas a plataformas especializadas (POWELL; BAKER; LAWSON, 2009).

Com o crescimento da complexidade analítica, tornou-se evidente a inadequação das planilhas para tarefas que exigem consistência, reprodutibilidade e governança de dados. Além disso, a ausência de versionamento robusto, controle de acesso e suporte a modelagens relacionais impõe riscos significativos para a integridade da informação em ambientes corporativos mais exigentes (SCOREPLAN, 2024).

3. A ASCENSÃO DO BUSINESS INTELLIGENCE E O POWER BI

O aumento exponencial de dados em diversos formatos (estruturados, semiestruturados e não estruturados) forçou as empresas a adotarem abordagens estruturadas para processá-los. Nesse contexto, o Business Intelligence consolidou-se como disciplina-chave. Segundo Olszak & Ziemba (2012), BI consiste em processos, arquiteturas e tecnologias que convertem dados brutos em informação e conhecimento de valor para a decisão. Plataformas modernas de BI implementam esse conceito, oferecendo conectividade a múltiplas fontes, ambientes de preparação de dados, bancos de dados analíticos e dashboards interativos.

O Microsoft Power BI destaca-se no cenário de análise de dados por oferecer diversas vantagens em relação às ferramentas tradicionais (como planilhas):

- Conectividade e Integração: Possui conectores nativos para centenas de fontes, permitindo importação de dados automatizada e regular, superando a importação manual de planilhas e unificando sistemas heterogêneos.

- Escalabilidade de Volume: Utiliza o motor VertiPaq para processar e comprimir grandes volumes de dados com performance. Ao contrário do limite do Excel (cerca de 1 milhão de linhas), o Power BI gerencia milhões, garantindo relatórios responsivos em cenários de Big Data, conforme destacado por CCS Learning Academy (2024).

- Modelagem Relacional de Dados: Suporta modelos complexos com múltiplas tabelas relacionadas, permitindo análise cruzada, cálculo de métricas dinâmicas e KPIs precisos, funcionalidades limitadas em planilhas únicas.

- Automação de ETL (via Power Query): Permite extrair, limpar e transformar dados com interface visual (ETL self-service), substituindo operações manuais de planilhas por processos automatizados e reutilizáveis, facilitando a atualização de relatórios.

- Análises Avançadas: Oferece linguagens (como DAX) e ferramentas para criar medidas, cálculos e previsões sofisticadas (estatísticas descritivas, previsão), superando as limitações de fórmulas de planilhas, muitas vezes sem necessidade de codificação.

- Visualização e Dashboards Interativos: Cria dashboards interativos e customizáveis (drill-down, filtros), permitindo explorar dados dinamicamente e facilitando a descoberta de padrões, ao contrário dos gráficos estáticos de planilhas.

- Colaboração e Compartilhamento em Nuvem: O serviço em nuvem permite compartilhamento seguro entre equipes, gerenciando permissões e versionamento, evitando o problema de múltiplas cópias de planilhas.

- Segurança Granular: Oferece segurança em nível de linha (RLS), restringindo acesso a dados específicos por usuário, recurso inexistente em planilhas padrão, garantindo maior conformidade e confidencialidade.

- Funcionalidades Analíticas Avançadas: Inclui recursos nativos como detecção de anomalias, previsões e integração com IA, que demandariam soluções externas ou programação em planilhas.

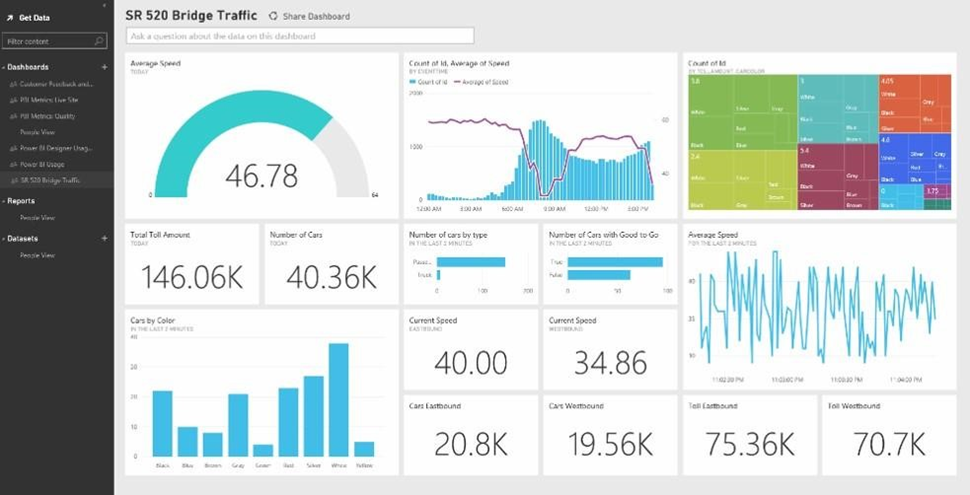

Em resumo, plataformas de BI modernas como o Power BI superam o uso exclusivo de planilhas em conectividade, volume, modelagem, ETL e análises avançadas. Isso as torna indispensáveis para organizações data-driven que buscam transformar dados em insights e decisões estratégicas (Olszak & Ziemba, 2012; Racickas, 2024). Na Figura 1, vemos um exemplo de visualização de dados em um Dashboard do Microsoft Power BI, ilustrando o potencial interativo e visual dessas plataformas.

4. A TRANSFORMAÇÃO DE DADOS: ETL CLÁSSICA E MODERNA

4.1 Definição e Características da Abordagem ETL Clássica

No contexto de BI e Data Warehousing, ETL (Extração, Transformação e Carga) refere-se ao processo tradicional de preparação de dados. Segundo Inmon (2005) e Kimball & Ross (2013), a abordagem clássica de ETL segue sequencialmente três etapas: Extração – coleta de dados de sistemas de origem variados; Transformação – aplicação de regras de negócio para limpar, padronizar, filtrar, agregar e validar os dados; e Carga – inserção dos dados transformados em um repositório central (geralmente um Data Warehouse ou Data Mart) otimizado para consulta analítica. Em geral, esse processo é executado em lotes periódicos (batch), utilizando ferramentas corporativas especializadas (como Informatica, IBM DataStage, Microsoft SSIS, etc.).

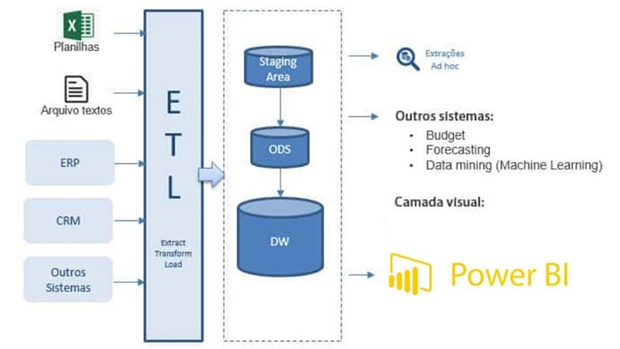

A abordagem clássica costuma ser implementada por equipes de TI dedicadas, seguindo rígido controle centralizado. Ela se mostrou eficaz para processar grandes volumes de dados de forma escalável e consistente. Porém, conforme observado por Santos & Ramos (2006), essa arquitetura tradicional possui desvantagens: é tipicamente cara (licenças de software e infraestrutura), morosa e pouco flexível. Ciclos de desenvolvimento tendem a ser longos, dificultando respostas rápidas a mudanças nos requisitos de negócio. Além disso, a dependência de TI central pode gerar gargalos, reduzindo a agilidade em cenários que exigem self-service. Em suma, o ETL clássico valoriza robustez e governança, mas sofre para acomodar cenários onde a rapidez e a autonomia do usuário de negócio são críticas (Inmon, 2005; Santos & Ramos, 2006). A Figura 2 representa a Arquitetura Clássica de ETL e Data Warehouse, detalhando o fluxo tradicional de dados.

4.2 A Emergência da Abordagem ETL Moderna

Diante das limitações do modelo clássico em face do Big Data e da demanda por agilidade, surgiu o conceito de ETL moderno. Essa evolução privilegia fluxos de dados mais flexíveis, autônomos e orientados ao usuário de negócio. Em vez de ETL puro, muitas arquiteturas atuais adotam o paradigma ELT (Extração, Carga e depois Transformação), no qual dados brutos são primeiro enviados a repositórios de grande capacidade (data lakes em nuvem ou bancos analíticos escaláveis) e então transformados conforme necessário.

As ferramentas modernas de ETL enfatizam:

- Agilidade: Ciclos de preparação e entrega de dados curtos, permitindo ajustes rápidos nos processos.

- Escalabilidade Elástica: Utilização de infraestruturas em nuvem para aumentar ou reduzir recursos conforme a demanda de processamento.

- Self-Service: Interfaces visuais intuitivas (arrastar-e-soltar, configuração declarativa) que permitem aos analistas de negócio criarem pipelines de dados sem apoio direto de TI.

- Variedade de Dados: Suporte nativo a diferentes formatos e estruturas (JSON, XML, logs, imagens, etc.), refletindo a necessidade de incluir dados semiestruturados.

- Automação e Orquestração: Integração com workflows automatizados (pipelines agendados, monitoramento, alertas) para garantir confiabilidade e repetibilidade sem intervenção manual constante.

Em resumo, o ETL moderno reequilibra a centralização do ETL clássico com autonomia do usuário e capacidades de nuvem, buscando maior flexibilidade e velocidade na preparação de dados. Essa abordagem é ilustrada por soluções como Azure Data Factory, AWS Glue, Google Dataflow, além de ferramentas de data plumbing de última geração (Hevo, Talend, Stitch etc.), que suportam nativamente ELT e automação baseada em metadados. Conforme destaca Rivery (2024), esse movimento caracteriza-se pela adoção de DataOps e integração contínua nos processos de dados, rompendo com ciclos longos e estáticos do passado.

4.3 Power Query como Ferramenta de ETL Moderna (Self-Service ETL)

O Power Query, componente de preparação de dados no Power BI e Excel, é um exemplo de ETL self-service moderno. Segundo a documentação da Microsoft (2025), ele funciona como um engine gráfico para conectar, extrair e aplicar transformações interativas (como limpeza, mesclagem e agregação) em dados de diversas fontes, carregando o resultado final (Microsoft, 2025). Essas operações, realizadas sem escrita explícita de código, são traduzidas internamente para a linguagem M (Webb, 2014). O Power Query democratiza o processo de ETL, permitindo que usuários criem consultas visuais repetíveis e atualizáveis. Isso acelera a preparação de dados complexos e reduz a dependência da equipe de TI, alinhando-se aos princípios de BI self-service. Conforme a Microsoft (2025), ele também aborda a necessidade de limpeza de dados (“dados sujos”) com ambientes ricos para filtragem e estruturação, garantindo dados adequados para análise.

4.4 Distinções Técnicas: Power Query no Power BI versus Power Query no Excel

É importante notar que, apesar de usarem o mesmo motor subjacente (e a linguagem M), existem diferenças operacionais entre o Power Query no Power BI Desktop e no Excel (Webb, 2014). Entre elas destacam-se (CCS Learning Academy, 2024):

- Volume de Dados e Performance: O Power BI é integrado ao motor VertiPaq e à infraestrutura do Azure, permitindo processar conjuntos de dados muito maiores com melhor desempenho. Em contrapartida, o Excel está sujeito às limitações de memória e arquitetura do aplicativo desktop. Por exemplo, o Excel trava acima de 1 milhão de linhas, enquanto o Power BI escala sob demanda (CCSLA, 2024).

- Integração no Ecossistema: No Power BI, o Power Query faz parte de uma plataforma de BI completa: consultas podem alimentar dataflows, modelos de dados corporativos e relatórios multiusuário. Esse ecossistema oferece agendamento de atualização, compartilhamento centralizado e governança integrada. No Excel, o Power Query alimenta apenas a própria planilha ou o modelo de dados local (Power Pivot), limitando a colaboração avançada.

- Conectores de Dados: Frequentemente, o Power BI Desktop dispõe de conectores mais recentes ou exclusivos para serviços empresariais (APIs modernas, bancos em nuvem), enquanto o Excel pode ficar defasado, exigindo atualizações de versão para suportar novas fontes.

- Gerenciamento de Modelo: No Power BI, todas as consultas carregadas alimentam um Data Model relacional central, usado por múltiplos relatórios. Já no Excel, cada query normalmente preenche uma tabela ou o modelo local, isolado, com menos recursos de relação entre tabelas.

- Atualizações e Governança: O ciclo de atualização no serviço Power BI (com gateway/nuve) provê governança e monitoramento empresarial, enquanto no Excel isso depende de processos ad hoc (enviar arquivos, logs externos etc.).

Essas distinções fazem com que o Power Query no Power BI seja considerado mais poderoso e escalável para cenários corporativos de BI, enquanto a versão no Excel mantém apelo para análises ad hoc e de escala menor (CCSLA, 2024; Webb, 2014).

5. A INTELIGÊNCIA ARTIFICIAL NO CICLO DE DADOS PARA A DECISÃO

Conforme destacado, o propósito final de qualquer sistema de informação é suportar decisões mais eficazes. Nesse contexto, o ciclo de dados segue tipicamente os estágios: dado bruto → tratamento/transformação (limpeza, integração) → informação estruturada → análise/visualização → conhecimento/insight → decisão estratégica. Esse fluxo contínuo evidencia que cada fase depende da anterior. Como observa Racickas (2024), ao longo desse pipeline “o dado processado informa a tomada de decisão”dbta.com. Ferramentas de BI atuam especialmente nas fases intermediárias (pré-paradoção e análise), mas hoje a inteligência artificial começa a intervir em diferentes etapas do ciclo.

5.1 O Ciclo de Dados: Do Dado Bruto à Decisão

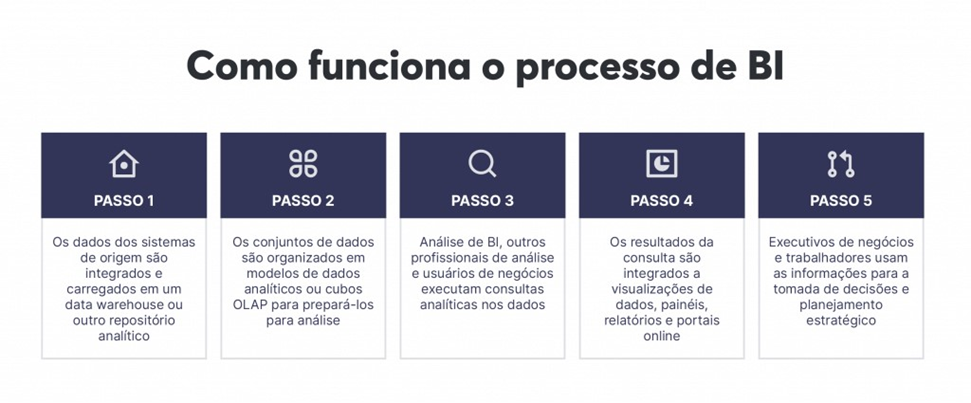

Inicialmente, os dados coletados por sistemas operacionais, sensores ou fontes externas são, em geral, incompletos e ruidosos. A etapa seguinte envolve sua prévia transformação: combinar dados de múltiplas tabelas, preencher lacunas, remover ruídos e estruturar tabelas factíveis de consulta. Essas informações estruturadas então alimentam análises de BI — consultas multidimensionais, mineração de dados e geração de relatórios — que revelam padrões, tendências e métricas de negócio. Por fim, os insights obtidos fornecem base para decisões: seleção de investimentos, ajustes de processos, definições estratégicas etc. Em cada etapa, da ingestão inicial à decisão final, há necessidade de ferramentas apropriadas. Conforme ilustra Racickas (2024), o pipeline de BI tradicional “envolve a coleta, limpeza, análise e consequente geração de insights acionáveis que informam a tomada de decisão”dbta.com. Ferramentas modernas de BI (e, cada vez mais, módulos de IA) aceleram e automatizam esses passos, reduzindo o tempo entre a chegada dos dados brutos e o apoio à decisão. A Figura 3 ilustra o Fluxo do Processo de Business Intelligence, mostrando as etapas que levam do dado bruto à decisão estratégica.

5.2 Integração da IA no Tratamento e Análise de Dados (Dados -> Informação)

A IA está sendo incorporada fortemente na fase de tratamento de dados, tornando a transição de dado bruto para informação organizada mais eficiente. Técnicas de Machine Learning, Processamento de Linguagem Natural (PLN) e visão computacional podem automatizar tarefas tradicionalmente manuais ou muito complexas:

- Limpeza e Validação Automatizada: Algoritmos de ML aprendem a detectar inconsistências, duplicatas ou valores atípicos em conjuntos de dados, propondo correções ou regras de padronização. Racickas (2024) enfatiza que “dados inadequados podem comprometer modelos de IA, portanto a limpeza é essencial para garantir que os dados de treino sejam precisos”dbta.com. Nesse sentido, a IA pode sugerir automaticamente o preenchimento de valores faltantes ou alertar para incongruências baseadas em padrões históricos.

- Extração e Enriquecimento: Técnicas de PLN extraem entidades (como nomes, endereços, sentimentos) de textos livres (e-mails, relatórios, redes sociais), convertendo dados não estruturados em informação categorizada. Reconhecimento de imagem (visão computacional) pode, por exemplo, classificar fotos de recibos ou verificar notas fiscais digitalizadas, tornando esses dados incorporáveis ao fluxo analítico. Dessa forma, fontes diversas (texto, imagens, vídeo) são traduzidas em vetores informacionais.

- Identificação de Padrões e Criação de Atributos (Features): A IA pode sugerir automaticamente novas variáveis (features) com base em correlações implícitas nos dados. Por exemplo, pode identificar clusters de clientes ou segmentações semânticas que seriam custosas de definir manualmente, apoiando a modelagem preditiva subsequente. Além disso, algoritmos de data wrangling usam técnicas de semelhança e aprendizado para aprimorar pipelines de transformação (Chu et al., 2016). O resultado é que o processo de ETL torna-se parcialmente “assistido por IA”, aumentando a qualidade da informação extraída e permitindo explorar fontes mais diversas e menos estruturadas.

Ao integrar IA às etapas de preparação, organizações elevam a robustez e velocidade do pipeline de dados. Isso garante que a informação disponibilizada seja mais fidedigna e rica, reduzindo falhas típicas de processamento manual. Em última análise, a IA nesta fase amplia o volume de dados que pode ser tratado sem intervenção humana direta, otimizando o esforço de obtenção de insights.

5.3 IA no Apoio à Decisão (Informação -> Decisão)

No apoio direto à tomada de decisão, a Inteligência Artificial (IA) transcende o relato descritivo, aprimorando significativamente as capacidades analíticas. Ela possibilita a condução de análises diagnósticas para entender causas, preditivas para antever tendências e prescritivas para recomendar ações. Modelos de Machine Learning, por exemplo, realizam análises preditivas cruciais para forecasting de vendas, previsão de evasão de clientes ou demanda de estoque, transformando a inteligência de negócios convencional em uma abordagem mais proativa. Algoritmos de descoberta de padrões identificam correlações complexas e ocultas nos dados, gerando insights que podem não ser óbvios em análises manuais e ajudando executivos a reconhecer riscos e oportunidades latentes.

Adicionalmente, métodos de IA criam sistemas de recomendação que sugerem a “próxima melhor ação”, oferecendo recomendações embasadas para estratégias de marketing, investimentos ou ajustes operacionais, baseadas em dados históricos e perfis. Algoritmos de otimização auxiliam na resolução de problemas de recursos limitados, encontrando soluções ideais para alocação de orçamentos ou planejamento logístico, apresentando opções de decisão com melhor custobenefício. Essas capacidades convertem informação em vantagem competitiva, permitindo que as organizações ajam de forma mais proativa e fundamentada com base em previsões precisas e recomendações embasadas. Em síntese, assim como Racickas (2024) destaca que o tratamento de dados gera insights acionáveis, a fase de decisão suportada por IA amplia esse potencial, executando análises complexas em alta velocidade e diminuindo incertezas.

5.4 Aplicações Específicas da IA na Auditoria de Dados

A Inteligência Artificial (IA) tem revolucionado a auditoria de dados e a detecção de fraudes, proporcionando ganhos significativos em eficiência e alcance. Sistemas de IA destacamse na detecção avançada de anomalias, monitoramento em tempo real e análise preditiva, transformando o gerenciamento de riscos, conforme apontam especialistas da Wolters Kluwer (TeamMate) (2025). Modelos de IA analisam grandes volumes de transações financeiras, padrões de comportamento e fatores de risco externos para identificar anomalias sutis que passariam despercebidas pelos sistemas tradicionais (wolterskluwer.com). Isso aumenta a eficácia da auditoria, permitindo a detecção de fraudes de forma mais ágil e com menos falsos positivos. Além disso, técnicas de Machine Learning possibilitam a análise preditiva de risco com base em dados históricos, priorizando áreas de maior probabilidade de irregularidades e otimizando a alocação de esforços dos auditores.

A IA também automatiza testes de conformidade, verificando automaticamente grandes volumes de registros contra regras de negócio e regulatórias, sinalizando violações e liberando auditores para tarefas de maior valor analítico. Ferramentas de Processamento de Linguagem Natural (PLN) auxiliam na análise de documentos como contratos e políticas, extraindo informações relevantes e verificando consistência. Apesar dos vastos benefícios, é crucial ressaltar a necessidade de supervisão humana para validar resultados, considerar aspectos éticos e garantir a explicabilidade das decisões da IA (TeamMate, 2025). Contudo, a capacidade da IA de processar dados massivos com alto grau de automação a posiciona como uma ferramenta essencial para o futuro da auditoria.

6. CONCLUSÃO

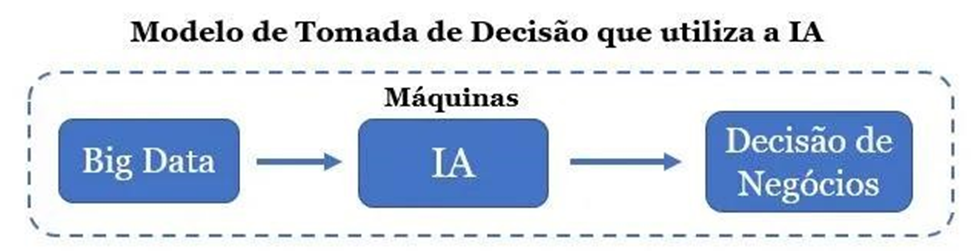

A gestão de dados em organizações passou por uma evolução contínua, impulsionada pelo aumento exponencial da informação disponível. As planilhas eletrônicas, embora democráticas e fundamentais em seu tempo, demonstraram limitações ao lidar com volumes crescentes e demandas analíticas complexas. Reconhecendo essas restrições, surgiu o BI como disciplina capaz de transformar dados brutos em conhecimento acionável. Ferramentas modernas de BI, como o Microsoft Power BI, superaram barreiras tecnológicas anteriores ao oferecer conectividade nativa, modelagem relacional avançada, processamento de grandes volumes e visualizações interativas. Paralelamente, os processos clássicos de ETL evoluíram para abordagens modernas (inclusive ELT e ferramentas self-service) capazes de entregar resultados ágeis e adaptáveis ao Big Data. Assim, a evolução das ferramentas de dados, do BI ao ETL moderno, aprimora a jornada para a decisão estratégica, um fluxo representado na Figura 4, evidenciando a participação da Inteligência Artificial.

A jornada tecnológica avança com a incorporação da inteligência artificial, que automatiza tratamentos e enriquece a análise de dados. A IA apoia diretamente a decisão com previsões e recomendações, sendo crucial em áreas como auditoria para detecção de anomalias e fraudes. Este artigo apresentou a evolução das planilhas ao BI assistido por IA, mostrando como os avanços tecnológicos fundamentam decisões baseadas em dados. A próxima fronteira é a inteligência cognitiva, com sistemas autoadaptativos buscando maior eficácia na tomada de decisão.

REFERÊNCIAS

ARQUITETURA CLÁSSICA DE BI/ETL. 2019. Disponível em: https://www.google.com/search?q=https://www.itigoconsulting.com/wpcontent/uploads/2019/08/Arquitetura-BI.jpg. Acesso em: 27 abr. 2025.

CCS LEARNING ACADEMY. Power BI vs Excel: Top 10 Differences Explained. 30 maio 2024. Disponível em: https://www.ccslearningacademy.com/power-bi-vs-excel/. Acesso em: 11 mai. 2025.

CHU, Xia; ILYAS, Ihab F.; KRISHNAN, Surajit et al. Data Cleaning: Overview and Emerging Challenges. In: Proceedings of the 2016 International Conference on Management of Data (SIGMOD ’16), New York: ACM, 2016. p. 2201–2206.

COMO FUNCIONA O PROCESSO DE BI. [20–?]. Disponível em: https://www.google.com/search?q=https://th.bing.com/th/id/R.0bc41c70a94f271145c4a4d337070418%3Frik%3DynkbVzFunktNpw%26pid%3DImgRaw%26r%3D0. Acesso em: 27 abr. 2025.

COLSON, Eric. Modelo de Tomada de Decisão que utiliza a IA. [2020]. Disponível em: https://neigrando.com/wp-content/uploads/2020/09/modelo-de-tomada-de-decisao-que-utiliza-aia.jpg?w=637. Acesso em: 27 abr. 2025.

EXEMPLO DE DASHBOARD NO POWER BI. 2020. Disponível em: https://www.google.com/search?q=https://expertdigital.net/wp-content/uploads/2020/02/O-que%25C3%25A9-o-Power-BI.png.webp. Acesso em: 27 abr. 2025.

INMON, W. H. Building the Data Warehouse. 4. ed. Hoboken, New Jersey: Wiley, 2005.

KIMBALL, Ralph; ROSS, Margy. The Data Warehouse Toolkit: The Definitive Guide to Dimensional Modeling. 3. ed. Hoboken, New Jersey: Wiley, 2013.

OLSZAK, Celina M.; ZIEMBA, Elżbieta. Critical Success Factors for Business Intelligence Implementation in Poland. Interdisciplinary Journal of Information, Knowledge, and Management, v. 7, p. 129–150, 2012.

POWELL, Gregory. Beginning Excel VBA Programming: A concise guide to developing Excel VBA applications. Berkeley, CA: Apress, 2010.

POWELL, Stephen G.; BAKER, Kenneth R.; LAWSON, Barry. Errors in operational spreadsheets. Journal of Organizational and End User Computing, v. 21, n. 3, p. 24–36, 2009.

RACICKAS, Lukas. The Critical Role of Data Cleaning. Database Trends and Applications (Big Data Quarterly), 16 jul. 2024. Disponível em: https://www.dbta.com/BigDataQuarterly/Articles/The-Critical-Role-of-Data-Cleaning-164941.aspx. Acesso em: 11 mai. 2025.

RIVERY. ETL vs ELT: Key Differences. 2024. Disponível em: https://rivery.io/blog/etl-vs-elt/. Acesso em: 27 abr. 2025.

SANTOS, Elídio A.; RAMOS, Luiz A. Business Intelligence: Análise de Dados. Revista Eletrônica Sistemas & Gestão, v. 1, n. 1, p. 30–38, 2006.

SCOREPLAN. Planilhas ou ferramentas para a gestão empresarial? 2024. Disponível em: https://scoreplan.com.br/planilhas-ou-ferramentas-para-a-gestao/. Acesso em: 27 abr. 2025.

TEAMMATE (Wolters Kluwer). O papel da auditoria interna na detecção de fraudes com IA. TeamMate Expert Insights – Compliance, 14 abr. 2025. Disponível em: https://www.wolterskluwer.com/pt-br/expert-insights/internal-audits-role-ai-fraud-detection. Acesso em: 11 mai. 2025.

WEBB, Chris. Power Query for Power BI and Excel. Berkeley, CA: Apress, 2014.

MICROSOFT. What is Power Query? Microsoft Learn – Power Query Documentation, 2025. Disponível em: https://learn.microsoft.com/en-us/power-query/power-query-what-is-power-query. Acesso em: 11 mai. 2025.

¹ Lanna Eduarda Pimenta Feitoza – Estudante da Faculdade FUCAPI.

² Paulino Wagner Palheta Viana – Professor Doutor da Faculdade FUCAPI