EMOTISCAN: A COMPUTATIONAL TOOL FOR IDENTIFYING FACIAL GESTURES IN THE CONTEXT OF NEUROMARKETING

REGISTRO DOI: 10.69849/revistaft/ma10202601221849

Ana Eduarda Feijó1

Isabella Soares Couto1

Haron Terentin de Misquita1

Carlos Enrique Lopez Noriega2

Resumo

O presente estudo teve como objetivo desenvolver e validar o EmotiScan, um sistema automatizado de reconhecimento de expressões faciais baseado em visão computacional, destinado a apoiar análises de neuromarketing. A solução foi construída com base em fundamentos teóricos como o Facial Action Coding System (FACS), combinando detecção de rostos por Haar Cascade e classificação emocional por transferência de aprendizado utilizando a arquitetura MobileNetV2. O conjunto FER2013, composto por 35.887 imagens pré-processadas, serviu como base para o treinamento do modelo, conduzido no Google Colab com GPU NVIDIA Tesla T4 e CPU Intel Xeon. O processo envolveu padronização das imagens, acompanhamento das curvas de acurácia e perda e avaliação do comportamento do modelo ao longo das épocas. Os resultados mostraram 75,60% de acurácia de treino e cerca de 64,89% de acurácia de validação, desempenho que indica aprendizado efetivo, ainda que com sinais de sobreajuste. Em testes práticos e em uma pesquisa de percepção com 13 participantes, o sistema demonstrou boa aceitação, com nota média 8,2 e percepção de acerto de 77%. O protótipo foi disponibilizado em ambiente AWS, com estimativas de custo e registro de eventos frame a frame, seguindo princípios de privacidade e conformidade com a LGPD. Desta forma o EmotiScan representa uma alternativa viável, acessível e não invasiva para estudos emocionais no neuromarketing, embora melhorias de generalização e mitigação de vieses ainda sejam necessárias para aplicações em larga escala.

Palavras-chave: Neuromarketing. Visão computacional. Expressões faciais. Aprendizado de máquina.

Abstract

The present study aimed to develop and validate EmotiScan, an automated facial expression recognition system based on computer vision designed to support neuromarketing analyses. The solution was built upon theoretical foundations such as the Facial Action Coding System (FACS), combining face detection through Haar Cascade with emotion classification using transfer learning on the MobileNetV2 architecture. The FER2013 dataset, composed of 35,887 preprocessed images, served as the basis for model training, conducted on Google Colab using an NVIDIA Tesla T4 GPU and an Intel Xeon CPU. The process included image standardization, monitoring of accuracy and loss curves, and evaluation of the model’s behavior across epochs. Results showed 75.60% training accuracy and approximately 64.89% validation accuracy, indicating effective learning despite signs of overfitting. In practical testing and a perception survey with 13 participants, the system demonstrated strong acceptance, with an average rating of 8.2 and a perceived accuracy of 77%. The prototype was deployed on AWS, including cost estimates and frame-by-frame event logging, while following privacy principles and LGPD compliance. In conclusion, EmotiScan represents a viable, accessible, and non-invasive alternative for emotional analysis in neuromarketing, although improvements in generalization and bias mitigation remain necessary for large-scale applications.

Keywords: Neuromarketing. Computer vision. Facial Expressions. Machine learning

1 INTRODUÇÃO

As expressões faciais são uma forma relevante de comunicação não verbal, permitindo a identificação de estados emocionais sem o uso de linguagem verbal (Ekman, 1999). No contexto da Inteligência Artificial, a Visão Computacional tem papel central no reconhecimento de padrões em imagens, possibilitando a análise automatizada de características faciais e a classificação de emoções a partir desses dados (Rawnaque et al., 2020; Whalen et al., 2013).

Os estudos sobre expressões faciais possuem base consolidada, desde as observações iniciais de Darwin (1872) até os trabalhos de Ekman e Friesen (1978). Um dos principais referenciais técnicos da área é o Facial Action Coding System (FACS), que descreve sete emoções básicas, alegria, tristeza, raiva, medo, surpresa, nojo e desprezo, com base em unidades de movimento facial (Cherubino et al., 2019). Esse modelo serve como fundamento para sistemas automatizados de reconhecimento emocional.

Com os avanços na capacidade de processamento e no desenvolvimento de algoritmos de machine learning, soluções de reconhecimento facial tornaram-se mais precisas e viáveis em tempo real (Onyema et al., 2021; Rawnaque et al., 2020). Nesse cenário, o neuromarketing utiliza dados emocionais para apoiar a análise do comportamento do consumidor e a avaliação de estímulos digitais (Fugate, 2007; Chung et al., 2012).

Apesar da evolução da área, métodos tradicionais de mensuração emocional ainda apresentam limitações técnicas e operacionais, como alto custo, necessidade de especialistas e o uso de abordagens invasivas, o que restringe sua aplicação em ambientes acadêmicos e empresariais (Bakardjieva; Kimmel, 2016; Stanton et al., 2017; Stoica et al., 2015). Além disso, a codificação manual de expressões faciais está sujeita a subjetividade, dificuldades de padronização e limitações no reconhecimento em tempo real (Dragoi, 2021; Zhang; Arandjelovic, 2021).

Diante desse contexto, este trabalho tem como objetivo explorar o uso da Visão Computacional como ferramenta técnica de apoio à análise de expressões faciais no neuromarketing. Propõe-se o desenvolvimento de um sistema automatizado capaz de identificar e classificar emoções a partir de câmeras convencionais e algoritmos de machine learning, gerando dados estruturados para análise posterior.

O estudo foi conduzido em ambiente de laboratório controlado, com captura das expressões faciais de participantes durante a interação com anúncios digitais. O delineamento adotado é quantitativo, exploratório e experimental, com controle do tempo de exposição aos estímulos. Os dados gerados pelo sistema foram anonimizados em conformidade com a Lei Geral de Proteção de Dados (LGPD) e armazenados em arquivos .txt, permitindo a identificação de padrões emocionais sem associação direta aos indivíduos.

2 METODOLOGIA

O EmotiScan foi desenvolvido para operar em tempo real, estruturado em duas etapas principais: (i) detecção facial e (ii) classificação emocional. A detecção de rostos foi realizada por meio do classificador Haar Cascade da biblioteca OpenCV, selecionado pelo baixo custo computacional e viabilidade de uso em cenários controlados. As regiões faciais detectadas foram recortadas, redimensionadas e padronizadas antes de serem submetidas ao classificador.

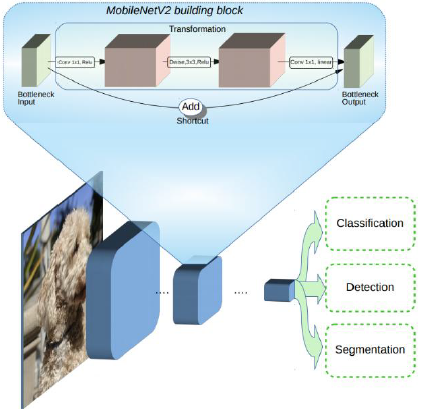

A classificação das expressões faciais foi implementada por meio de transferência de aprendizado com a arquitetura MobileNetV2 (Figura 1), previamente treinada no ImageNet (Sandler et al., 2018). Essa escolha visou equilibrar desempenho e eficiência computacional, permitindo inferência em tempo real em ambiente web.

Figura 1 – Visão geral da arquitetura MobileNetV2.

Fonte: Sandler et al. (2018)

2.1. Base de dados e treinamento

O treinamento e a validação do modelo utilizaram a base FER2013, composta por 35.887 imagens distribuídas em sete classes emocionais. As imagens passaram por pré-processamento padronizado, incluindo recorte facial, redimensionamento para 224 × 224 pixels e conversão para escala de cinza. Do total, 80% das imagens foram destinadas ao treinamento e 20% à validação.

O treinamento foi realizado em Python, com TensorFlow e Keras, utilizando o otimizador Adam com taxa de aprendizado de 1e-4 e estratégia de parada antecipada baseada na perda de validação. Os experimentos foram conduzidos no Google Colaboratory, com uso de GPU NVIDIA Tesla T4, resultando em redução significativa do tempo de treinamento em relação à execução em CPU.

2.2. Implantação e protocolo experimental

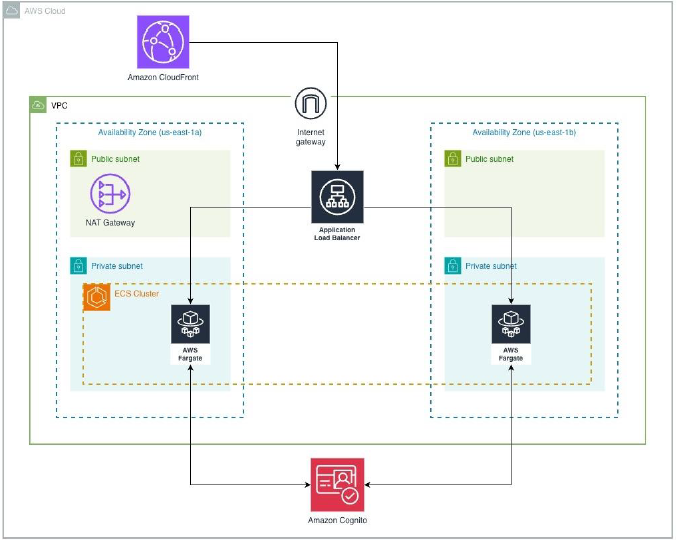

Conforme apresentado na figura 2, a aplicação foi implantada na Amazon Web Services (AWS), utilizando contêineres gerenciados pelo Amazon ECS com AWS Fargate, balanceamento de carga e distribuição via CloudFront. O streaming de vídeo da webcam foi viabilizado por meio do protocolo WebRTC, utilizando a biblioteca streamlit-webrtc, com suporte dos serviços STUN/TURN da Twilio.

Figura 2 – Diagrama de arquitetura do software

Fonte: Autoria própria (2025)

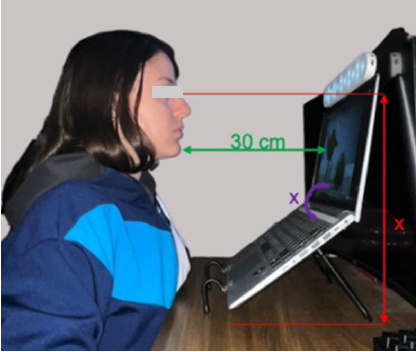

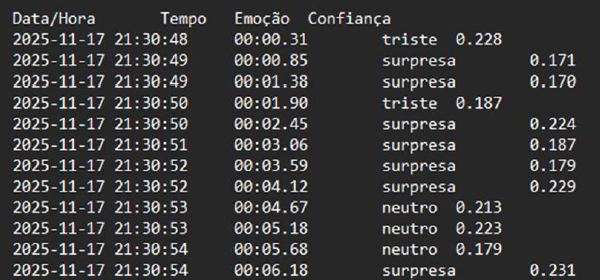

O experimento foi realizado em ambiente controlado e remoto, com captura das expressões faciais durante a exposição dos participantes a um vídeo publicitário. As aquisições utilizaram câmera RGB (1080p, 30 fps), posicionada frontalmente sob iluminação uniforme (Figura 3). A Figura 4 apresenta um recorte dos arquivos .txt gerados pelo sistema, nos quais são registrados, de forma estruturada, a data e hora da captura, o tempo relativo ao estímulo, a emoção classificada e o valor de confiança associado. Esse formato possibilita análises quantitativas e temporais das reações emocionais posteriormente, preservando a anonimização dos participantes, uma vez que não há armazenamento de imagens ou identificadores individuais.

Figura 3 – Especificação da posição e caracterização do ambiente

Fonte: Autoria própria (2025)

Figura 4 – Resultado de processamento exportado em arquivo .txt

Fonte: Autoria própria (2025)

3 RESULTADOS E DISCUSSÃO

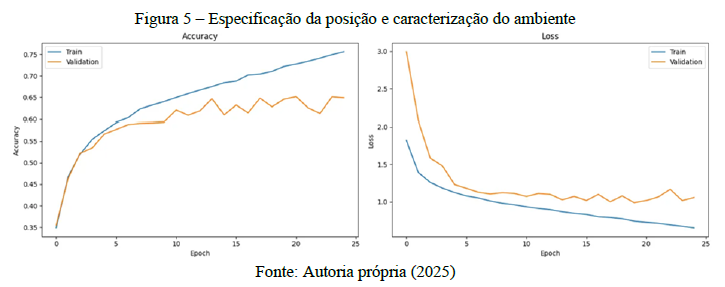

O desempenho do modelo foi avaliado por meio da acurácia e da função de perda, conforme a figura 5. Como referência, consideraram-se dois baselines: um classificador aleatório, com acurácia teórica de 14,2%, e a previsão constante da classe majoritária, com 24,7%. O modelo treinado superou ambos, indicando aprendizado dos padrões faciais.

A acurácia no conjunto de treinamento atingiu 75,60%, enquanto a validação estabilizou em aproximadamente 64,89% após cerca de dez épocas. A divergência progressiva entre treino e validação, acompanhada de oscilações na perda, indica a presença de sobreajuste e limitações na capacidade de generalização.

3.1. Desempenho do modelo proposto utilizando detecção facial com o algoritmo Haar

Cascade

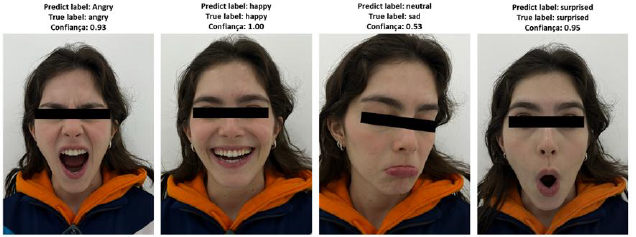

Observa-se melhor desempenho na identificação de emoções mais evidentes, como felicidade, raiva e surpresa. Em contrapartida, emoções mais sutis, como tristeza, apresentaram maior taxa de confusão, sendo frequentemente classificadas como neutras (Figura 6). Esse comportamento está associado tanto à natureza menos expressiva dessas emoções quanto às limitações do pré-processamento e da detecção facial baseada em Haar Cascade.

Figura 6 – Resultados de predição obtidos com o algoritmo Haar Cascade

Fonte: Autoria própria (2025)

3.2. Estudo exploratório e percepção dos usuários

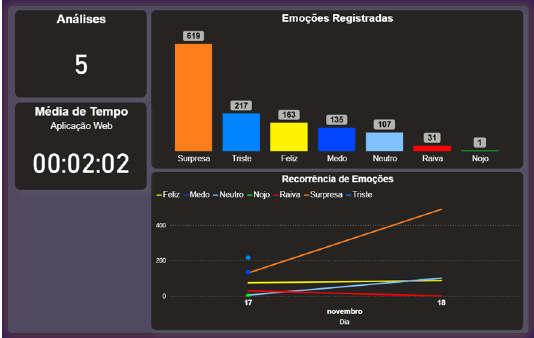

Os dados gerados pelos usuários que testaram a aplicação, apresentados na figura 7, indicaram predominância da emoção surpresa, frequentemente associada à atenção e ao engajamento diante do estímulo apresentado. Emoções negativas, como medo e tristeza, ocorreram em menor escala, enquanto raiva e nojo apresentaram baixa incidência. A análise temporal das emoções permitiu identificar com precisão os momentos associados a determinadas reações emocionais.

Figura 7 – Dashboard de Análise Temporal das Emoções Detectadas

Fonte: Autoria própria (2025)

A avaliação de usabilidade contou com 13 participantes. A aplicação obteve nota média de 8,2 para facilidade de uso e clareza da interface, e 77% dos usuários consideraram a precisão satisfatória. Todos indicaram potencial de uso da ferramenta em contextos profissionais, reforçando sua aplicabilidade prática.

4 CONSIDERAÇÕES FINAIS

O desenvolvimento do EmotiScan permitiu demonstrar, de forma clara, que é possível criar uma ferramenta capaz de reconhecer expressões faciais e auxiliar análises de neuromarketing de maneira acessível e não invasiva. A metodologia adotada, baseada em detecção facial por Haar Cascade, classificação com MobileNetV2 e treinamento com a base

FER2013, mostrou-se adequada para os objetivos propostos. Os resultados de desempenho, com 75,60% de acurácia no treino e cerca de 64,89% na validação, revelaram que o modelo foi capaz de aprender padrões emocionais relevantes, embora tenha apresentado sinais de sobreajuste ao longo das épocas. As curvas de acurácia e perda, mostraram um comportamento coerente: emoções mais evidentes, como felicidade e surpresa, foram reconhecidas com maior segurança, enquanto emoções mais sutis, como tristeza, apresentaram maior grau de confusão.

Os testes práticos reforçaram esses achados. O dashboard temporal (figura 11) permitiu visualizar, de maneira intuitiva, como as emoções variavam ao longo dos estímulos publicitários apresentados. Essa visualização ajudou a compreender não apenas quais emoções eram detectadas, mas também em que momento elas surgiam, oferecendo um recurso valioso para análises de campanhas. Além disso, a pesquisa de percepção com os participantes indicou boa aceitação do sistema, com nota média de 8,2 e percepção de acerto próxima a 77%.

Ao mesmo tempo, alguns limites do sistema ficaram evidentes. A acurácia de validação mostra que o modelo ainda não generaliza bem para condições variadas, como diferentes iluminações, ângulos do rosto e diversidade de aparência. Emoções sutis também se mostraram mais difíceis de detectar de forma consistente, o que indica que o pré-processamento e a própria arquitetura podem estar perdendo sinais faciais importantes. Outro ponto que merece atenção é a escalabilidade: embora a estrutura na AWS tenha se mostrado funcional e com custo razoável em pequena escala, seria necessário otimizar processos para atender cenários com mais usuários simultâneos sem comprometer latência ou custo.

Diante desses resultados, tornam-se claras algumas direções de melhoria. A ampliação e diversificação da base de dados de treinamento é essencial para reduzir vieses e melhorar a generalização. Arquiteturas mais avançadas, como modelos com módulos de atenção, podem ajudar a melhorar o reconhecimento de expressões sutis. Ajustes no pré-processamento, como uso de landmarks faciais ou técnicas de super-resolução, podem preservar mais detalhes importantes do rosto. Além disso, testes com um número maior de participantes e em situações mais próximas de cenários reais fortaleceriam as evidências de aplicabilidade do sistema.

Em síntese, o EmotiScan cumpriu seu papel como prova de conceito: apresentou resultados compatíveis com o estado da arte, foi bem recebido pelos usuários e evidenciou potencial real para apoiar estudos de neuromarketing em diferentes contextos e aplicações profissionais. Ao mesmo tempo, deixou claro quais caminhos devem ser seguidos para evoluir de um protótipo funcional para uma solução madura, confiável e capaz de operar em larga escala, respeitando princípios éticos e garantindo diversidade e precisão nas análises emocionais.

REFERÊNCIAS

BAKARDJIEVA, Elitza; KIMMEL, Allan J. Neuromarketing research practices: attitudes, ethics, and behavioral intentions. Ethics & Behavior, v. 27, n. 3, p. 179–200, 2016. Disponível em: https://doi.org/10.1080/10508422.2016.1162719. Acesso em: 16 set. 2025.

CHERUBINO, Patrizia; MARTINEZ-LEVY, Ana C.; CARATÙ, Myriam; et al. Consumer behaviour through the eyes of neurophysiological measures: state-of-the-art and future trends. Computational Intelligence and Neuroscience, v. 2019, n. 1, p. 1–41, 2019. Disponível em: https://www.hindawi.com/journals/cin/2019/1976847/. Acesso em: 11 abr. 2025.

COUTO, Isabella Soares; FEIJO, Ana Eduarda; MISQUITA, Haron Terentin; NORIEGA, Carlos Lopez. Identificação de gestos faciais com visão computacional: proposta aplicada ao neuromarketing. Revista Delos. Disponível em: https://ojs.revistadelos.com/ojs/index.php/delos/article/view/6561/3576. Acesso em: 11 set. 2025.

DARWIN, Charles. The expression of the emotions in man and animals. London: John Murray, 1872. Disponível em: http://dx.doi.org/10.1037/10001-000. Acesso em: 15 mar. 2025.

DRAGOI, Denisa Adriana. Facial coding as a neuromarketing technique: an overview. Ovidius University Annals: Economic Sciences Series, v. XXI, n. 2, p. 681–687, 2021. Disponível em: https://doaj.org/article/437d39c79cb1412ea03d680b0af626af. Acesso em: 17 set. 2025.

EKMAN, Paul. Basic emotions. Handbook of Cognition and Emotion, p. 45–60, 1999. Disponível em: https://onlinelibrary.wiley.com/doi/10.1002/0470013494.ch3. Acesso em: 17 jun. 2025.

EKMAN, Paul; FRIESEN, Wallace V. Facial Action Coding System. Environmental Psychology & Nonverbal Behavior, 1978. Disponível em: https://doi.org/10.1037/t27734-000. Acesso em: 17 jun. 2025.

FUGATE, Douglas L. Neuromarketing: a layman’s look at neuroscience and its potential application to marketing practice. Journal of Consumer Marketing, v. 24, n. 7, p. 385–394, 2007. Disponível em: https://doi.org/10.1108/07363760710834807. Acesso em: 10 mar. 2025.

ONYEMA, Edeh Michael; SHUKLA, Piyush Kumar; DALAL, Surjeet; et al. Enhancement of patient facial recognition through deep learning algorithm: ConvNet. Journal of Healthcare Engineering, 2021. Disponível em: https://www.hindawi.com/journals/jhe/2021/5196000/. Acesso em: 13 jun. 2025.

RAWNAQUE, Ferdousi Sabera; RAHMAN, Khandoker Mahmudur; ANWAR, Syed Ferhat; et al. Technological advancements and opportunities in neuromarketing: a systematic review. Brain Informatics, v. 7, n. 1, 2020. Disponível em: https://doi.org/10.1186/s40708020-00109-x. Acesso em: 28 abr. 2025.

SANDLER, Mark; HOWARD, Andrew. MobileNetV2: the next generation of on-device computer vision networks. Google Research. Disponível em: https://research.google/blog/mobilenetv2-the-next-generation-of-on-device-computer-visionnetworks/. Acesso em: 3 abr. 2025.

STANTON, Steven J.; SINNOTT-ARMSTRONG, Walter; HUETTEL, Scott A. Neuromarketing: ethical implications of its use and potential misuse. Journal of Business Ethics, v. 144, n. 4, p. 799–811, 2016. Disponível em: https://doi.org/10.1007/s10551-016-3059-0. Acesso em: 17 set. 2025.

STOICA, Ion; POPESCU, Mihail; ORZAN, Mihai. Consumer preferences for organic food: a case study of neuromarketing methods and tools. CABI Digital Library. Disponível em: https://www.cabidigitallibrary.org/doi/full/10.5555/20153436448. Acesso em: 12 mar. 2025.

TWILIO. Network Traversal Service. Twilio. Disponível em: https://www.twilio.com/docs/stun-turn. Acesso em: 15 nov. 2025.

WHALEN, Paul J.; RAILA, Hannah; BENNETT, Randi; et al. Neuroscience and facial expressions of emotion: the role of amygdala–prefrontal interactions. Sage Journals, v. 5, n. 1, p. 78–83, 2013. Disponível em: https://doi.org/10.1177/1754073912457231. Acesso em: 13 jun. 2025.

ZHANG, Liangfei; ARANDJELOVIĆ, Ognjen. Review of automatic microexpression recognition in the past decade. Machine Learning and Knowledge Extraction, v. 3, n. 2, p. 414–434, 2021. Disponível em: https://www.mdpi.com/2504-4990/3/2/21. Acesso em: 17 set. 2025.

1Discente do Curso Superior de engenharia de computação da Faculdade Engenheiro Salvador Arena Campus São Bernardo do Campo

2Docente do Curso Superior de engenharia de computação da Faculdade Engenheiro Salvador Arena Campus São Bernardo do Campo. Doutor em neurociências (USP)